LlamaIndex vs LangChain: Comparación de poderosos marcos de aplicación LLM

Published on

Introducción

En el mundo del procesamiento del lenguaje natural (PLN) y los modelos de lenguaje grandes (LLMs), los desarrolladores buscan constantemente herramientas poderosas para construir aplicaciones de vanguardia. Dos marcos prominentes han surgido como líderes en este campo: LlamaIndex y LangChain. Si bien ambos tienen como objetivo simplificar la integración de LLMs en aplicaciones personalizadas, difieren en su enfoque y enfoque. En este artículo, profundizaremos en las principales diferencias entre LlamaIndex y LangChain, lo que le ayudará a tomar una decisión informada al elegir un marco para sus proyectos.

Parte 1. ¿Qué es LlamaIndex?

LlamaIndex es un marco de datos poderoso que le permite conectar fácilmente sus propios datos a LLMs. Proporciona conectores de datos flexibles para ingestar datos de una variedad de fuentes como API, bases de datos, PDF y más. Estos datos privados se indexan en representaciones optimizadas a las que los LLMs pueden acceder e interpretar a gran escala, sin necesidad de volver a entrenar el modelo subyacente.

LlamaIndex capacita a los LLMs con una "memoria" de sus datos privados que pueden aprovechar para proporcionar respuestas informadas y contextuales. Ya sea que desee construir un chatbot sobre la documentación de su empresa, una herramienta de análisis de currículum personalizada o un asistente de IA que pueda responder preguntas sobre un dominio de conocimiento específico, LlamaIndex lo hace posible con solo unas pocas líneas de código.

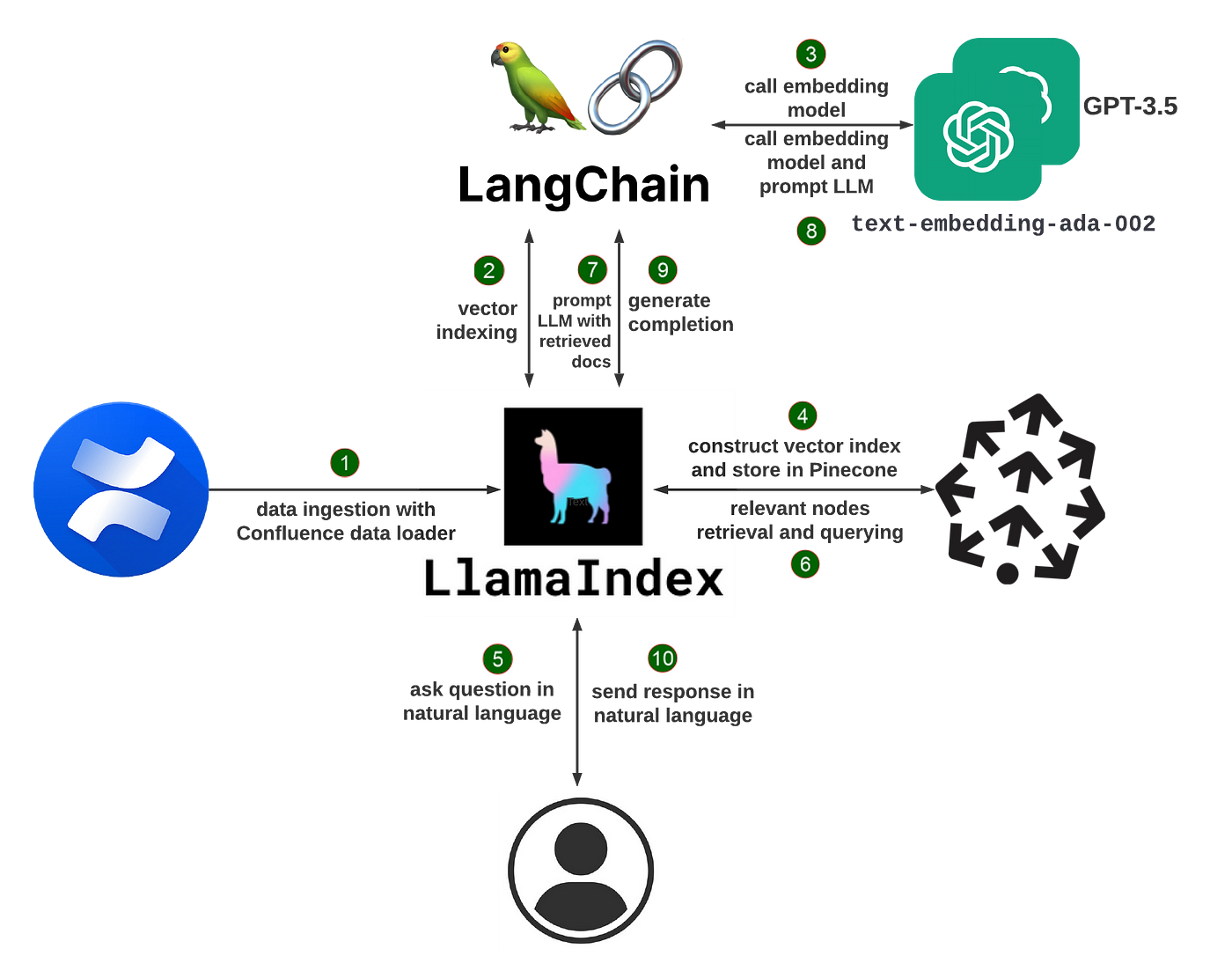

Cómo funciona LlamaIndex

En su núcleo, LlamaIndex utiliza una técnica llamada generación mejorada por recuperación (RAG). Un sistema RAG típico tiene dos etapas clave:

-

Etapa de indexación: durante la indexación, sus datos privados se convierten de manera eficiente en un índice vectorial que se puede buscar. LlamaIndex puede procesar documentos de texto no estructurados, registros de bases de datos estructurados, gráficos de conocimiento y más. Los datos se transforman en incrustaciones numéricas que capturan su significado semántico, lo que permite búsquedas de similitud rápidas más adelante.

-

Etapa de consulta: cuando un usuario realiza una consulta al sistema, se recuperan los fragmentos más relevantes de información del índice vectorial en función de la similitud semántica de la consulta. Estos fragmentos, junto con la consulta original, se pasan al LLM que genera una respuesta final. Al extraer dinámicamente un contexto pertinente, el LLM puede generar respuestas de mayor calidad y más factuales que solo con su conocimiento básico.

LlamaIndex abstrae gran parte de la complejidad de construir un sistema RAG. Ofrece tanto APIs de alto nivel que le permiten comenzar con solo unas pocas líneas de código, como bloques de construcción de bajo nivel para la personalización detallada del canal de datos.

Creación de un chatbot de currículum con LlamaIndex

Para ilustrar las capacidades de LlamaIndex, veamos cómo construir un chatbot que pueda responder preguntas sobre su currículum.

Primero, instale los paquetes necesarios:

pip install llama-index openai pypdfA continuación, cargue su PDF de currículum y cree un índice:

from llama_index import TreeIndex, SimpleDirectoryReader

resumen = SimpleDirectoryReader("ruta/al/currículo").load_data()

índice = TreeIndex.from_documents(resumen)Ahora puede consultar el índice utilizando lenguaje natural:

motor_de_consulta = índice.as_query_engine()

respuesta = motor_de_consulta.query("¿Cuál es el título del trabajo?")

print(respuesta)El motor de consultas buscará el índice del currículum y devolverá el fragmento más relevante como respuesta, por ejemplo, "El título del trabajo es Ingeniero de software".

También puede participar en una conversación de ida y vuelta:

motor_de_chat = índice.as_chat_engine()

respuesta = motor_de_chat.chat("¿Qué hizo esta persona en su último trabajo?")

print(respuesta)

continuación = motor_de_chat.chat("¿Qué lenguajes de programación usaron?")

print(continuación)El motor de chat mantiene el contexto de la conversación, lo que le permite hacer preguntas de seguimiento sin reiterar explícitamente el tema.

Para evitar reconstruir el índice cada vez, puede guardarlo en disco:

contexto_de_almacenamiento.persist()Y cargarlo más tarde:

from llama_index import StorageContext, load_index_from_storage

contexto_de_almacenamiento = StorageContext.from_defaults(persist_dir="./almacenamiento")

índice = load_index_from_storage(contexto_de_almacenamiento)Más allá de los chatbots: casos de uso de LlamaIndex

Los chatbots son solo una de las muchas aplicaciones que puede construir con LlamaIndex. Algunos otros ejemplos incluyen:

- Preguntas y respuestas sobre documentos largos: importe documentos como manuales, contratos legales o documentos de investigación y haga preguntas sobre su contenido.

- Recomendaciones personalizadas: construya índices sobre catálogos de productos o bibliotecas de contenido y proporcione recomendaciones basadas en consultas de usuario.

- Agentes basados en datos: cree asistentes de IA que puedan acceder y realizar acciones en bases de datos, APIs y otras herramientas para completar tareas complejas.

- Construcción de bases de conocimiento: extraiga automáticamente datos estructurados como entidades y relaciones de texto no estructurado para construir gráficos de conocimiento.

LlamaIndex proporciona un conjunto de herramientas flexibles para construir todo tipo de aplicaciones impulsadas por LLM. Puede combinar y combinar cargadores de datos, índices, motores de consulta, agentes y más para crear canalizaciones personalizadas para su caso de uso.

Comenzando con LlamaIndex

Para comenzar a construir con LlamaIndex, primero instale el paquete:

pip install llama-indexTambién necesitará una clave de API de OpenAI para acceder a los modelos subyacentes predeterminados. Configúrelo como una variable de entorno:

import osos.environ["OPENAI_API_KEY"] = "tu_clave_de_api_aquí"

¡A partir de ahí, puedes comenzar a ingresar datos y construir índices! La documentación de LlamaIndex ofrece guías detalladas y ejemplos para casos de uso comunes.

A medida que te adentres más, puedes explorar Llama Hub, una colección de cargadores de datos, índices, motores de consulta y más contribuidos por la comunidad. Puedes utilizar estos complementos tal cual o como punto de partida para tus propios componentes personalizados.

### ¿Qué es LangChain?

LangChain es un marco poderoso para desarrollar aplicaciones impulsadas por modelos de lenguaje. Te permite conectar fácilmente tus propios datos a LLMs y construir aplicaciones de modelos de lenguaje basadas en datos. LangChain proporciona una interfaz estándar para cadenas, muchas integraciones con otras herramientas y cadenas de extremo a extremo para aplicaciones comunes.

Con LangChain, puedes cargar datos de diversas fuentes como documentos, bases de datos, APIs y bases de conocimiento. Estos datos privados son luego accesibles para LLMs durante el tiempo de inferencia, lo que les permite aprovechar ese contexto para brindar respuestas informadas y relevantes. Ya sea que desees construir un chatbot basado en la documentación de tu empresa, una herramienta de análisis de datos o un asistente de IA que interactúe con tus bases de datos y APIs, LangChain lo hace posible.

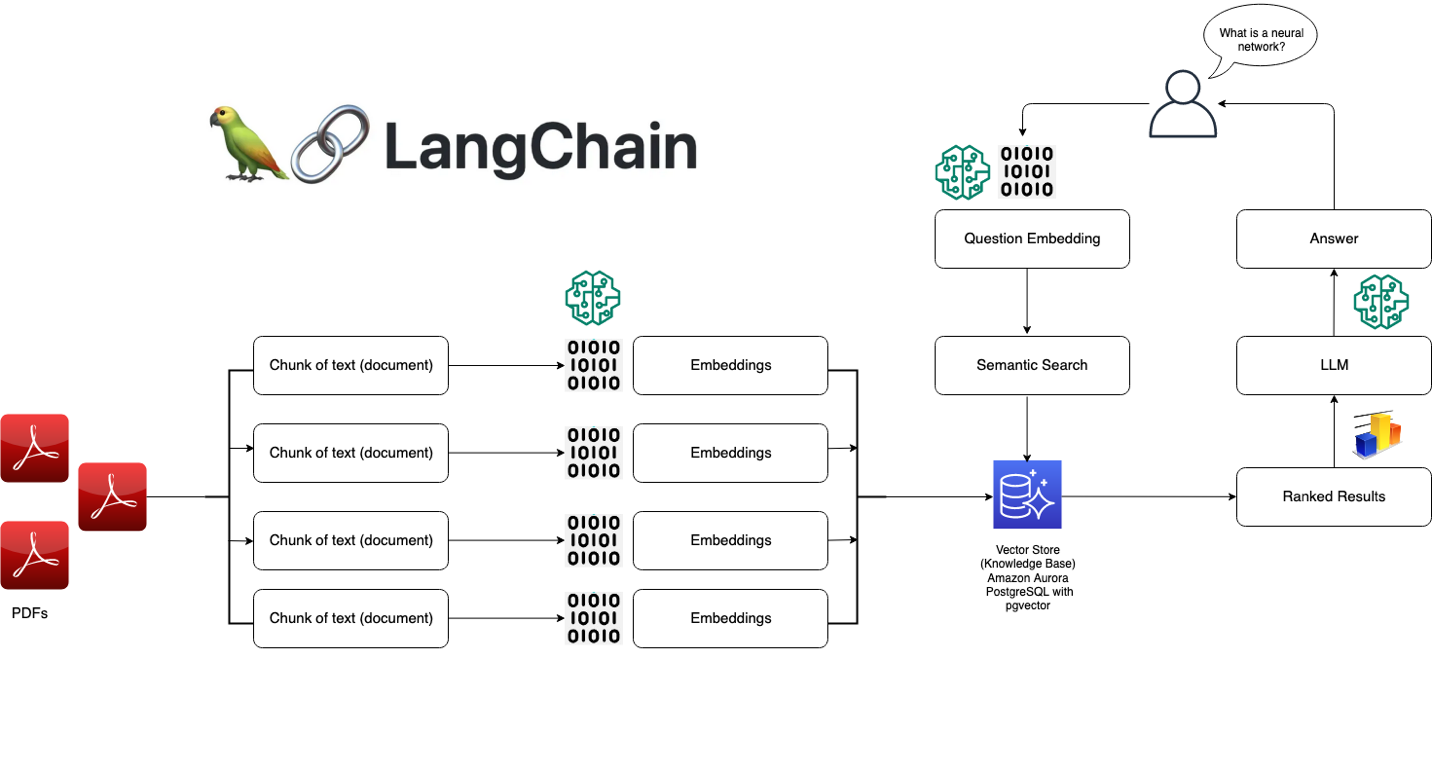

### Cómo funciona LangChain

En su núcleo, LangChain se basa en algunos conceptos clave:

1. Prompts: Los prompts son las instrucciones que le das al modelo de lenguaje para guiar su salida. LangChain proporciona una interfaz estándar para construir y trabajar con prompts.

2. Modelos: LangChain proporciona una interfaz estándar para trabajar con diferentes LLMs y una manera fácil de cambiar entre ellos. Admite modelos como GPT-3 de OpenAI, Claude de Anthropic, los modelos de Cohere y más.

3. Índices: Los índices se refieren a la forma en que los datos textuales se almacenan y se ponen a disposición del modelo de lenguaje. LangChain ofrece varias técnicas de indexación optimizadas para LLMs, como vectorstores y embeddings en memoria.

4. Cadenas: Las cadenas son secuencias de llamadas a LLMs y otras herramientas, donde la salida de un paso es la entrada del siguiente. LangChain proporciona una interfaz estándar para cadenas y muchos componentes reutilizables.

5. Agentes: Los agentes utilizan un LLM para determinar qué acciones tomar y en qué orden. LangChain ofrece una selección de agentes que pueden aprovechar herramientas para llevar a cabo tareas.

Con estos bloques de construcción, puedes crear todo tipo de aplicaciones poderosas basadas en modelos de lenguaje. LangChain abstrae gran parte de la complejidad, permitiéndote centrarte en la lógica de alto nivel de tu aplicación.

### Construcción de un sistema de preguntas y respuestas con LangChain

Para ilustrar las capacidades de LangChain, veamos cómo construir un sistema simple de preguntas y respuestas sobre un conjunto de documentos.

Primero, instala los paquetes necesarios:

pip install langchain openai faiss-cpu

A continuación, carga tus datos y crea un índice:

```python

from langchain.document_loaders import TextLoader

from langchain.indexes import VectorstoreIndexCreator

loader = TextLoader('ruta/a/documento.txt')

index = VectorstoreIndexCreator().from_loaders([loader])Ahora puedes consultar el índice utilizando lenguaje natural:

query = "¿Cuál es el tema principal de este documento?"

result = index.query(query)

print(result)La consulta buscará en el documento y devolverá el fragmento más relevante como respuesta.

También puedes tener una conversación con los datos utilizando una ConversationalRetrievalChain:

from langchain.chains import ConversationalRetrievalChain

from langchain.chat_models import ChatOpenAI

model = ChatOpenAI(temperature=0)

qa = ConversationalRetrievalChain.from_llm(model,retriever=index.vectorstore.as_retriever())

historial_chat = []

while True:

query = input("Humano: ")

result = qa({"question": query, "chat_history": historial_chat})

historial_chat.append((query, result['answer']))

print(f"Asistente: {result['answer']}")Esto permite una conversación de ida y vuelta donde el modelo tiene acceso al contexto relevante de los documentos.

Más allá de las preguntas y respuestas: casos de uso de LangChain

Las preguntas y respuestas son solo una de las muchas aplicaciones que se pueden construir con LangChain. Algunos otros ejemplos incluyen:

- Chatbots: Crear agentes conversacionales que puedan participar en diálogos libres mientras aprovechan datos privados

- Análisis de datos: Conectar LLMs a bases de datos SQL, marcos de datos de pandas y bibliotecas de visualización de datos para la exploración interactiva de datos

- Agentes: Desarrollar agentes de inteligencia artificial que puedan utilizar herramientas como navegadores web, APIs y calculadoras para realizar tareas abiertas

- Generación de aplicaciones: Generar automáticamente aplicaciones completas a partir de especificaciones en lenguaje natural

LangChain proporciona un conjunto flexible de componentes que se pueden combinar de innumerables maneras para crear aplicaciones poderosas basadas en modelos de lenguaje. Puedes utilizar las cadenas y agentes integrados o crear tus propios flujos de trabajo personalizados.

Comenzar con LangChain

Para comenzar a construir con LangChain, primero instala el paquete:

pip install langchainTambién deberás configurar las claves de API necesarias para los modelos y herramientas que deseas utilizar. Por ejemplo, para utilizar los modelos de OpenAI:

import os

os.environ["OPENAI_API_KEY"] = "tu_clave_de_api_aquí"A partir de ahí, puedes comenzar a cargar datos, crear cadenas y construir tu aplicación. La documentación de LangChain proporciona guías detalladas y ejemplos para diversos casos de uso.

A medida que te adentres más, puedes explorar el creciente ecosistema de integraciones y extensiones de LangChain. La comunidad ha construido conectores para innumerables fuentes de datos, herramientas y marcos, lo que facilita la incorporación de LLMs en cualquier flujo de trabajo.

Mejores casos de uso de LlamaIndex vs LangChain

LlamaIndex:

- Construcción de motores de búsqueda y sistemas de recuperación de información

- Creación de bases de conocimiento y bots de preguntas frecuentes

- Análisis y resumen de grandes colecciones de documentos

- Habilitación de búsqueda conversacional y preguntas y respuestas

LangChain:

- Desarrollo de chatbots y agentes conversacionales

- Construcción de tuberías y flujos de trabajo personalizados de PLN

- Integración de LLMs con fuentes de datos externas y APIs

- Experimentación con diferentes elementos de inicio, memoria y configuraciones del agente

LlamaIndex vs LangChain: Elegir el marco adecuado

Al decidir entre LlamaIndex y LangChain, considere los siguientes factores:

-

Requisitos del proyecto: Si su aplicación se centra principalmente en la búsqueda y recuperación, LlamaIndex puede ser más adecuado. Para tareas de PLN más diversas y flujos de trabajo personalizados, LangChain ofrece una mayor flexibilidad.

-

Facilidad de uso: LlamaIndex ofrece una interfaz más simplificada y fácil de usar para principiantes, mientras que LangChain requiere una comprensión más profunda de los conceptos y componentes de PLN.

-

Personalización: La arquitectura modular de LangChain permite una personalización y ajuste extensos, mientras que LlamaIndex ofrece un enfoque más basado en opiniones y optimizado para la búsqueda y recuperación.

-

Ecosistema y comunidad: Ambos marcos tienen comunidades activas y ecosistemas en crecimiento. Considere explorar su documentación, ejemplos y recursos de la comunidad para evaluar el nivel de apoyo y los recursos disponibles.

Conclusión

LlamaIndex y LangChain son marcos poderosos para construir aplicaciones impulsadas por LLM, cada uno con sus propias fortalezas y áreas de enfoque. LlamaIndex destaca en tareas de búsqueda y recuperación, ofreciendo capacidades de indexación y consulta de datos simplificadas. Por otro lado, LangChain adopta un enfoque modular, proporcionando un conjunto flexible de herramientas y componentes para construir diversas aplicaciones de PLN.

Al elegir entre los dos, considere los requisitos de su proyecto, la facilidad de uso, las necesidades de personalización y el soporte ofrecido por sus respectivas comunidades. Independientemente de su elección, tanto LlamaIndex como LangChain permiten a los desarrolladores aprovechar el potencial de los modelos de lenguaje grandes y crear aplicaciones innovadoras de PLN.

Al embarcarse en su viaje de desarrollo de aplicaciones de LLM, no dude en explorar ambos marcos, experimentar con sus características y aprovechar sus fortalezas para construir experiencias de lenguaje natural poderosas y atractivas.