Mistral AI发布颠覆性的8x22B Moe模型:开源人工智能的新时代

Published on

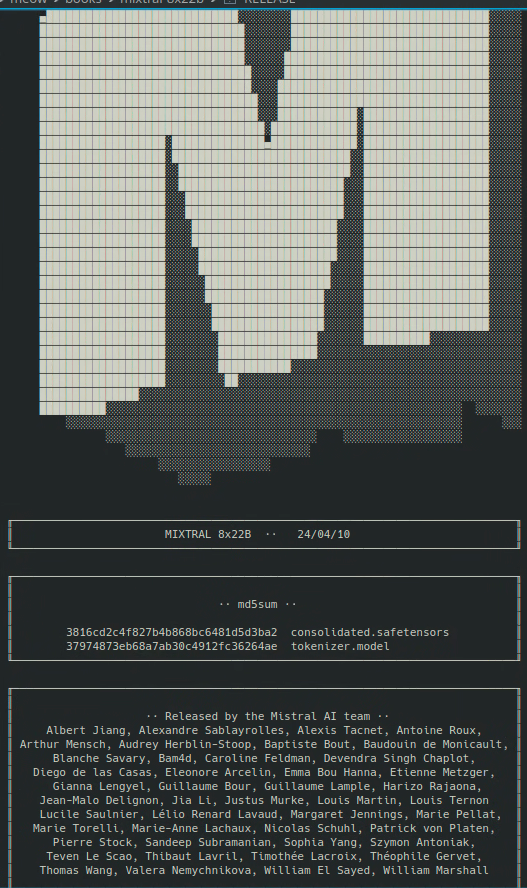

介绍 Mistral 8x22B

Mistral AI刚刚宣布发布备受期待的8x22B Moe模型,这一惊人的发展在人工智能社区引起了震动。这一突破性的成就标志着开源人工智能领域的重要里程碑,因为它承诺提供前所未有的性能和功能,以前被认为是专有模型的独家领域。

开源人工智能的崛起

近年来,人工智能领域正在经历快速转变,强大的开源模型的出现挑战了专有系统的主导地位。这一转变是由对协作和透明在开发人工智能技术中重要性的日益认识驱动的,以及对将这些强大工具普惠化的渴望。

Mistral AI处于这一运动的前沿,他们有提供前沿模型的记录,这些模型不断推动开源人工智能的边界。他们之前发布的备受赞誉的Mixtral 8x7b模型等,广受研究人员和开发人员的好评,为将来更大的突破奠定了基础。

8x22B Moe模型:一个量子飞跃

8x22B Moe模型在开源人工智能的能力方面实现了一个量子飞跃。该模型具有惊人的1300亿参数和预计每次前向传递活跃参数44亿。这个模型真正的独树一帜。以此为参照,8x22B Moe模型的大小超过以前可用的最大开源模型的两倍以上,与一些最先进的专有模型的性能相媲美。

在这里下载Mistral 8x22b磁链:

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce (opens in a new tab)

重要特点和功能

那么,8x22B Moe模型究竟与之前的模型有何不同之处?以下是使这个发布如此激动人心的几个关键特点和功能:

-

无与伦比的语言理解能力:8x22B Moe模型经过大量文本数据的训练,使其能够对自然语言有深入的理解,超越了以往任何一个开源模型。这意味着该模型能够参与更加细致入微和具有情境感知能力的对话,并且可以处理比以往更广泛的任务和应用。

-

增强的推理和问题解决能力:除了语言理解能力之外,8x22B Moe模型还在推理和问题解决任务方面表现出色。这意味着它可以处理需要逻辑思维和推理能力的复杂挑战,例如根据一组事实回答问题或者为开放性问题生成创造性解决方案。

-

提升的效率和可扩展性:尽管体积庞大,8x22B Moe模型经过Mistral AI团队开发的技术创新进行了效率和可扩展性优化。这意味着该模型可以在比以前更广泛的硬件配置上部署和运行,使其更易于全球研究人员和开发人员使用。

对人工智能未来的影响

8x22B Moe模型的发布不仅仅是一个技术成就,也是对人工智能未来的有力表态。通过证明开源模型可以与甚至超越专有系统的性能相媲美,Mistral AI有助于扭转不公平的局面,并确保人工智能的益处能够为所有人所共享。

这对于从医疗保健和教育到金融和交通等各个领域和行业都有深远的影响。凭借8x22B Moe模型和其他开源工具,研究人员和开发人员将能够应对我们今天世界面临的最紧迫的挑战,并创建以前无法想象的新应用和服务。

结论

Mistral AI发布的8x22B Moe模型是人工智能历史上的一个重要时刻。通过推动开源人工智能的边界,这一发布将加速领域中的创新和发现的速度,并为全球的研究人员、开发人员和企业开启新的机会。

展望未来,开源人工智能将在塑造技术进步进程中发挥越来越重要的作用。凭借像8x22B Moe模型这样的工具,我们有能力创建一个更加智能、更加连接、更加公平的世界——一个人工智能的益处被所有人所分享的世界。 请提供对此 Markdown 文件的中文翻译。如果有 Front Matter,请确保将 language 参数翻译成匹配的中文 zh。对于代码部分,请不要翻译代码,只翻译注释部分。请勿翻译样本提示的内容。以下是文件内容:

因此,让我们庆祝这一重大成就,并加倍努力构建人工智能为人类福祉服务的未来。我们共同来利用开源人工智能的力量解决我们时代的最大挑战,并为人类创造一个更加光明、更有希望的明天。

想了解最新的 LLM 新闻吗?请查看最新的 LLM 排行榜!