QA-LoRA:高效微调大型语言模型的指南

Published on

欢迎来到令人着迷的大型语言模型(LLM)的世界!这些计算巨人是许多应用程序的基础,包括聊天机器人、翻译器、内容生成器和推荐系统。尽管它们非常神奇,但部署它们并不容易。计算和内存要求可能令人惊讶,通常需要专门的硬件和大量的耐心。

这就是QA-LoRA发挥作用的地方。这种突破性方法正在改变游戏规则,使LLM的微调和部署变得更加容易和高效。因此,如果您在处理LLM的计算负担方面遇到困难,或者正在寻找一种更智能的微调方法,那你来对地方了。

为什么QA-LoRA是LLM的创新者

想了解最新的LLM新闻吗?查看最新的LLM排行榜!

QA-LoRA到底是什么,它与LoRA有何不同?

在深入了解细节之前,让我们先定义一下我们的主题。QA-LoRA代表Quantization-Aware Low-Rank Adaptation(量化感知低秩自适应)。简单来说,它是一种旨在提高大型语言模型微调效率的方法。现在,你可能会想,“那LoRA又是什么呢?”LoRA代表低秩自适应(Low-Rank Adaptation),是一种旨在减少模型复杂度而保持其性能的技术。QA-LoRA的独特之处在于它具有量化感知方面。

- 量化(Quantization):这是限制函数可能取值的过程。在LLM的背景下,这有助于减小模型的大小。

- 低秩自适应(Low-Rank Adaptation):这涉及到用低维形式近似原始高维数据,使模型的计算代价降低。

因此,当你将这两种方法结合起来时,量化和低秩自适应,你就得到了QA-LoRA,一种既减小了模型大小,又提高了计算效率的方法。这对于在计算资源有限的设备上部署LLM非常重要。

简化LoRA方法

LoRA方法本质上是一种使用低秩矩阵近似LLM的原始权重矩阵的方法。这是一种聪明的技巧,可以在不太牺牲性能的前提下减少计算需求。在QA-LoRA的上下文中,这种低秩自适应与量化相结合,提供了一个更高效的模型。

- 步骤1:首先确定您的LLM中适合进行低秩近似的权重矩阵。

- 步骤2:使用奇异值分解(Singular Value Decomposition,SVD)等数学技术找到这些低秩近似。

- 步骤3:用这些低秩近似替换原始的权重矩阵。

- 步骤4:应用量化以进一步减小模型的大小。

通过按照这些步骤,您可以显著减少LLM的计算负担,使其更容易和更快地部署。

在QA-LoRA中平衡量化和自适应

QA-LoRA最引人注目的一个方面是它如何平衡量化和自适应之间的自由度。这种平衡至关重要,因为它让QA-LoRA既高效又准确。过量的量化可能导致精度损失,而过量的自适应可能使模型计算代价过高。 QA-LoRA在这两者之间找到了最佳平衡点。

- 效率:通过使用量化,QA-LoRA减小了模型的大小,使其加载和运行速度更快。

- 准确性:通过低秩自适应,它保持了模型的性能,确保您不必在质量上做出妥协。

正如我们所见,QA-LoRA提供了一种平衡的方法,使其成为任何希望以高效和准确的方式进行大型语言模型微调和部署的人的首选方法。它结合了效率和准确性的优势,使其成为机器学习领域中的创新者。

如何开始使用QA-LoRA

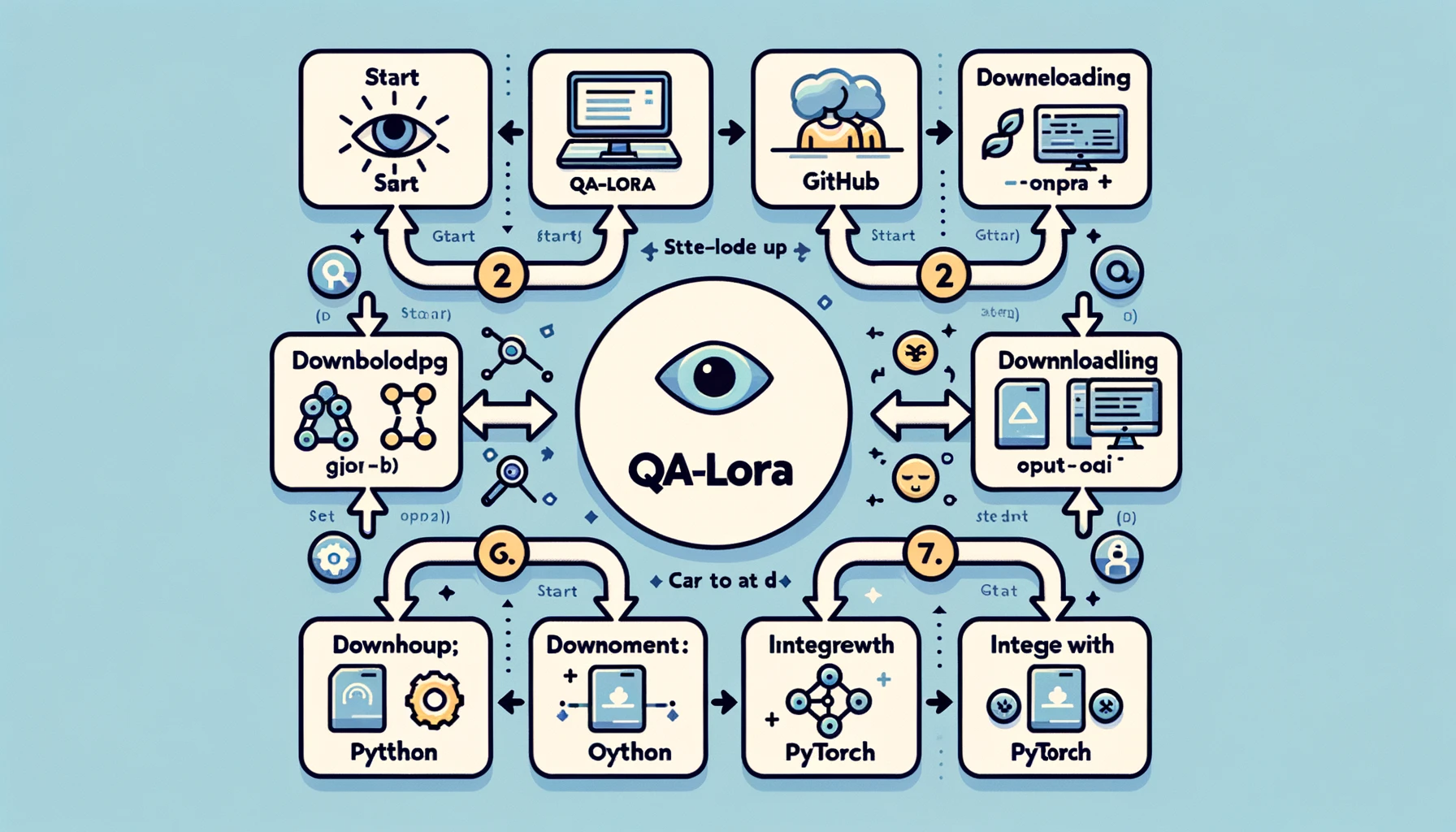

为QA-LoRA设置开发环境

在您开始使用QA-LoRA之前,您需要设置开发环境。这是一个关键的步骤,因为正确的设置可以使您的工作更加顺利和高效。以下是设置开发环境的步骤:

- 步骤1:安装Python:如果尚未安装,请在您的系统上安装Python。建议使用Python 3.x。

- 步骤2:设置虚拟环境:最好在虚拟环境中工作,以避免依赖冲突。您可以使用

venv或conda等工具来完成。 - 步骤3:安装所需库:您将需要安装PyTorch、NumPy等库。使用pip或conda安装这些库。

- 步骤4:克隆GitHub仓库:有一个专门用于QA-LoRA的GitHub仓库。将其克隆到本地机器上以获取示例代码和其他资源。

按照这些步骤,您将拥有一个稳定的开发环境,可以准备好实施QA-LoRA。这样的设置可以确保您拥有实施过程所需的所有工具和库。

实施QA-LoRA:实例演示

现在您的环境已经设置好了,让我们开始实际实施。这是一个让您领略QA-LoRA的实际操作的步骤指南。

- **步骤1:导入库**:开始通过导入所有必要的库来导入所有必要的库。这通常包括用于模型的PyTorch和用于数值操作的NumPy。

```python

import torch

import numpy as np-

步骤2:加载您的模型:加载您希望进行微调的大型语言模型。这可以是预训练模型,也可以是您自己训练的模型。

model = torch.load('your_model.pth') -

步骤3:识别权重矩阵:识别您模型中适合进行低秩逼近的权重矩阵。通常是完全连接的层。

-

步骤4:应用低秩逼近:使用奇异值分解(SVD)等技术来逼近这些权重矩阵。

u, s, v = torch.svd(weight_matrix) -

步骤5:替换原始矩阵:用低秩逼近替换原始权重矩阵。

approx_matrix = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

步骤6:应用量化:最后,应用量化来进一步减小模型的大小。可以使用PyTorch的量化工具进行此操作。

quantized_model = torch.quantization.quantize_dynamic(model)

通过按照这个详细的操作指南,您将拥有QA-LoRA的工作实现。这不仅会使您的模型更高效,而且还能保持其性能,让您同时获得最佳效果。

QA-LoRA研究的下一步

虽然QA-LoRA已经是一种开创性的方法,但值得注意的是,这个领域的研究远未结束。该领域正呈现出创新的机会,并且还有多个进一步改进的途径。例如,当前的研究集中在在不影响准确性的情况下使QA-LoRA更加高效。这涉及到调整量化和低秩适应之间的平衡,以及其他一些方面。

- 优化量化:关注的一个领域是优化量化过程,以确保最小化信息损失。

- 自适应低秩逼近:另一个途径是使低秩逼近过程自适应,使模型能够根据手头的任务进行调整。

这些持续的研究努力旨在使QA-LoRA更加稳健和多功能,确保它始终是有效微调大型语言模型的首选方法。

您可以在这里 (opens in a new tab)阅读有关QA-LoRA论文的更多信息。

总结:QA-LoRA的重要性

对QA-LoRA及其影响的最后思考

当我们完成这个全面指南时,重要的是退后一步,赞赏QA-LoRA的变革力量。这种方法不仅仅是机器学习算法不断扩大的技术术语中的又一个。它是一种解决部署大型语言模型的现实挑战的重要进展。

-

效率:QA-LoRA最引人注目的优点之一就是其效率。通过结合量化和低秩适应,它显著减少了LLM的计算和内存需求。这对于希望在大规模或资源有限的设备上部署这些模型的开发人员和组织来说是一个福音。

-

准确性:QA-LoRA不会在性能上做出妥协。尽管效率提高了,但该方法保持了模型的准确性,确保您获得高质量的结果。这种效率和准确性之间的平衡是QA-LoRA与其他微调方法的区别所在。

-

多功能性:该方法是多功能的,可以应用于各种类型的大型语言模型。无论您是从事自然语言处理、计算机视觉还是其他任何领域,都可以调整QA-LoRA以适应您的需求。

-

实施简易性:通过现成的代码和支持性的社区,实施QA-LoRA比以往更容易。即使您不是机器学习专家,该方法也是简单易懂的。

总而言之,QA-LoRA不仅仅是一种微调方法;它是我们在大型语言模型部署中的方法革新。它提供了一种平衡、高效和有效的方法,使这些计算巨人更接近实际的现实应用。如果您从事机器学习领域或对大型语言模型的潜力感兴趣,QA-LoRA是一个您不能忽视的主题。

结论

大型语言模型的世界充满挑战,尤其在部署方面。QA-LoRA成为一种希望之光,为微调这些模型提供了一种平衡和高效的方法。无论是从技术细节到实际实现,QA-LoRA都是效率和准确性并重时可以信赖的伴侣。

因此,在您进行下一个涉及大型语言模型的项目时,请记住QA-LoRA是您高效和有效微调的可靠伙伴。尝试一下,并加入这场正在为机器学习世界树立新标杆的革命。

想了解最新的LLM新闻吗?请查看最新的LLM排行榜!