Mistral AI enthüllt bahnbrechendes 8x22B Moe-Modell: Eine neue Ära in der Open-Source-KI

Published on

Einführung in Mistral 8x22B

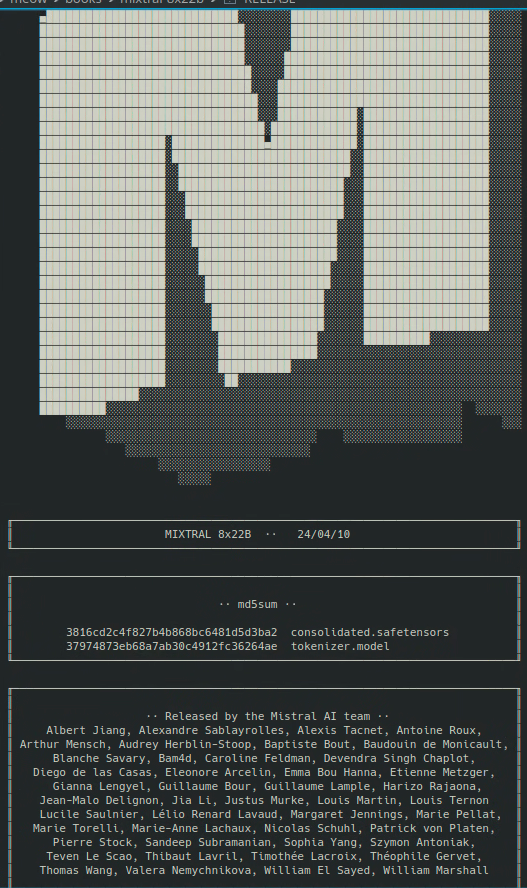

Mit einer sensationellen Entwicklung, die die KI-Community erschüttert hat, hat Mistral AI gerade die Veröffentlichung ihres mit Spannung erwarteten 8x22B Moe-Modells bekannt gegeben. Dieser bahnbrechende Erfolg markiert einen bedeutenden Meilenstein in der Welt der Open-Source-Künstlichen Intelligenz, da er eine beispiellose Leistung und Fähigkeiten verspricht, die zuvor als exklusives Merkmal proprietärer Modelle galten.

Der Aufstieg der Open-Source-KI

Das Gebiet der künstlichen Intelligenz hat in den letzten Jahren eine rasante Transformation erlebt, mit dem Aufkommen leistungsstarker Open-Source-Modelle, die die Dominanz proprietärer Systeme infrage gestellt haben. Dieser Wandel wurde durch die wachsende Anerkennung der Bedeutung von Zusammenarbeit und Transparenz bei der Entwicklung von KI-Technologien sowie dem Wunsch, den Zugang zu diesen leistungsstarken Werkzeugen zu demokratisieren, vorangetrieben.

Mistral AI ist führend in dieser Bewegung und hat eine Erfolgsbilanz bei der Bereitstellung von modernsten Modellen, die kontinuierlich die Grenzen dessen erweitert haben, was mit Open-Source-KI möglich ist. Ihre vorherigen Veröffentlichungen wie das hochgelobte Mixtral 8x7b-Modell haben bei Forschern und Entwicklern gleichermaßen breite Anerkennung gefunden und bereiten den Weg für noch größere Durchbrüche in der Zukunft.

Das 8x22B Moe-Modell: Ein Quantensprung nach vorn

Das 8x22B Moe-Modell repräsentiert einen Quantensprung in den Fähigkeiten von Open-Source-KI. Mit erstaunlichen 130 Milliarden Parametern und geschätzten 44 Milliarden aktiven Parametern pro Vorwärtsdurchlauf befindet sich dieses Modell wirklich in einer eigenen Liga. Um dies in Perspektive zu setzen: Das 8x22B Moe-Modell ist mehr als doppelt so groß wie das bisher größte verfügbare Open-Source-Modell und steht in der Leistungsfähigkeit einigen der fortschrittlichsten proprietären Modelle in nichts nach.

Laden Sie den Mistral 8x22b Magnetlink hier herunter:

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce (opens in a new tab)

Schlüsselfunktionen und -fähigkeiten

Was unterscheidet das 8x22B Moe-Modell genau von seinen Vorgängern? Hier sind nur einige der Schlüsselfunktionen und -fähigkeiten, die diese Veröffentlichung so aufregend machen:

-

Beispiellose Sprachverständnis: Das 8x22B Moe-Modell wurde auf einem enormen Textkorpus trainiert, was ihm ein tiefes Verständnis natürlicher Sprache ermöglicht, das alles bisher Gesehene in einem Open-Source-Modell übertrifft. Das bedeutet, dass das Modell in nuanciertere und kontextbewusstere Gespräche einbezogen werden kann und eine größere Bandbreite von Aufgaben und Anwendungen bewältigen kann als je zuvor.

-

Verbesserte logische Schlussfolgerungen und Problemlösung: Neben seinen Sprachverständnisfähigkeiten wurde das 8x22B Moe-Modell auch darauf ausgelegt, bei logischem Denken und Schlussfolgerungen herausragende Leistungen zu erbringen. Das bedeutet, dass es komplexe Herausforderungen bewältigen kann, die logisches Denken und Schlussfolgerungen erfordern, wie zum Beispiel Fragen auf der Grundlage einer bestimmten Faktenbasis zu beantworten oder kreative Lösungen für offene Probleme zu generieren.

-

Verbesserte Effizienz und Skalierbarkeit: Trotz seiner massiven Größe wurde das 8x22B Moe-Modell dank einer Reihe von technischen Innovationen, die vom Mistral AI-Team entwickelt wurden, auf Effizienz und Skalierbarkeit optimiert. Das bedeutet, dass das Modell auf einer größeren Auswahl von Hardwarekonfigurationen eingesetzt und betrieben werden kann als frühere Modelle, was es für Forscher und Entwickler auf der ganzen Welt zugänglicher macht.

Auswirkungen auf die Zukunft der KI

Die Veröffentlichung des 8x22B Moe-Modells ist nicht nur eine technische Errungenschaft, sondern auch eine kraftvolle Aussage über die Zukunft der künstlichen Intelligenz. Indem Mistral AI zeigt, dass Open-Source-Modelle die Leistung proprietärer Systeme erreichen oder sogar übertreffen können, trägt sie dazu bei, das Spielfeld zu nivellieren und sicherzustellen, dass die Vorteile von KI allen zugänglich sind.

Dies hat tiefgreifende Auswirkungen auf eine Vielzahl von Bereichen und Branchen, von Gesundheitswesen und Bildung bis hin zu Finanzen und Verkehrswesen. Mit dem 8x22B Moe-Modell und anderen Open-Source-Tools sind Forscher und Entwickler in der Lage, einige der drängendsten Herausforderungen unserer heutigen Welt anzugehen und neue Anwendungen und Dienste zu schaffen, die zuvor unvorstellbar waren.

Fazit

Die Veröffentlichung des 8x22B Moe-Modells von Mistral AI ist ein Wendepunkt in der Geschichte der künstlichen Intelligenz. Durch das Erweitern der Grenzen dessen, was mit Open-Source-KI möglich ist, beschleunigt diese Veröffentlichung das Tempo von Innovation und Entdeckung auf diesem Gebiet und eröffnet neue Möglichkeiten für Forscher, Entwickler und Unternehmen auf der ganzen Welt.

Wenn wir in die Zukunft blicken, wird klar, dass Open-Source-KI eine immer wichtigere Rolle bei der Gestaltung des Fortschritts der Technologie spielen wird. Mit Werkzeugen wie dem 8x22B Moe-Modell haben wir die Möglichkeit, eine intelligentere, stärker vernetzte und gerechtere Welt zu schaffen - eine Welt, in der die Vorteile von KI allen zugutekommen.

titel: So feiern wir diese beachtliche Leistung Sprache: de

Lasst uns dieses bedeutsame Ereignis feiern und unsere Anstrengungen verdoppeln, um eine Zukunft aufzubauen, in der künstliche Intelligenz dem größeren Wohl dient. Gemeinsam können wir die Kraft von Open-Source-AI nutzen, um die größten Herausforderungen unserer Zeit zu lösen und eine hellere, hoffnungsvollere Zukunft für die gesamte Menschheit zu schaffen.

Möchten Sie die neuesten LLM-Nachrichten erfahren? Schauen Sie sich die aktuelle LLM-Bestenliste an!