QA-LoRA: Ein Leitfaden zur effizienten Feinabstimmung großer Sprachmodelle

Published on

Willkommen im faszinierenden Universum großer Sprachmodelle (LLMs)! Diese Rechenriesen sind das Rückgrat zahlreicher Anwendungen, von Chatbots und Übersetzern über Content-Generatoren und Empfehlungssysteme. Doch so wunderbar sie auch sind, ihre Bereitstellung ist kein Spaziergang im Park. Die Rechen- und Speicheranforderungen können enorm sein und erfordern oft spezialisierte Hardware und viel Geduld.

Genau hier kommt QA-LoRA ins Spiel. Diese bahnbrechende Methode verändert das Spiel und erleichtert die Feinabstimmung und Bereitstellung von LLMs erheblich. Wenn Sie also Probleme mit der Rechenlast von LLMs haben oder nach einem intelligenten Weg suchen, um sie feinzustimmen, sind Sie hier genau richtig.

Warum QA-LoRA eine Revolution für LLMs ist

Möchten Sie die neuesten LLM-Nachrichten erfahren? Schauen Sie sich das aktuelle LLM-Leaderboard an!

Was genau ist QA-LoRA und wie unterscheidet es sich von LoRA?

Bevor wir ins Detail gehen, wollen wir unser Thema definieren. QA-LoRA steht für Quantization-Aware Low-Rank Adaptation. Einfach ausgedrückt ist es eine Methode, die darauf abzielt, die Feinabstimmung großer Sprachmodelle effizienter zu gestalten. Sie fragen sich vielleicht: "Was ist dann LoRA?" LoRA ist die Abkürzung für Low-Rank Adaptation, eine Technik, die darauf abzielt, die Komplexität eines Modells zu reduzieren, während seine Leistung erhalten bleibt. Was QA-LoRA von LoRA unterscheidet, ist der quantization-aware Aspekt.

- Quantisierung: Dies ist der Prozess, bei dem die möglichen Werte, die eine Funktion annehmen kann, eingeschränkt werden. Im Kontext von LLMs trägt dies zur Reduzierung der Größe des Modells bei.

- Low-Rank Adaptation: Dabei handelt es sich um eine Approximation der ursprünglichen hochdimensionalen Daten durch eine niedrigdimensionale Form, die das Modell rechnerisch weniger aufwendig macht.

Wenn Sie diese beiden Aspekte - Quantisierung und Low-Rank Adaptation - kombinieren, erhalten Sie QA-LoRA, eine Methode, die nicht nur die Größe des Modells reduziert, sondern es auch rechnerisch effizienter macht. Dies ist entscheidend für die Bereitstellung von LLMs auf Geräten mit begrenzten Rechenressourcen.

Die vereinfachte LoRA-Methode

Die LoRA-Methode ist im Wesentlichen eine Methode, um die originalen Gewichtsmatrizen eines LLMs mit niedrigrangigen Matrizen anzunähern. Dies ist ein cleverer Trick, um die Rechenanforderungen zu reduzieren, ohne viel an Leistung einzubüßen. Im Zusammenhang mit QA-LoRA arbeitet diese Low-Rank Adaptation eng mit der Quantisierung zusammen, um ein noch effizienteres Modell bereitzustellen.

- Schritt 1: Beginnen Sie damit, die Gewichtsmatrizen in Ihrem LLM zu identifizieren, die für eine Low-Rank Approximation geeignet sind.

- Schritt 2: Verwenden Sie mathematische Techniken wie die Singulärwertzerlegung (SVD), um diese Low-Rank Approximationen zu finden.

- Schritt 3: Ersetzen Sie die originalen Gewichtsmatrizen durch diese Low-Rank Approximationen.

- Schritt 4: Wenden Sie Quantisierung an, um die Größe des Modells weiter zu reduzieren.

Indem Sie diesen Schritten folgen, können Sie die Rechenlast Ihres LLMs erheblich reduzieren und es so einfacher und schneller bereitstellen.

Die Balance von Quantisierung und Adaptation in QA-LoRA

Ein besonders interessanter Aspekt von QA-LoRA ist die Art und Weise, wie es die Freiheitsgrade zwischen Quantisierung und Adaptation ausbalanciert. Diese Balance ist entscheidend, da sie QA-LoRA effizient und präzise macht. Eine zu starke Quantisierung kann zu einem Verlust an Genauigkeit führen, während zu viel Adaptation das Modell rechnerisch teuer machen kann. QA-LoRA findet den goldenen Mittelweg zwischen beiden.

- Effizienz: Durch die Verwendung von Quantisierung reduziert QA-LoRA die Größe des Modells, was das Laden und Ausführen schneller macht.

- Genauigkeit: Durch die Low-Rank Adaptation behält es die Leistung des Modells bei und stellt sicher, dass Sie in Bezug auf Qualität keine Kompromisse eingehen müssen.

Wie wir sehen können, bietet QA-LoRA einen ausgewogenen Ansatz, der es zu einer bevorzugten Methode für jeden macht, der große Sprachmodelle effizient feinabstimmen und bereitstellen möchte. Es vereint das Beste aus beiden Welten - Effizienz und Genauigkeit - und ist damit eine Revolution im Bereich des maschinellen Lernens.

So starten Sie mit QA-LoRA

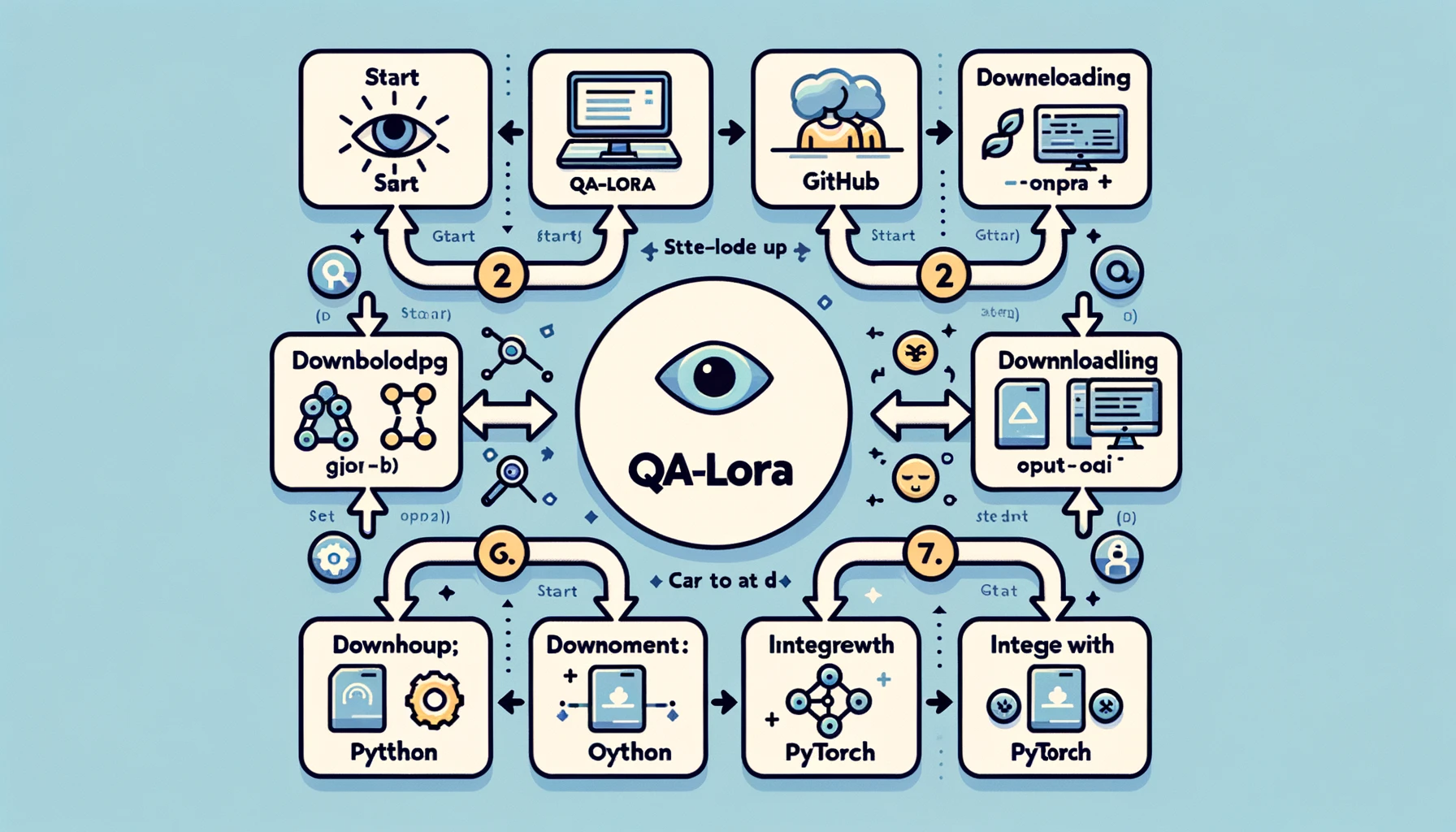

Einrichten Ihrer Umgebung für QA-LoRA

Bevor Sie in die Welt von QA-LoRA eintauchen können, müssen Sie Ihre Entwicklungsumgebung einrichten. Dies ist ein entscheidender Schritt, da die richtige Einrichtung Ihre Reise reibungsloser und effizienter gestalten kann. So gehen Sie vor:

- Schritt 1: Python installieren: Installieren Sie Python auf Ihrem System, falls Sie dies noch nicht getan haben. Python 3.x wird empfohlen.

- Schritt 2: Virtuelle Umgebung einrichten: Es ist immer eine gute Idee, in einer virtuellen Umgebung zu arbeiten, um Konflikte mit Abhängigkeiten zu vermeiden. Sie können Tools wie

venvodercondadafür verwenden. - Schritt 3: Erforderliche Bibliotheken installieren: Sie benötigen Bibliotheken wie PyTorch, NumPy und andere. Verwenden Sie pip oder conda, um diese zu installieren.

- Schritt 4: Das GitHub-Repository klonen: Es gibt ein dediziertes GitHub-Repository für QA-LoRA. Klonen Sie es auf Ihren lokalen Rechner, um den Beispielcode und andere Ressourcen zu erhalten.

Indem Sie diesen Schritten folgen, haben Sie eine robuste Entwicklungsumgebung bereitgestellt, um QA-LoRA umzusetzen. Diese Einrichtung stellt sicher, dass Sie alle Werkzeuge und Bibliotheken haben, die Sie für eine möglichst reibungslose Implementierung benötigen.

QA-LoRA implementieren: Eine Schritt-für-Schritt-Anleitung

Jetzt, da Ihre Umgebung eingerichtet ist, geht es zur eigentlichen Implementierung. Hier kommt es darauf an, und Sie sehen QA-LoRA in Aktion. Hier ist eine Schritt-für-Schritt-Anleitung zur Implementierung von QA-LoRA:

-

Schritt 1: Bibliotheken importieren: Beginnen Sie mit dem Importieren aller erforderlichen Bibliotheken. Dies umfasst normalerweise PyTorch für das Modell und NumPy für numerische Operationen.

import torch import numpy as np -

Schritt 2: Laden Sie Ihr Modell: Laden Sie das Large Language Model, das Sie feinabstimmen möchten. Dies kann ein vortrainiertes Modell oder ein von Ihnen trainiertes Modell sein.

model = torch.load('dein_model.pth') -

Schritt 3: Gewichtsmatrizen identifizieren: Identifizieren Sie die Gewichtsmatrizen in Ihrem Modell, die für eine Approximation niedriger Rangordnung geeignet sind. Dies sind normalerweise die vollständig verbundenen Schichten.

-

Schritt 4: Niedrigrangapproximation anwenden: Verwenden Sie Techniken wie die Singulärwertzerlegung (SVD), um diese Gewichtsmatrizen näherungsweise anzunähern.

u, s, v = torch.svd(gewichtsmatrix) -

Schritt 5: Ursprüngliche Matrizen ersetzen: Ersetzen Sie die ursprünglichen Gewichtsmatrizen durch die niedrig-rangigen Approximationen.

approx_matrix = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

Schritt 6: Quantisierung anwenden: Wenden Sie abschließend die Quantisierung an, um die Größe des Modells weiter zu reduzieren. Dies kann mit den Quantisierungswerkzeugen von PyTorch durchgeführt werden.

quantized_model = torch.quantization.quantize_dynamic(model)

Indem Sie dieser ausführlichen Anleitung folgen, haben Sie eine funktionierende Implementierung von QA-LoRA. Dadurch wird Ihr Modell nicht nur effizienter, sondern behält auch seine Leistungsfähigkeit, sodass Sie das Beste aus beiden Welten haben.

Die nächsten Schritte in der QA-LoRA-Forschung

Obwohl QA-LoRA bereits eine bahnbrechende Methode ist, ist es wichtig zu beachten, dass die Forschung in diesem Bereich noch lange nicht abgeschlossen ist. Das Feld ist reif für Innovationen, und es gibt mehrere Möglichkeiten zur weiteren Verbesserung. Zum Beispiel konzentriert sich die aktuelle Forschung darauf, QA-LoRA noch effizienter zu machen, ohne dabei die Genauigkeit zu beeinträchtigen. Dies beinhaltet die Feinabstimmung des Gleichgewichts zwischen Quantisierung und niedrig-rangiger Anpassung, unter anderem.

- Optimierung der Quantisierung: Ein Schwerpunkt liegt auf der Optimierung des Quantisierungsprozesses, um einen minimalen Informationsverlust zu gewährleisten.

- Adaptive Niedrigrang-Approximation: Ein weiterer Ansatz besteht darin, den Prozess der niedrig-rangigen Approximation anpassungsfähig zu machen, sodass sich das Modell je nach Aufgabe anpassen kann.

Diese laufenden Forschungsanstrengungen zielen darauf ab, QA-LoRA noch robuster und vielseitiger zu machen, um sicherzustellen, dass es die bevorzugte Methode bleibt, um Large Language Models effizient feinabzustimmen.

Lesen Sie hier mehr über den QA-LoRA Paper hier (opens in a new tab).

Zusammenfassung: Warum QA-LoRA wichtig ist

Abschließende Gedanken zu QA-LoRA und deren Auswirkungen

Beim Abschluss dieses umfassenden Leitfadens ist es wichtig, einen Schritt zurückzutreten und die transformative Kraft von QA-LoRA zu schätzen. Diese Methode ist nicht einfach nur ein weiterer technischer Jargon, der in das stetig wachsende Meer der Machine-Learning-Algorithmen geworfen wird. Es handelt sich um einen entscheidenden Fortschritt, der realen Herausforderungen bei der Bereitstellung von Large Language Models begegnet.

-

Effizienz: Einer der überzeugendsten Vorteile von QA-LoRA ist seine Effizienz. Durch die Kombination von Quantisierung und niedrig-rangiger Anpassung werden die Rechen- und Speicheranforderungen von LLMs erheblich reduziert. Dies ist ein Segen für Entwickler und Organisationen, die diese Modelle im großen Maßstab oder auf Geräten mit begrenzten Ressourcen bereitstellen möchten.

-

Genauigkeit: QA-LoRA geht keine Kompromisse bei der Leistungsfähigkeit ein. Trotz seiner Effizienz behält die Methode die Genauigkeit des Modells bei und liefert qualitativ hochwertige Ergebnisse. Dieses Gleichgewicht zwischen Effizienz und Genauigkeit unterscheidet QA-LoRA von anderen Feinabstimmungsmethoden.

-

Vielseitigkeit: Die Methode ist vielseitig und kann auf verschiedene Arten von Large Language Models angewendet werden. Egal, ob Sie an der Verarbeitung natürlicher Sprache, der Computer Vision oder einem anderen Bereich arbeiten, QA-LoRA kann an Ihre Bedürfnisse angepasst werden.

-

Einfache Implementierung: Mit dem leicht verfügbaren Code und einer unterstützenden Community ist die Implementierung von QA-LoRA einfacher als je zuvor. Selbst wenn Sie kein Experte für maschinelles Lernen sind, ist die Methode zugänglich und einfach anzuwenden.

Zusammenfassend lässt sich sagen, dass QA-LoRA mehr ist als nur eine Feinabstimmungsmethode. Es handelt sich um einen Paradigmenwechsel in der Art und Weise, wie wir Large Language Models bereitstellen. Es bietet einen ausgewogenen, effizienten und effektiven Weg, um diese Rechenriesen praktischen Anwendungen in der realen Welt näher zu bringen. Wenn Sie im Bereich des maschinellen Lernens tätig sind oder von dem Potenzial der Large Language Models fasziniert sind, können Sie QA-LoRA nicht ignorieren.

Schlussfolgerung

Die Welt der Large Language Models ist spannend, aber mit Herausforderungen verbunden, insbesondere wenn es um die Bereitstellung geht. QA-LoRA erweist sich als Hoffnungsschimmer und bietet eine ausgewogene und effiziente Methode zur Feinabstimmung dieser Modelle. Von den technischen Feinheiten bis zur praktischen Umsetzung steht QA-LoRA als Beweis dafür, was erreicht werden kann, wenn Effizienz und Genauigkeit Hand in Hand gehen.

Also, wenn Sie sich in Ihr nächstes Projekt mit Large Language Models stürzen, denken Sie daran, dass QA-LoRA Ihr vertrauter Begleiter für eine effiziente und effektive Feinabstimmung ist. Probieren Sie es aus und schließen Sie sich der Revolution an, die neue Maßstäbe in der Welt des maschinellen Lernens setzt.

Möchten Sie die neuesten Nachrichten zu Large Language Models erfahren? Schauen Sie sich das aktuelle LLM-Ranking an!