Mistral AI, 개척적인 8x22B Moe Model을 공개: 오픈소스 인공지능의 새로운 시대

Published on

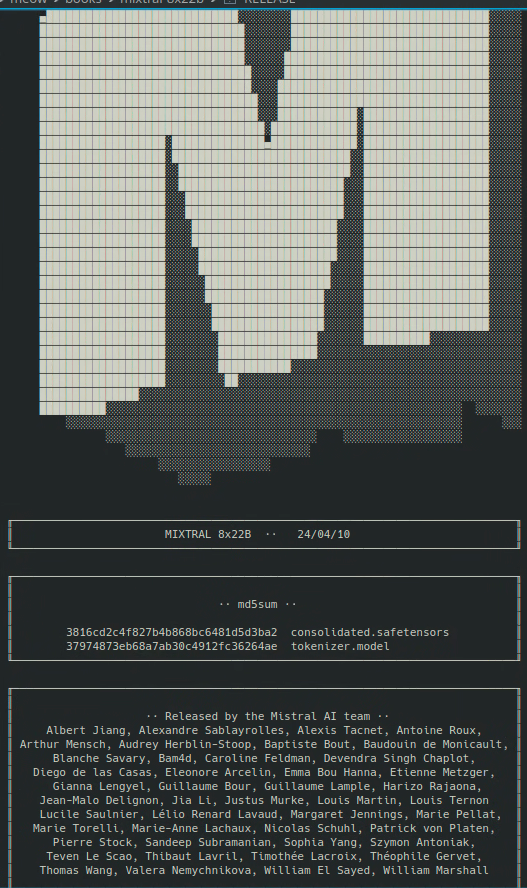

Mistral 8x22B 소개

AI 커뮤니티에 큰 파장을 일으킨 놀라운 발전으로, Mistral AI가 매우 기대되는 8x22B Moe 모델을 공식 발표했습니다. 이 개척적인 성과는 프로프리어터리 모델에 독점적인 성능과 기능을 제공한다는 기존의 관점을 훨씬 넘어서는 오픈소스 인공지능 세계에서의 중요한 원대한 기록을 세우게 되었습니다.

오픈소스 인공지능의 부상

인공지능 분야는 강력한 오픈소스 모델의 등장으로 개발사 독점으로부터의 지배를 도전한 최근 몇 년간 급속한 변화를 겪었습니다. 이러한 변화는 인공지능 기술의 개발에서의 협력과 투명성의 중요성을 점차 인식하며, 이러한 강력한 도구들이 더 많은 사람들에게 더욱 더 보편적으로 사용될 수 있도록 하고자 하는 의지에 의해 주도되었습니다.

Mistral AI는 오픈소스 인공지능의 선두주자로, 오픈소스 인공지능에서 가능한 것에 대한 경계를 지속적으로 넓히며 혁신적인 모델을 제공해 왔습니다. 이들의 이전 모델인 높이 평가받은 Mixtral 8x7b 모델 등은 연구원들과 개발자들로부터 널리 칭송받으며, 앞으로 더욱 큰 성과를 이루기 위한 무대를 마련해 놓았습니다.

8x22B Moe Model: 진보적인 도약

8x22B Moe 모델은 오픈소스 인공지능의 성능을 대폭 진보시킨 도약을 의미합니다. 1회의 Forward Pass 당 약 440억개의 활성 파라미터와 총 1,300억개의 파라미터를 가진 이 모델은 정말 독보적인 위치에 있습니다. 이를 비교해보면, 8x22B Moe 모델은 이전에 공개되었던 최대 오픈소스 모델의 크기보다 2배 이상 크며, 몇몇 최첨단 프로프리어터리 모델과 성능상으로 견줄 만한 수준을 자랑합니다.

여기에서 Mistral 8x22b 자석링크를 다운로드하실 수 있습니다:

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce (opens in a new tab)

주요 기능과 능력

8x22B Moe 모델을 그 이전 모델들과 구분짓는 주요 기능 몇 가지를 살펴보겠습니다. 이번 출시를 흥미롭게 만드는 요소들입니다:

-

비길 데 없는 언어 이해력: 8x22B Moe 모델은 방대한 텍스트 데이터를 기반으로 훈련되었으며, 이를 통해 이전 오픈소스 모델들보다도 훨씬 깊은 자연어 이해력을 갖추게 되었습니다. 이 모델은 더욱 세밀하고 맥락적으로 인식하는 대화를 할 수 있으며, 이전보다 더 다양한 작업과 응용에 대응할 수 있습니다.

-

향상된 추론과 문제 해결 능력: 언어 이해력 뿐만 아니라 8x22B Moe 모델은 추론과 문제 해결 작업에서도 우수한 성능을 발휘할 수 있도록 설계되었습니다. 이 모델은 주어진 사실에 기반한 질문에 대답하거나 개방형 문제에 창의적인 해결책을 생성하는 등, 논리적 사고와 추론이 필요한 복잡한 도전에 대해 대응할 수 있습니다.

-

향상된 효율성과 확장성: 거대한 크기에도 불구하고, 8x22B Moe 모델은 Mistral AI 팀이 개발한 다양한 기술적 혁신을 통해 효율성과 확장성을 최적화해 왔습니다. 이 모델은 이전 모델보다 더 다양한 하드웨어 구성에서 배포 및 실행이 가능하며, 전 세계의 연구원들과 개발자들에게 더욱 접근 가능한 모델로 만듭니다.

인공지능의 미래에 대한 함의

8x22B Moe 모델의 공개는 기술적인 성과뿐만 아니라 인공지능의 미래에 대한 강력한 선언입니다. 오픈소스 모델이 프로프리어터리 시스템의 성능을 맞추거나 초월함을 보임으로써, Mistral AI는 경쟁을 공평하게 하고 AI의 혜택을 모든 사람에게 제공하는 데 도움을 주고 있습니다.

이는 의료, 교육, 금융, 교통 등 다양한 분야와 산업에 깊은 영향을 미칩니다. 8x22B Moe 모델과 기타 오픈소스 도구를 이용하여, 연구원과 개발자들은 오늘날 우리 세상이 직면한 가장 긴요한 과제들에 대처할 수 있으며, 이전에 상상조차 할 수 없었던 새로운 응용과 서비스를 만들 수 있게 됩니다.

결론

Mistral AI에 의해 8x22B Moe 모델이 공개된 것은 인공지능의 역사상의 획기적인 순간입니다. 오픈소스 인공지능이 가능한 범위를 넓혀가며 혁신과 발견의 속도를 가속화하고, 연구원, 개발자, 기업에게 새로운 기회를 제공할 것입니다.

우리가 미래를 내다볼 때, 분명한 것은 오픈소스 인공지능이 기술적 진보의 경로를 향해 더욱 중요한 역할을 할 것이라는 점입니다. 8x22B Moe 모델과 같은 도구를 통해 우리는 더욱 지능적이고 연결된, 모든 이에게 혜택을 동등하게 나눌 수 있는 세계를 창조할 수 있는 힘을 갖게 됩니다. 그러니 이 엄청난 성과를 축하합시다. 인공지능이 더 큰 선한 목적을 위해 노력하는 미래를 만들기 위해 우리의 노력을 두 배로 하도록 해요. 함께하면 오픈소스 AI의 힘을 활용하여 시대의 가장 큰 도전 과제를 해결하고, 모든 인류를 위한 더 밝고 희망찬 내일을 만들 수 있습니다.

최신 LLM 뉴스를 알고 싶으세요? LLM 리더보드를 확인해보세요!