LlamaIndex: LLM을 확장하는 LangChain 대안

Published on

소개: LlamaIndex란 무엇인가요?

LlamaIndex는 대형 언어 모델 (LLM)의 성능을 강화하기 위해 특별히 설계된 고성능 인덱싱 도구입니다. 단순한 쿼리 최적화 도구가 아니라 응답 합성, 구성 가능성, 효율적인 데이터 저장 등의 고급 기능을 포함한 포괄적인 프레임워크입니다. 복잡한 쿼리를 처리하고 맥락에 맞는 고품질 응답이 필요한 경우 LlamaIndex가 가장 적합한 솔루션입니다.

이 기사에서는 LlamaIndex에 대해 기술적인 탐구를 진행하며, 핵심 구성 요소, 고급 기능 및 프로젝트에 효과적으로 구현하는 방법을 살펴보겠습니다. 또한 LangChain과 같은 유사한 도구와 비교하여 LlamaIndex의 기능을 완벽히 이해할 수 있도록 하겠습니다.

최신 LLM 뉴스를 알고 싶나요? 최신 LLM 리더보드를 확인해 보세요!

어쨌든 LlamaIndex란 무엇인가요?

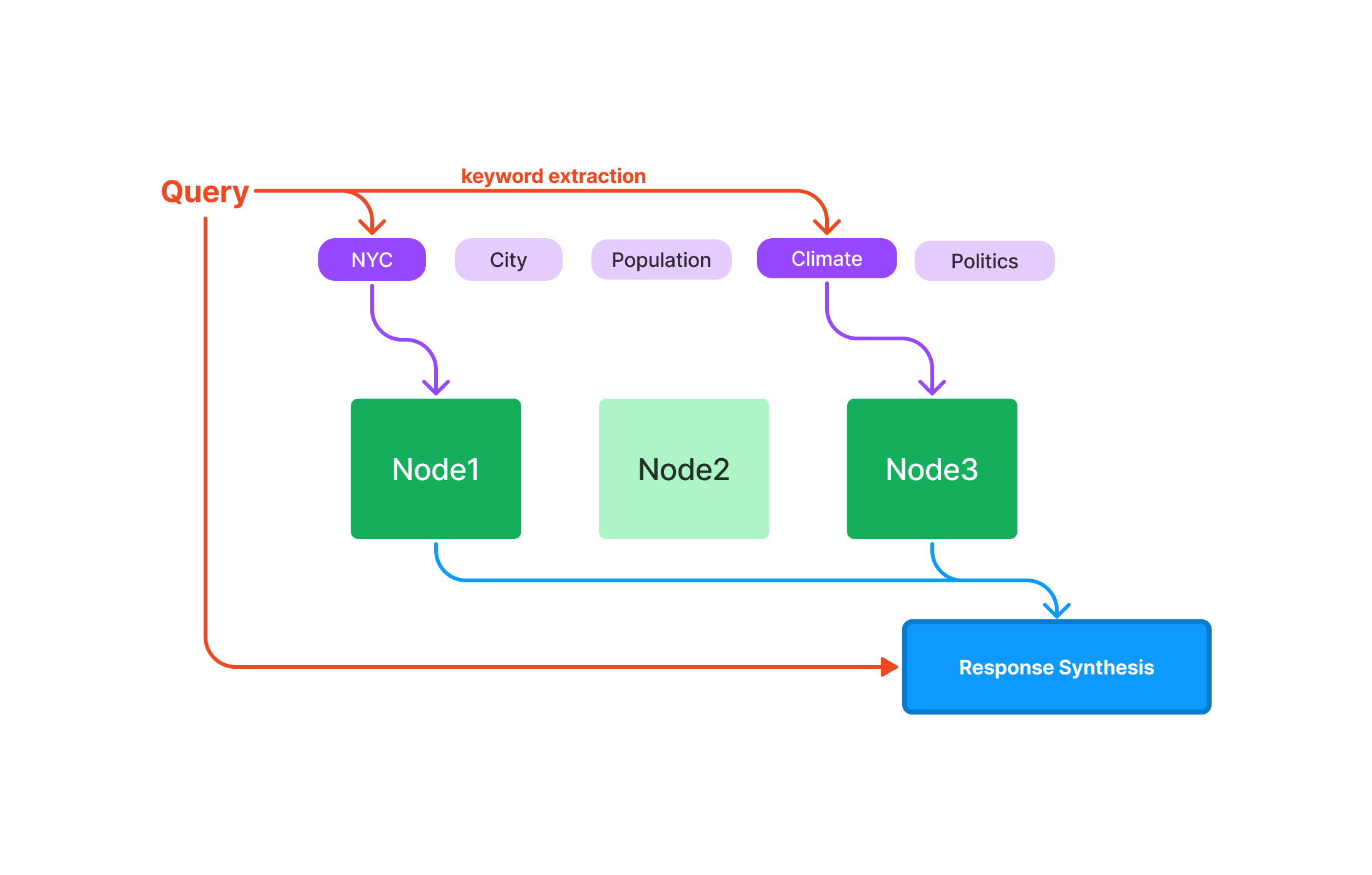

LlamaIndex는 대형 언어 모델 (LLM)의 기능을 강화하기 위해 특별히 설계된 특수 도구입니다. 정확한 쿼리와 고품질 응답이 필요한 시나리오에서 우수한 성능을 발휘하는 포괄적인 솔루션으로 사용됩니다.

쿼리: 데이터 검색 속도를 최적화하여 속도에 민감한 애플리케이션에 이상적입니다. 응답 합성: 간결하고 맥락에 맞는 응답을 생성하기 위해 최적화되었습니다. 구성 가능성: 모듈식이고 재사용 가능한 구성 요소를 사용하여 복잡한 쿼리 및 워크플로우를 빌드할 수 있습니다.

자, 이제 LlamaIndex에 대한 자세한 내용을 알아보겠습니다.

LlamaIndex에서 인덱스란 무엇인가요?

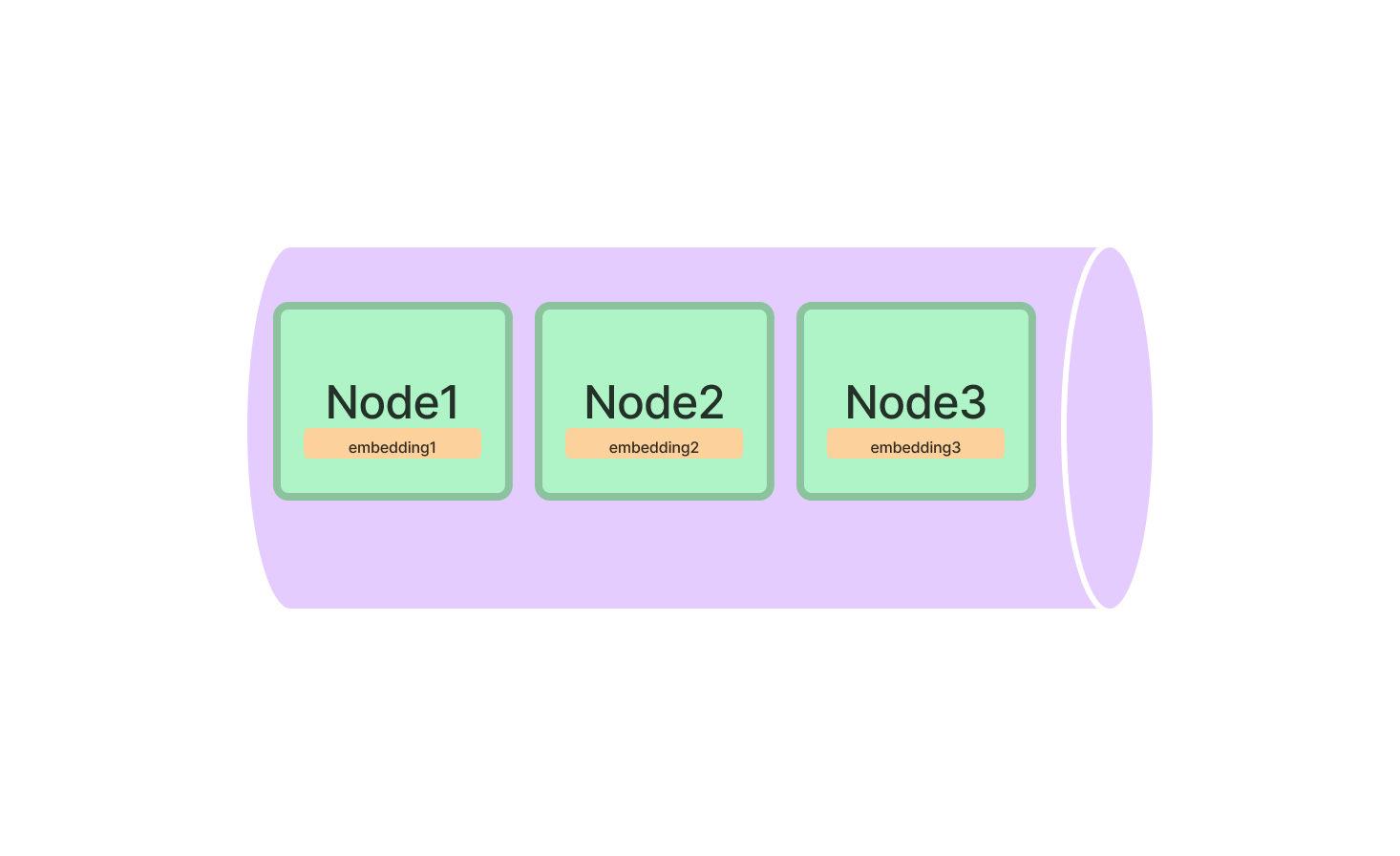

인덱스는 LlamaIndex의 핵심이며 쿼리할 정보를 보유하는 데이터 구조로 사용됩니다. LlamaIndex는 여러 종류의 인덱스를 제공하며 각각 특정 작업에 최적화되어 있습니다.

LlamaIndex의 인덱스 종류

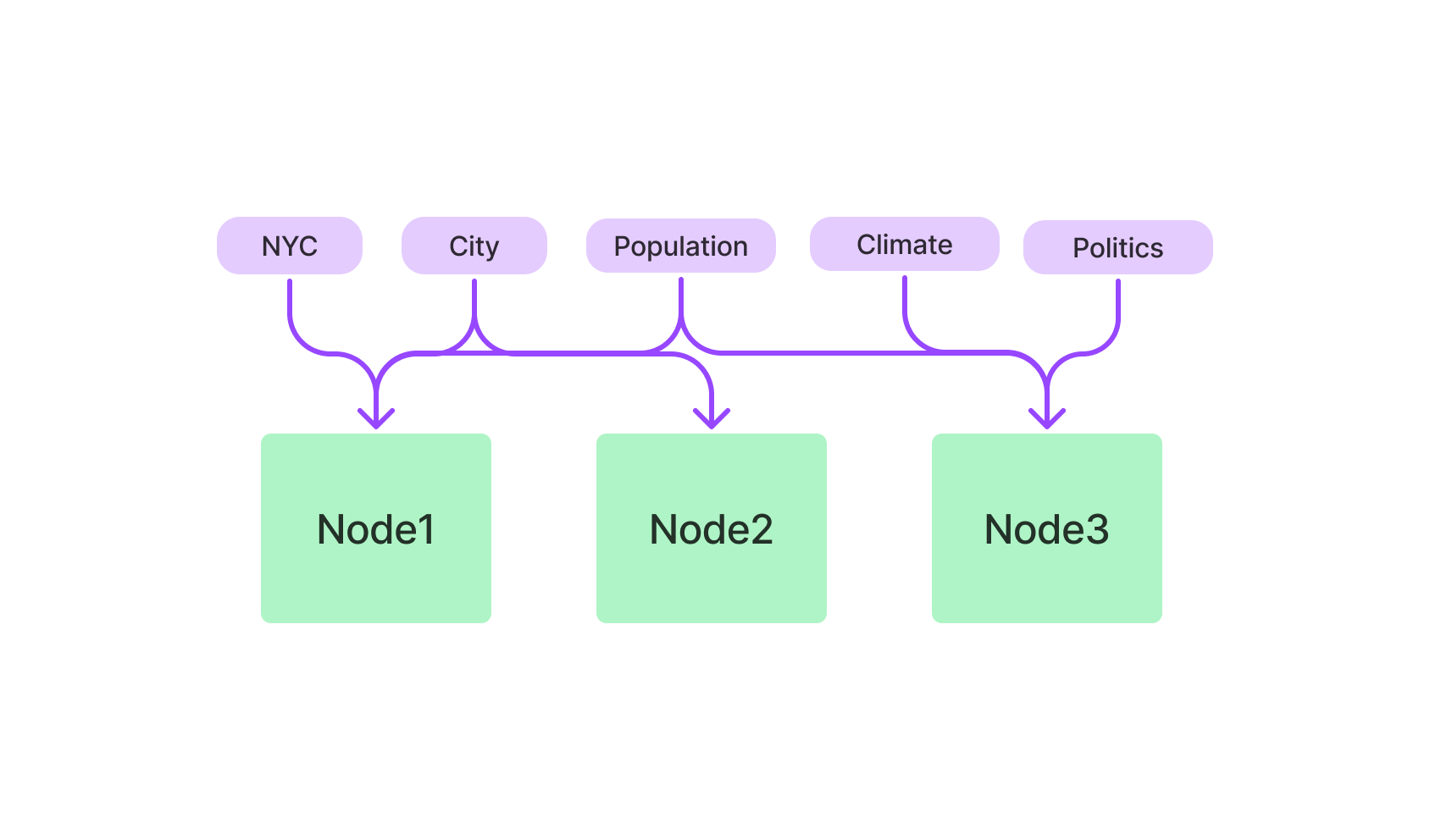

- 벡터 저장소 인덱스: k-NN 알고리즘을 활용하며 고차원 데이터에 최적화되었습니다.

- 키워드 기반 인덱스: 텍스트 기반 쿼리에 TF-IDF를 활용합니다.

- 하이브리드 인덱스: 벡터 및 키워드 기반 인덱스의 조합으로 균형 잡힌 접근 방식을 제공합니다.

LlamaIndex의 벡터 저장소 인덱스

벡터 저장소 인덱스는 고차원 데이터에 사용되는 도구입니다. 복잡한 데이터 포인트를 다루는 머신러닝 애플리케이션에 특히 유용합니다.

시작하려면 LlamaIndex 패키지에서 VectorStoreIndex 클래스를 가져와서 초기화해야 합니다. 가져온 후에는 벡터의 차원을 지정하여 인덱스를 초기화합니다.

from llamaindex import VectorStoreIndex

vector_index = VectorStoreIndex(dimensions=300)이렇게 하면 300 차원의 벡터 저장소 인덱스가 설정되어 고차원 데이터를 처리할 준비가 된 상태입니다. 이제 인덱스에 벡터를 추가하고 가장 유사한 벡터를 찾을 수 있는 쿼리를 실행할 수 있습니다.

# 벡터 추가

vector_index.add_vector(vector_id="vector_1", vector_data=[0.1, 0.2, 0.3, ...])

# 쿼리 실행

query_result = vector_index.query(vector=[0.1, 0.2, 0.3, ...], top_k=5)LlamaIndex의 키워드 기반 인덱스

텍스트 기반 쿼리에는 키워드 기반 인덱스가 적합합니다. 이 인덱스는 TF-IDF 알고리즘을 사용하여 텍스트 데이터를 검색하는 데 사용됩니다.

LlamaIndex 패키지에서 KeywordBasedIndex 클래스를 가져와서 키워드 기반 인덱스를 초기화합니다.

from llamaindex import KeywordBasedIndex

text_index = KeywordBasedIndex()이제 텍스트 데이터를 이 인덱스에 추가하고 텍스트 기반 쿼리를 실행할 수 있습니다.

# 텍스트 데이터 추가

text_index.add_text(text_id="document_1", text_data="This is a sample document.")

# 쿼리 실행

query_result = text_index.query(text="sample", top_k=3)LlamaIndex의 빠른 시작: 절차적 안내서

LlamaIndex를 설치하고 초기화하는 것은 시작에 불과합니다. 그러나 LlamaIndex의 기능을 효과적으로 사용하려면 어떻게 사용하는지 알아야 합니다.

LlamaIndex 설치

먼저, 해당 도구를 컴퓨터에 설치해야 합니다. 터미널을 열고 다음 명령을 실행하세요.

pip install llamaindex또는 conda를 사용하는 경우:

conda install -c conda-forge llamaindexLlamaIndex 초기화

설치가 완료된 후 Python 환경에서 LlamaIndex를 초기화해야 합니다. 이는 뒤이어 이어질 모든 작업을 준비하는 단계입니다.

from llamaindex import LlamaIndex

index = LlamaIndex(index_type="vector_store", dimensions=300)여기서 index_type은 설정하려는 인덱스 유형을 지정하고 dimensions은 벡터 저장소 인덱스의 크기를 지정합니다.

LlamaIndex의 벡터 저장소 인덱스를 사용하여 쿼리하는 방법

LlamaIndex를 성공적으로 설정한 후 강력한 쿼리 기능을 탐색할 수 있습니다. 벡터 저장소 인덱스는 복잡하고 고차원 데이터를 다루는 데 최적화되어 있으며, 따라서 머신러닝, 데이터 분석 및 기타 계산 작업에 가장 적합한 도구입니다.

LlamaIndex에서 첫 번째 쿼리 실행하기

코드에 들어가기 전에 LlamaIndex의 기본 요소를 이해하는 것이 중요합니다:

-

쿼리 벡터(Query Vector): 데이터셋 내에서 유사성을 찾고자하는 벡터입니다. 색인 된 벡터와 같은 차원 공간에 있어야 합니다.

-

'top_k' 매개변수(top_k Parameter): 이 매개변수는 쿼리 벡터와 가장 가까운 벡터 중 검색하려는 개수를 지정합니다. 'top_k'의 "k"는 가장 인접한 이웃의 개수를 의미합니다.

다음은 첫 번째 쿼리를 수행하는 방법에 대한 세부 설명입니다:

-

인덱스 초기화(Initialize Your Index): 인덱스가 로드되어 쿼리할 준비가 되었는지 확인합니다.

-

쿼리 벡터 지정(Specify the Query Vector): 쿼리 벡터의 요소를 포함하는 리스트 또는 배열을 만듭니다.

-

'top_k' 매개변수 설정(Set the

top_kParameter): 검색하려는 가장 가까운 벡터의 개수를 결정합니다. -

쿼리 실행(Execute the Query): 검색을 수행하기 위해 'query' 메서드를 사용합니다.

다음은 이러한 단계를 설명하는 Python 코드 예시입니다:

# 인덱스 초기화 (이름이 'index'로 가정)

# ...

# 쿼리 벡터 정의

query_vector = [0.2, 0.4, 0.1, ...]

# 검색할 가장 가까운 벡터의 개수 설정

top_k = 5

# 쿼리 실행

query_result = index.query(vector=query_vector, top_k=top_k)LlamaIndex에서 쿼리 튜닝하기

쿼리 튜닝의 중요성

쿼리 튜닝을 통해 검색 프로세스를 프로젝트의 특정 요구 사항에 맞게 조정할 수 있습니다. 텍스트, 이미지 또는 기타 유형의 데이터를 다루는 경우, 쿼리 튜닝은 쿼리의 정확도와 효율성을 크게 향상시킬 수 있습니다.

쿼리 튜닝을 위한 주요 매개변수:

-

거리 측정 방식(Distance Metric): LlamaIndex를 사용하면 'euclidean' 및 'cosine'과 같은 다양한 거리 측정 방식 중에서 선택할 수 있습니다.

-

유클리드 거리(Euclidean Distance): 이것은 유클리드 공간에서 두 점 사이의 "보통" 직선 거리입니다. 벡터의 크기가 중요할 때 이 거리 측정 방식을 사용합니다.

-

코사인 유사도(Cosine Similarity): 이 거리 측정 방식은 두 벡터 간의 각도의 코사인을 측정합니다. 벡터의 크기보다는 방향에 더 관심이 있는 경우에 사용합니다.

-

-

일괄 처리 크기(Batch Size): 대용량 데이터셋을 다루거나 여러 개의 쿼리를 수행해야 하는 경우, 일괄 처리 크기를 설정하여 한 번에 여러 벡터를 쿼리함으로써 프로세스 속도를 높일 수 있습니다.

쿼리 튜닝의 단계별 안내:

다음은 쿼리 튜닝을 수행하는 방법입니다:

-

거리 측정 방식 선택(Choose the Distance Metric): 특정 요구 사항에 따라 'euclidean'과 'cosine' 중에서 선택합니다.

-

일괄 처리 크기 설정(Set the Batch Size): 한 번에 처리할 벡터의 개수를 결정합니다.

-

쿼리 튜닝된 쿼리 실행(Execute the Fine-Tuned Query): 이번에도 'query' 메서드를 사용하지만, 이번에는 추가 매개변수를 포함합니다.

다음은 이를 설명하는 Python 코드 스니펫입니다:

# 쿼리 벡터 정의

query_vector = [0.2, 0.4, 0.1, ...]

# 검색할 가장 가까운 벡터의 개수 설정

top_k = 5

# 거리 측정 방식 선택

distance_metric = 'euclidean'

# 일괄 처리 크기 설정

batch_size = 100

# 쿼리 튜닝된 쿼리 실행

query_result = index.query(vector=query_vector, top_k=top_k, metric=distance_metric, batch_size=batch_size)이러한 쿼리 튜닝 기술을 숙달함으로써, LlamaIndex 쿼리를 더 정확하고 효율적으로 만들어 고차원 데이터에서 가장 큰 가치를 추출할 수 있습니다.

LlamaIndex로 무엇을 만들 수 있을까요?

기본적인 내용을 이해했지만, LlamaIndex로 실제로 어떤 것을 구축할 수 있을까요? 가능성은 매우 큽니다, 특히 대용량 언어 모델(Large Language Models, LLMs)과의 호환성을 고려할 때입니다.

고급 검색 엔진용 LlamaIndex

LlamaIndex의 가장 흥미로운 사용 사례 중 하나는 고급 검색 엔진 분야입니다. 관련 문서뿐만 아니라 쿼리의 문맥을 이해하는 검색 엔진을 상상해 보세요. LlamaIndex를 사용하면 이를 실현할 수 있습니다.

다음은 LlamaIndex의 키워드 기반 인덱스를 사용하여 기본 검색 엔진을 설정하는 방법을 간단히 보여주는 예시입니다.

# 키워드 기반 인덱스 초기화

from llamaindex import KeywordBasedIndex

search_index = KeywordBasedIndex()

# 일부 문서 추가

search_index.add_text("doc1", "Llamas are awesome.")

search_index.add_text("doc2", "I love programming.")

# 쿼리 실행

results = search_index.query("Llamas", top_k=2)추천 시스템용 LlamaIndex

또 다른 흥미로운 응용 분야는 추천 시스템 구축입니다. 유사한 제품, 기사, 심지어 노래를 제안하는 경우에도 LlamaIndex의 벡터 저장소 인덱스는 게임 체인저가 될 수 있습니다.

다음은 기본 추천 시스템을 설정하는 방법입니다:

# 벡터 저장소 인덱스 초기화

from llamaindex import VectorStoreIndex

rec_index = VectorStoreIndex(dimensions=50)

# 일부 제품 벡터 추가

rec_index.add_vector("product1", [0.1, 0.2, 0.3, ...])

rec_index.add_vector("product2", [0.4, 0.5, 0.6, ...])

# 유사한 제품을 찾기 위한 쿼리 실행

similar_products = rec_index.query(vector=[0.1, 0.2, 0.3, ...], top_k=5)LlamaIndex vs LangChain

대용량 언어 모델(Large Language Models, LLMs)을 활용한 애플리케이션을 개발할 때는 프레임워크 선택이 프로젝트의 성공에 큰 영향을 미칠 수 있습니다. 이 공간에서 주목받고 있는 두 가지 프레임워크는 LlamaIndex와 LangChain입니다. 두 프레임워크는 각각 고유한 기능과 장점을 가지고 있지만, 서로 다른 요구 사항을 충족하고 특정 작업에 최적화되어 있습니다. 이 섹션에서는 기술적인 세부 사항을 자세히 살펴보고, 특히 챗봇 개발을 위한 검색 증강 생성(Retrieval-Augmented Generation, RAG)의 문맥에서 LlamaIndex와 LangChain의 주요 차이점을 이해하는 데 도움이 될 수 있는 샘플 코드를 제공하겠습니다.

핵심 기능 및 기술적 기능

LangChain

-

일반용 프레임워크: LangChain은 다양한 애플리케이션에 대한 다목적 도구로 설계되었습니다. 데이터 로딩, 처리 및 색인 작업 뿐만 아니라 LLM과 상호 작용하는 기능도 제공합니다.

샘플 코드:

const res = await llm.call("Tell me a joke"); -

유연성: LangChain의 특징 중 하나는 그 유연성입니다. 사용자는 응용 프로그램의 동작을 많은 부분 수정할 수 있습니다.

-

고수준 API: LangChain은 LLM(Large Language Models, 대형 언어 모델)과 작업할 때 포함되는 복잡성을 대부분 추상화하여, 간단하고 사용하기 쉬운 고수준 API를 제공합니다.

샘플 코드:

const chain = new SqlDatabaseChain({ llm: new OpenAI({ temperature: 0 }), database: db, sqlOutputKey: "sql", }); const res = await chain.call({ query: "트랙은 몇 개 있나요?" }); -

사전 제공 체인: LangChain은

SqlDatabaseChain과 같은 사전 제공 체인을 기본적으로 제공하여 사용자 정의하거나 새로운 응용 프로그램을 구축하는 기반으로 사용할 수 있습니다.

LlamaIndex

-

검색 및 검색에 특화: LlamaIndex는 검색 및 검색 응용 프로그램 구축을 위해 공학적으로 설계되었습니다. LLM을 쿼리하고 관련 문서를 검색하기 위한 간단한 인터페이스를 제공합니다.

샘플 코드:

query_engine = index.as_query_engine() response = query_engine.query("Stackoverflow은 멋지다.") -

효율성: LlamaIndex는 성능을 최적화하여 대량의 데이터를 신속하게 처리해야하는 응용 프로그램에 더 적합합니다.

-

데이터 연결자: LlamaIndex는 API, PDF, SQL 데이터베이스 등 다양한 소스에서 데이터를 수집할 수 있으며, 이를 통해 LLM 응용 프로그램에 매끄럽게 통합할 수 있습니다.

-

최적화된 인덱싱 : LlamaIndex의 주요 기능 중 하나는 수집된 데이터를 빠르고 효율적으로 쿼리할 수 있도록 최적화된 중간 표현으로 구조화하는 능력입니다.

어떤 프레임워크를 사용해야 할까요?

-

일반용도 응용 프로그램: 융통성과 다용도가 필요한 챗봇을 개발하려면 LangChain이 이상적인 선택입니다. 일반용도 성격과 고수준 API로 인해 다양한 응용 프로그램에 적합합니다.

-

검색 및 검색 중점: 챗봇의 주요 기능이 정보 검색 및 검색인 경우 LlamaIndex가 더 좋은 선택입니다. 특화된 인덱싱 및 검색 기능으로 인해 이러한 작업에 매우 효율적입니다.

-

두 가지를 결합: 일부 시나리오에서는 두 개의 프레임워크를 함께 사용하는 것이 유리할 수 있습니다. LangChain은 일반 기능과 LLM과의 상호작용을 다루는 데 사용될 수 있으며, LlamaIndex는 특화된 검색과 검색 작업을 관리할 수 있습니다. 이 조합은 LangChain의 유연성과 LlamaIndex의 효율성을 활용한 균형잡힌 접근 방식을 제공할 수 있습니다.

결합 사용을 위한 샘플 코드:

# 일반 기능에 대한 LangChain res = llm.call("농담을 해줘") # 특화된 검색에 대한 LlamaIndex query_engine = index.as_query_engine() response = query_engine.query("기후변화에 대해 말해줘.")

그래서 어떤 것을 선택해야 할까요? LangChain 또는 LlamaIndex?

LangChain과 LlamaIndex 중 어떤 것을 선택하거나 둘 다 사용해야 할지는 프로젝트의 구체적인 요구사항과 목표에 따라 결정해야 합니다. LangChain은 더 넓은 범위의 기능을 제공하며, 일반용도 응용 프로그램에 적합합니다. 반면에, LlamaIndex는 효율적인 검색 및 검색을 위해 특화되어 있으며 데이터 집약적인 작업에 적합합니다. 각 프레임워크의 기술적인 세부 사항과 기능을 이해함으로써, 챗봇 개발 요구에 가장 적합한 선택을 할 수 있습니다.

결론

지금까지 LlamaIndex에 대해 꽤 확실하게 이해하셨을 것입니다. 특화된 인덱스부터 다양한 응용 프로그램에 이르기까지, LangChain과 같은 다른 도구보다 우수한 LlamaIndex는 대형 언어 모델과 함께 작업하는 사람들에게 필수적인 도구임을 입증하고 있습니다. 검색 엔진, 추천 시스템 또는 효율적인 쿼리 및 데이터 검색을 필요로하는 모든 응용 프로그램을 구축하려는 경우 LlamaIndex가 적합합니다.

LlamaIndex에 대한 FAQ

LlamaIndex에 대해 가장 일반적인 질문 중 일부를 살펴보겠습니다.

LlamaIndex는 무엇에 사용되나요?

LlamaIndex는 주로 사용자와 대형 언어 모델 간의 중간 계층으로 사용됩니다. 쿼리 실행, 응답 생성 및 데이터 통합에 능숙하며, 검색 엔진이나 추천 시스템과 같은 다양한 애플리케이션에 이상적입니다.

LlamaIndex를 무료로 사용할 수 있나요?

네, LlamaIndex는 오픈 소스 도구로 무료로 사용할 수 있습니다. 소스 코드는 GitHub에서 찾을 수 있으며, 개발에 기여할 수 있습니다.

GPT Index와 LlamaIndex는 무엇인가요?

GPT Index는 텍스트 기반 쿼리에 최적화되어 있으며 일반적으로 GPT(Generative Pre-trained Transformer) 모델과 함께 사용됩니다. 반면, LlamaIndex는 텍스트 기반 및 벡터 기반 쿼리 모두 처리할 수 있는 더 다용도로, 더 다양한 대형 언어 모델과 호환됩니다.

LlamaIndex 아키텍처는 어떻게 되나요?

LlamaIndex는 Vector Store Index 및 Keyword-based Index와 같은 다양한 유형의 인덱스를 포함한 모듈식 아키텍처로 구축되었습니다. 주로 Python으로 작성되었으며, k-NN, TF-IDF 및 BERT 임베딩과 같은 여러 알고리즘을 지원합니다.

최신 LLM 뉴스를 알고 싶으신가요? 최신 LLM 리더보드를 확인해보세요!