QA-LoRA: 대형 언어 모델을 효율적으로 세밀 조정하는 가이드

Published on

대형 언어 모델(LLM)의 매혹적인 우주로 오신 것을 환영합니다! 이 계산 거인들은 챗봇이나 번역기, 내용 생성기 및 추천 시스템 등 다양한 응용 분야의 기반이 되는 중요한 역할을 합니다. 그러나 이러한 모델을 배포하는 것은 쉽지 않습니다. 계산 및 메모리 요구 사항이 상당하여 특수 하드웨어와 많은 인내력이 필요합니다.

여기서 QA-LoRA가 등장합니다. 이 혁신적인 방법은 LLM의 세밀 조정 및 배포를 더 쉽고 효율적으로 만들어줍니다. 따라서 LLM의 계산 부담이 크거나 더 스마트한 방법으로 세밀 조정하려는 경우 올바른 장소에 오셨습니다.

LLM에 대한 QA-LoRA의 혁신적인 기능

최신 LLM 뉴스를 알고 싶나요? 최신 LLM 리더보드를 확인하세요!

QA-LoRA가 정확히 무엇이며 LoRA와 어떻게 다른가요?

세부 사항에 들어가기 전에 주제를 정의해 보겠습니다. QA-LoRA는 Quantization-Aware Low-Rank Adaptation의 약어이다. 간단히 말해, 대형 언어 모델의 세밀 조정을 더 효율적으로 만들기 위해 설계된 방법입니다. 이제 아마도 "그렇다면 LoRA는 무엇인가요?"라고 궁금해할 수도 있습니다. LoRA는 Low-Rank Adaptation의 약어로, 모델의 복잡성을 줄이면서 그 성능을 유지하는 기술입니다. QA-LoRA를 특별하게 만드는 것은 이것이 "quantization-aware" 측면을 가지고 있다는 것입니다.

- Quantization(양자화): 함수가 취할 수 있는 가능한 값을 제한하는 과정입니다. LLM의 맥락에서는 모델의 크기를 줄이는 데 도움이 됩니다.

- Low-Rank Adaptation(저수준 적응): 원래의 고차원 데이터를 저차원 형태로 근사하여 모델의 계산 비용을 줄이는 것입니다.

따라서 이 두 가지 요소인 양자화와 저수준 적응을 결합하면 모델의 크기를 줄이고 계산적으로 효율적인 QA-LoRA를 얻게 됩니다. 이는 제한된 계산 자원을 가진 장치에 LLM을 배포하는 데 중요합니다.

LoRA 방법을 단순화한 것

LoRA 방법은 기본적으로 LLM의 원래 가중치 행렬을 저수준 행렬을 사용하여 근사화하는 방법입니다. 이것은 성능을 양보하지 않으면서 계산 요구 사항을 줄이기 위한 똑똑한 기교입니다. QA-LoRA의 맥락에서는 이 저수준 적응이 양자화와 협력하여 더 효율적인 모델을 제공합니다.

- 단계 1: LLM에서 저수준 근사화에 적합한 가중치 행렬을 식별합니다.

- 단계 2: 특잇값 분해(SVD)와 같은 수학적 기법을 사용하여 이러한 저수준 근사화를 찾습니다.

- 단계 3: 원래의 가중치 행렬을 이러한 저수준 근사화로 대체합니다.

- 단계 4: 모델의 크기를 더 줄이기 위해 양자화를 적용합니다.

이러한 단계를 따라하면, LLM의 계산 부담을 크게 줄일 수 있으므로 배포하기가 쉽고 빠릅니다.

QA-LoRA에서 양자화와 적응의 균형 맞추기

QA-LoRA의 가장 흥미로운 측면 중 하나는 양자화와 적응 사이의 자유도를 어떻게 균형있게 맞추는지입니다. 이 균형은 QA-LoRA가 효율적이고 정확할 수 있도록 하는 데 중요합니다. 너무 많은 양자화는 정확성의 손실을 야기할 수 있으며, 너무 많은 적응은 모델의 계산 비용을 증가시킬 수 있습니다. QA-LoRA는 이 두 가지 사이에서 최적의 균형점을 찾습니다.

- 효율성: 양자화를 사용하여 QA-LoRA는 모델의 크기를 줄여 로드 및 실행 속도를 빠르게 합니다.

- 정확성: 저수준 적응을 통해 모델의 성능을 유지하여 품질을 희생하지 않습니다.

보다시피 QA-LoRA는 효율성과 정확성을 모두 갖춘 균형 잡힌 접근 방식을 제공하여 대형 언어 모델을 효율적으로 세밀 조정하고 배포하려는 사람들에게 권장되는 방법이 됩니다. 이는 기계 학습 분야에서의 혁신적인 기술로서 최고의 효율성과 정확성을 결합하여 획기적인 작업을 수행합니다.

QA-LoRA를 시작하는 방법

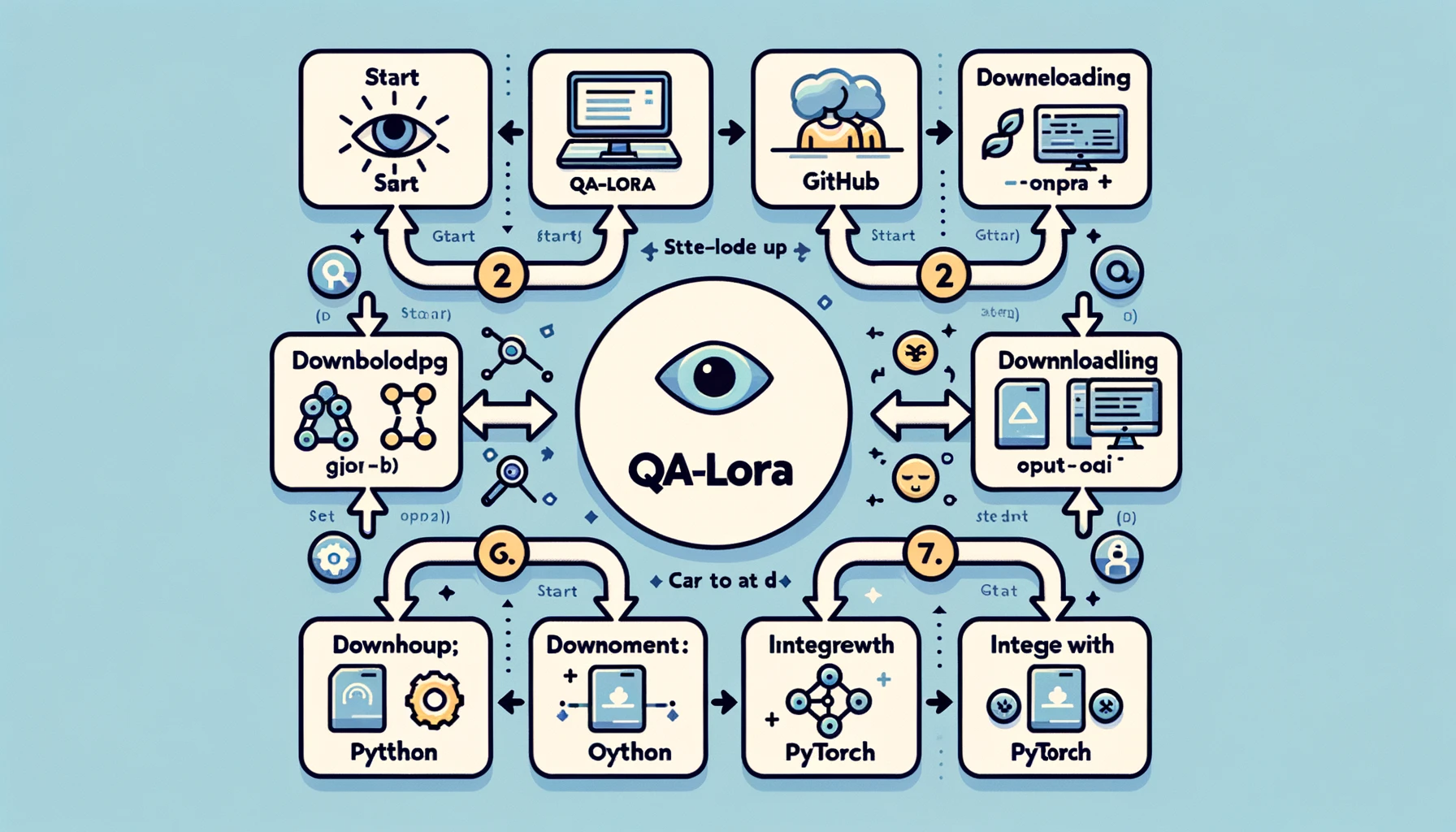

QA-LoRA를 위한 개발 환경 설정

QA-LoRA의 세계로 들어가기 전에 개발 환경을 설정해야 합니다. 이것은 중요한 단계이며, 올바른 설정은 여정을 더 원활하게하고 효율적으로 만들 수 있습니다. 다음은 설정하는 방법입니다:

- 단계 1: 파이썬 설치: 아직 설치하지 않았다면 시스템에 파이썬을 설치하세요. Python 3.x 버전을 권장합니다.

- 단계 2: 가상 환경 설정: 의존성 충돌을 피하기 위해 가상 환경에서 작업하는 것이 좋습니다. 이를 위해

venv또는conda와 같은 도구를 사용할 수 있습니다. - 단계 3: 필요한 라이브러리 설치: PyTorch, NumPy 등의 라이브러리가 필요합니다. 이를 설치하기 위해 pip 또는 conda를 사용하세요.

- 단계 4: GitHub 리포지토리 복제: QA-LoRA에 전용된 GitHub 리포지토리가 있습니다. 샘플 코드와 기타 리소스를 얻으려면 이를 로컬 머신에 클론하세요.

이러한 단계를 따르면 QA-LoRA를 구현할 준비가 된 견고한 개발 환경이 마련됩니다. 이 설정은 구현을 가능한 한 원활하게 만들기 위해 필요한 모든 도구와 라이브러리를 갖추고 있음을 보장합니다.

QA-LoRA 구현: 단계별 안내

이제 환경이 설정되었으므로 실제 구현으로 넘어갈 차례입니다. 이것은 QA-LoRA가 동작하는 곳이며 실제로 작업을 관찰할 수 있습니다. 다음은 QA-LoRA를 구현하기 위한 단계별 안내서입니다:

- 단계 1: 라이브러리 임포트하기: 필요한 모든 라이브러리를 가져오기 시작합니다. 일반적으로 모델에는 PyTorch가 필요하며, 수치 연산에는 NumPy가 필요합니다.

import torch

import numpy as np- 단계 2: 모델 불러오기: 미세 조정하려는 큰 언어 모델을 불러옵니다. 이는 미리 훈련된 모델이나 직접 훈련한 모델일 수 있습니다.

model = torch.load('your_model.pth')-

단계 3: 가중치 행렬 식별하기: 모델에서 저푸근 근사화에 적합한 가중치 행렬을 식별합니다. 일반적으로 완전 연결 레이어입니다.

-

단계 4: 저푸근 근사화 적용하기: 특이값 분해(SVD)와 같은 기법을 사용하여 가중치 행렬을 근사화합니다.

u, s, v = torch.svd(weight_matrix)- 단계 5: 원래 행렬 대체하기: 원래 가중치 행렬을 저푸근 근사화한 행렬로 대체합니다.

approx_matrix = torch.mm(torch.mm(u, torch.diag(s)), v.t())- 단계 6: 양자화 적용하기: 마지막으로, 모델의 크기를 더욱 줄이기 위해 양자화를 적용합니다. 이는 PyTorch의 양자화 유틸리티를 사용하여 수행할 수 있습니다.

quantized_model = torch.quantization.quantize_dynamic(model)이 상세 설명을 따라 하면 QA-LoRA의 작동하는 구현을 얻을 수 있습니다. 이는 모델을 더 효율적으로 만들어주며 성능을 유지하여 최고의 결과를 얻을 수 있습니다.

QA-LoRA 연구의 다음 단계

QA-LoRA는 혁신적인 방법이지만, 이 분야의 연구는 아직 끝나지 않았습니다. 혁신가는 많이 나와 있으며, 계속해서 개선할 여러 가지 방법이 있습니다. 예를 들어, 현재 연구는 정확도를 저하시키지 않고 QA-LoRA를 더욱 효율적으로 만드는 데 초점을 맞추고 있습니다. 양자화와 저푸근 적응 사이의 균형을 미세 조정하는 등의 작업이 이에 속합니다.

- 양자화 최적화: 양자화 과정을 최적화하여 정보 손실을 최소화하는 데 초점을 맞추는 분야입니다.

- 적응형 저푸근 근사화: 모델이 주어진 작업에 기반하여 자체적으로 조정할 수 있는 저푸근 근사화 과정을 만들기 위한 다른 방법입니다.

이러한 지속적인 연구 노력은 QA-LoRA를 더 견고하고 다양하게 만들어주며, 큰 언어 모델의 효율적인 미세 조정 방법으로 유지되도록 합니다.

QA-LoRA Paper에 대해 자세히 읽어보세요. 여기 (opens in a new tab).

QA-LoRA의 중요성에 대한 마무리

QA-LoRA의 실제 세계 응용에 대한 도전과제로 인해, 이 포괄적인 안내서의 끝에 다다르면 윤곽을 잘 살펴볼 필요가 있습니다. 이 방법은 기계 학습 알고리즘의 무한히 확장되는 바다에 던져진 또 다른 기술 전문 용어가 아닙니다. 이는 대규모 언어 모델을 배포하는 실제 도전에 대응하는 중요한 진보입니다.

-

효율성: QA-LoRA의 가장 매력적인 장점 중 하나는 효율성입니다. 양자화와 저푸근 적응을 결합하여, LLM의 계산 및 메모리 요구 사항을 크게 줄입니다. 이는 대규모로 이러한 모델을 배포하거나 자원이 제한된 장치에 설치하는 개발자 및 조직에 큰 도움이 됩니다.

-

정확도: QA-LoRA는 성능에 대해 저하하지 않습니다. 효율성에도 불구하고, 이 방법은 모델의 정확도를 유지하여 고품질의 결과를 얻을 수 있습니다. 이 효율성과 정확도 사이의 균형은 QA-LoRA를 다른 미세 조정 방법과 구별 짓는 것입니다.

-

다양성: 이 방법은 다양한 종류의 대규모 언어 모델에 적용할 수 있는 유연성이 있습니다. 자연 언어 처리, 컴퓨터 비전 또는 기타 모든 도메인에서 작업하는 경우에도 QA-LoRA를 필요에 맞게 적용할 수 있습니다.

-

구현의 용이성: 사용 가능한 코드와 지원 커뮤니티로 인해, QA-LoRA를 구현하는 것은 이전보다 쉬워졌습니다. 기계 학습 전문가가 아니더라도, 이 방법은 접근 가능하고 간단하게 적용할 수 있습니다.

요약하자면, QA-LoRA는 단순히 미세 조정 방법에 불과한 것이 아니라, 대규모 언어 모델의 배포 방식에 대한 패러다임 전환입니다. 이는 균형, 효율성 및 효과적인 방법을 통해 이러한 계산 거인들을 실제 실세계 응용에 더 가깝게 가져오는 것을 제공합니다. 기계 학습 분야에 종사하시거나 대규모 언어 모델의 잠재력에 관심이 있다면, QA-LoRA는 무시할 수 없는 주제입니다.

결론

대규모 언어 모델의 세계는 흥미로우나 배포 시 발생하는 도전 과제로 인해 어려움이 있습니다. QA-LoRA는 이러한 모델을 미세 조정하기 위한 균형 잡힌 효율적인 방법으로 나타납니다. 기술적인 복잡성에서부터 실제 적용까지, QA-LoRA는 효율과 정확도가 함께 갈 때 어떤 결과를 얻을 수 있는지에 대한 증언입니다.

따라서 대규모 언어 모델을 활용한 다음 프로젝트를 시작할 때, QA-LoRA가 효율적이고 효과적인 미세 조정을 위한 신뢰할 수 있는 동반자라는 것을 기억해주세요. 이것을 시도해보고, 기계 학습의 새로운 기준을 세우는 혁명에 참여하세요.

최신 LLM 뉴스를 알고 싶으세요? 최신 LLM leaderboard를 확인하세요!