Guanaco 65B:开源细调的聊天机器人挑战GPT-4

Published on

在不断发展的人工智能领域中,文本生成模型已经成为各种应用的基石,从聊天机器人到内容创作。Guanaco 65B作为一种具有重要能力的革命性模型脱颖而出。但是它有何特别之处?在这份全面的指南中,我们将深入探讨Guanaco 65B的细节,探索其不同版本、兼容性特点,甚至如何使用它。

如果你是一名开发者、数据科学家或者只是对人工智能感兴趣的人,了解Guanaco 65B可能是你在这个领域迈出的下一个重要一步。无论你是想生成文本、分析数据还是开发新应用,这份指南都将成为你的终极资源。那么,让我们开始吧!

想了解最新的LLM新闻吗?查看最新的LLM排行榜吧!

Guanaco 65B是什么以及为什么你应该关注它?

Guanaco 65B是一种最先进的语言模型,用于文本生成。它不仅仅是又一个模型,它是一种灵活而强大的工具,有各种版本以适应不同的硬件需求。无论你是使用CPU还是高端GPU,都有适合你的Guanaco 65B。现在,让我们来分解这些版本吧。

对Guanaco 65B进行基准测试:它的表现如何?

当评估像Guanaco 65B这样的语言模型的性能时,基准测试至关重要。它们提供了一种标准化的方法来衡量速度、准确性和整体能力等各个方面。然而,基准测试并不是评估模型效果的唯一方法。用户体验和社区讨论也提供了宝贵的见解。

不幸的是,截至目前,Guanaco 65B尚未列在任何官方排行榜上。然而,值得注意的是:

- 细调: Guanaco 65B是为65B架构提供的少数细调模型之一,这使其独具一格。

- 专业任务: 该模型与QLoRA的兼容性暗示它在基于查询的任务中可能表现出色,尽管这需要经验验证。

Guanaco 65B的优势

使用该模型后,以下是Guanaco-65B的优势:

- 速度和效率: 一些用户发现65B版本较慢,影响了其在某些任务中的可用性。

- 角色扮演和角色一致性: 用户注意到Guanaco模型在保持角色一致性方面表现出色,特别是在使用角色卡片时。

- 文本生成: Guanaco模型因其能够在有效理解提示的同时生成大量文本而备受赞誉。

Guanaco 65B许可

在深入了解Guanaco 65B的世界之前,了解每个版本随附的许可条款是至关重要的。不同的许可协议规定了您可以如何使用、修改和分发该模型。

- 开源许可证: 一些版本使用开源许可证,允许免费使用和修改。

- 商业许可证: 其他版本可能需要商业许可证,特别是如果您计划在盈利环境中使用该模型。

您可以在Guanaco 65B Huggingface页面上查看这里 (opens in a new tab)。

使用Guanaco 65B的逐步指南

在文本生成模型的世界中探索可能是令人生畏的,尤其是对于新手来说。这就是为什么我们准备了一份全面的、逐步指南,帮助您快速上手使用Guanaco 65B。

第1步:下载Guanaco 65B

在开始生成文本之前,您需要下载最适合您需求的Guanaco 65B模型。下面是具体步骤:

- 访问Hugging Face资源库: 前往Hugging Face网站,搜索您想要的Guanaco 65B版本。

- 选择模型: 点击模型以进入其专门页面。

- 复制模型名称: 您将在页面顶部附近找到模型名称。将其复制以备后用。

第2步:使用Guanaco 65B生成文本

下载模型后,就可以编写一些代码了。下面是一个示例Python代码片段,演示如何使用Guanaco 65B生成文本。

from transformers import AutoTokenizer, AutoModelForCausalLM

# 初始化tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# 准备文本输入

input_text = "Tell me a joke."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# 生成文本

output = model.generate(input_ids)

# 解码并打印生成的文本

print(tokenizer.decode(output[0], skip_special_tokens=True))要运行此代码,请确保已安装transformers库。如果没有安装,可以使用pip安装:

pip install transformers这就是了,一种简单而有效的使用Guanaco 65B生成文本的方法。无论您是构建聊天机器人、内容生成器还是任何其他基于文本的应用,该模型都能满足您的需求。

第3步:在Google Colab中使用Guanaco 65B

对于那些更喜欢动手操作的人来说,Guanaco 65B可以轻松在Google Colab笔记本中实现。这样您就可以在没有任何设置麻烦的情况下实验该模型。

- 易于使用: 只需将模型导入Colab笔记本,即可开始使用。

- Collaboration: Colab的共享功能使项目的协作变得轻松。

在Google Colab中使用Guanaco 65B的快速代码段:

# 在Google Colab中使用Guanaco 65B的示例代码

# 确保先安装transformers库

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "什么是人工智能?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Guanaco 65B的不同版本

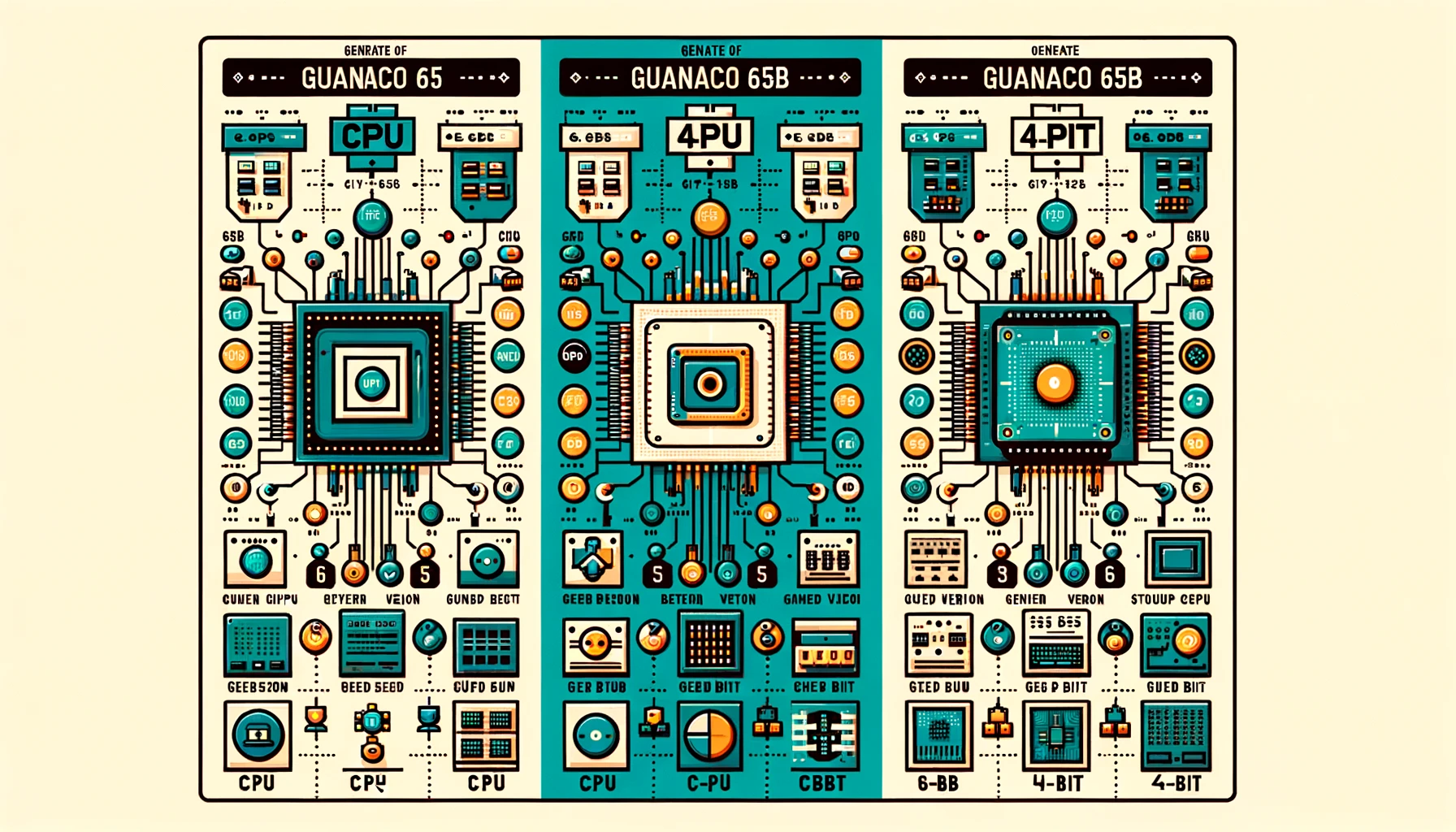

使用4位Guanaco 65B版本

当优化性能和内存时,4位Guanaco 65B-GPTQ版本是一个改变游戏规则的因素。这个变种旨在在GPU上运行,但却有了一个新的变化-它使用量化来减少模型的大小,而不明显损害其性能。

特点:

- 减少内存占用:4位量化大大减少了VRAM的需求。

- 多个量化参数:根据您的具体需求进行定制。

- 接近原始性能:尽管大小减小,但模型仍保持较高的准确性。

适用人群:

- 专注于高效机器学习的研究人员

- GPU资源有限的开发人员

- 对边缘计算感兴趣的任何人

以下是使用Guanaco 65B-GPTQ的示例代码段:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "天气如何?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))通过选择适合的Guanaco 65B版本,您可以根据您的硬件能力来定制您的文本生成任务。无论是CPU、GPU还是4位版本,每个版本都提供了独特的优势,以迎合广泛的需求。

使用Guanaco 65B和QLoRA

Guanaco 65B的一个突出特点是其与QLoRA的兼容性,这是一种基于查询的语言模型。这个特性使您能够执行更具体和针对性的文本生成任务。

- 基于查询的任务:非常适合搜索引擎或推荐系统。

- 提高准确性:QLoRA的兼容性确保了更准确和相关的文本生成。

以下是使用Guanaco 65B和QLoRA的示例代码段:

# 使用Guanaco 65B和QLoRA的示例代码

# 注意:这是一个假设性的示例,实际实现可能会有所不同。

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "法国的首都是哪里?"

response = qlora_model.generate(query)

print(response)结论:为什么Guanaco 65B是一种改变游戏规则的因素

在完成这个全面的指南时,很明显Guanaco 65B不仅仅是另一个文本生成模型。它是一个多功能、强大且高度可定制的工具,以满足各种应用和硬件设置的需求。从不同的版本到与QLoRA等基于查询的模型的兼容性,Guanaco 65B在文本生成领域真正改变了游戏规则。

无论您是经验丰富的开发人员还是好奇的爱好者,这个模型都为每个人提供了一些东西。那么,还等什么呢?立即深入Guanaco 65B的世界,解锁文本生成的未来!

想了解最新的LLM新闻吗?请查看最新的LLM排行榜!