Guanaco 65B: Open Source Feinabgestimmte Chatbots, die GPT-4 herausfordern

Published on

In der sich ständig weiterentwickelnden Landschaft der künstlichen Intelligenz sind Textgenerierungsmethoden zu Eckpfeilern verschiedener Anwendungen geworden, von Chatbots bis hin zur Content-Erstellung. Guanaco 65B zeichnet sich als revolutionäres Modell aus, das aufgrund seiner Fähigkeiten erhebliche Aufmerksamkeit auf sich gezogen hat. Aber was macht es so besonders? In diesem umfassenden Leitfaden gehen wir ins Detail von Guanaco 65B ein und erkunden seine verschiedenen Versionen, Kompatibilitätsfunktionen und sogar wie man es nutzen kann.

Wenn Sie ein Entwickler, Data Scientist oder einfach nur ein KI-Enthusiast sind, kann das Verständnis von Guanaco 65B Ihr nächster großer Schritt im Bereich sein. Ob Sie Text generieren, Daten analysieren oder eine neue Anwendung entwickeln möchten, dieser Leitfaden dient als ultimative Ressource. Also, lasst uns anfangen!

Sie möchten die neuesten LLM News erfahren? Schauen Sie sich die neueste LLM-Bestenliste an!

Was ist Guanaco 65B und warum sollten Sie sich dafür interessieren?

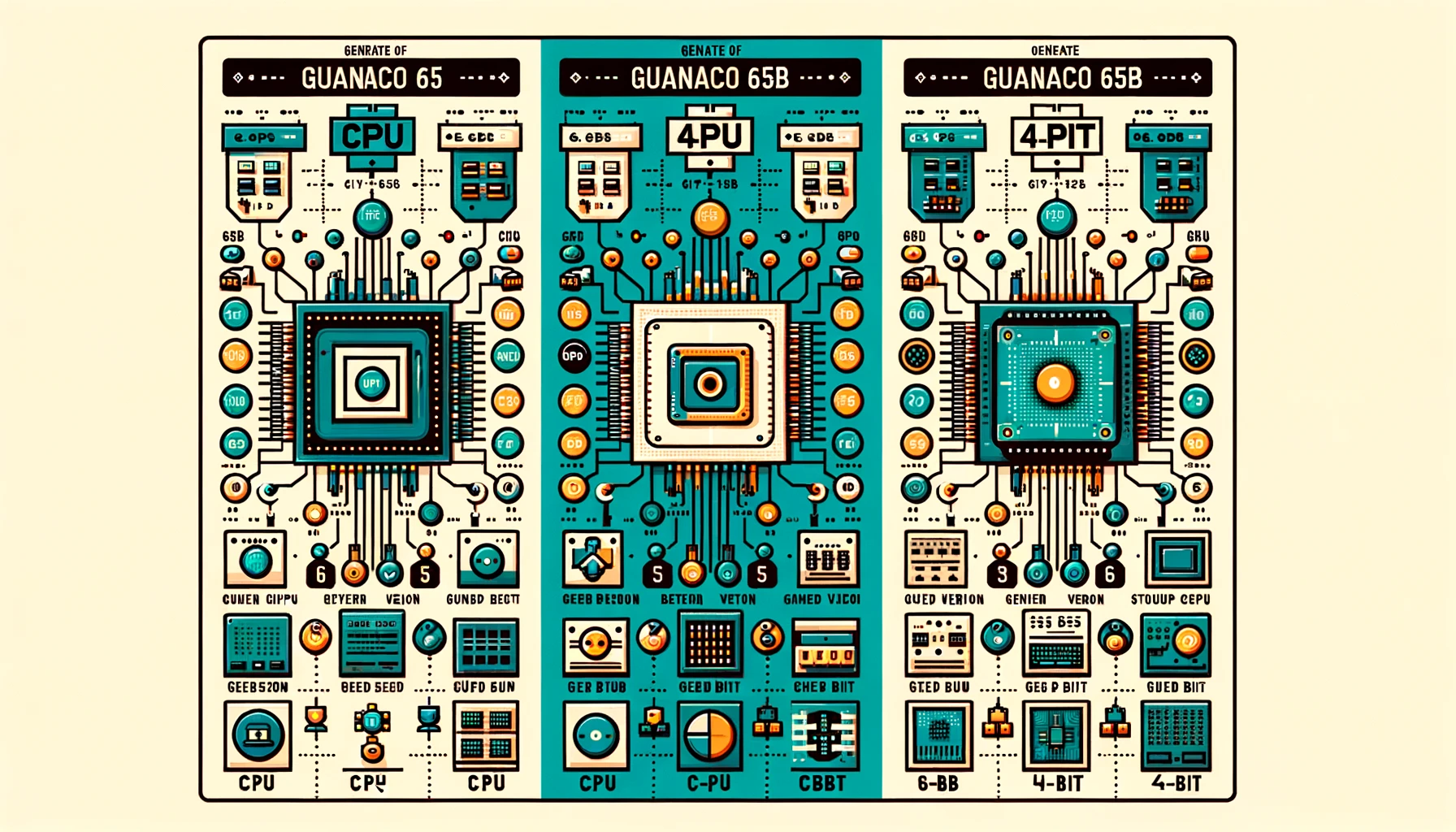

Guanaco 65B ist ein hochmoderner Sprachmodell, das für die Textgenerierung entwickelt wurde. Es ist nicht nur ein weiteres Modell; es ist ein flexibles und leistungsstarkes Werkzeug, das in verschiedenen Versionen erhältlich ist, um unterschiedlichen Hardware-Anforderungen gerecht zu werden. Egal, ob Sie mit einer CPU oder einer High-End-GPU arbeiten, es gibt ein Guanaco 65B für Sie. Lassen Sie uns nun diese Versionen genauer betrachten.

Benchmarking von Guanaco 65B: Wie schlägt es sich?

Wenn es darum geht, die Leistung von Sprachmodellen wie Guanaco 65B zu bewerten, sind Benchmarks entscheidend. Sie bieten eine standardisierte Möglichkeit, verschiedene Aspekte wie Geschwindigkeit, Genauigkeit und Gesamtfähigkeiten zu messen. Benchmarks sind jedoch nicht der einzige Weg, um die Effektivität eines Modells zu beurteilen. Erfahrungen von Benutzern und Community-Diskussionen bieten ebenfalls wertvolle Einblicke.

Leider ist Guanaco 65B derzeit nicht in offiziellen Bestenlisten aufgeführt. Es ist jedoch erwähnenswert, dass:

- Feinabstimmung: Guanaco 65B ist eines der wenigen feinabgestimmten Modelle für die 65B-Architektur und damit einzigartig.

- Spezialisierte Aufgaben: Die Kompatibilität des Modells mit QLoRA legt nahe, dass es möglicherweise in anfragebasierten Aufgaben hervorragende Leistungen erzielt, obwohl dies noch empirisch überprüft werden muss.

Vorteile von Guanaco 65B

Nach der Nutzung des Modells ergeben sich folgende Vorteile von Guanaco-65B:

- Geschwindigkeit und Effizienz: Einige Benutzer fanden heraus, dass die 65B-Version langsamer ist und sich dadurch für bestimmte Aufgaben weniger gut eignet.

- Rollenspiel und Charakterkonsistenz: Benutzer haben festgestellt, dass Guanaco-Modelle bei der Aufrechterhaltung einer konsistenten Charakterdarstellung besonders gut sind, insbesondere wenn Charakterkarten verwendet werden.

- Textgenerierung: Guanaco-Modelle werden für ihre Fähigkeit, große Mengen an Text zu generieren und dabei die Aufgabenstellung effektiv zu verstehen, gelobt.

Guanaco 65B-Lizenzierung

Bevor Sie in die Welt von Guanaco 65B eintauchen, ist es wichtig, die Lizenzbedingungen zu verstehen, die mit jeder Version verbunden sind. Unterschiedliche Lizenzen regeln, wie Sie das Modell verwenden, bearbeiten und verbreiten können.

- Open Source Lizenzen: Einige Versionen werden unter Open-Source-Lizenzen bereitgestellt, die eine kostenlose Nutzung und Bearbeitung ermöglichen.

- Kommerzielle Lizenzen: Andere Versionen erfordern möglicherweise eine kommerzielle Lizenz, insbesondere wenn Sie das Modell in einem profitablen Umfeld verwenden möchten.

Die Guanaco 65B-Huggingface-Seite finden Sie hier (opens in a new tab).

Eine schrittweise Anleitung zur Verwendung von Guanaco 65B

Die Navigation durch die Welt der Textgenerierungsmodelle kann insbesondere für Neueinsteiger auf diesem Gebiet einschüchternd sein. Aus diesem Grund haben wir eine umfassende Schritt-für-Schritt-Anleitung vorbereitet, um Ihnen den Einstieg und die Arbeit mit Guanaco 65B zu erleichtern.

Schritt 1. Guanaco 65B herunterladen

Bevor Sie mit der Textgenerierung beginnen können, müssen Sie das Guanaco 65B-Modell herunterladen, das am besten zu Ihren Bedürfnissen passt. So geht's:

- Besuchen Sie das Hugging Face Repository: Gehen Sie zur Hugging Face-Website und suchen Sie nach der gewünschten Guanaco 65B-Version.

- Wählen Sie das Modell aus: Klicken Sie auf das Modell, um zur dedizierten Seite zu gelangen.

- Kopieren Sie den Modellnamen: Den Modellnamen finden Sie in der Nähe der oberen Seite. Kopieren Sie ihn zur späteren Verwendung.

Schritt 2. Textgenerierung mit Guanaco 65B

Sobald Sie das Modell heruntergeladen haben, ist es Zeit, etwas Code zu schreiben. Unten finden Sie ein Python-Code-Snippet, das zeigt, wie man Text mit Guanaco 65B generiert.

from transformers import AutoTokenizer, AutoModelForCausalLM

# Initialisieren Sie den Tokenizer und das Modell

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# Bereiten Sie den Texteingabe vor

input_text = "Erzähl mir einen Witz."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# Generieren Sie Text

output = model.generate(input_ids)

# Dekodieren und drucken Sie den generierten Text

print(tokenizer.decode(output[0], skip_special_tokens=True))Um diesen Code auszuführen, stellen Sie sicher, dass Sie die Bibliothek transformers installiert haben. Falls nicht, können Sie sie mit pip installieren:

pip install transformersUnd da haben Sie es - eine einfache, aber effektive Möglichkeit, Text mit Guanaco 65B zu generieren. Egal, ob Sie einen Chatbot, einen Inhalte-Generator oder eine andere textbasierte Anwendung erstellen möchten, dieses Modell hat alles, was Sie brauchen.

Schritt 3. Verwendung von Guanaco 65B mit Google Colab

Für diejenigen, die einen praxisnäheren Ansatz bevorzugen, kann Guanaco 65B problemlos in Google Colab-Notebooks implementiert werden. Dadurch können Sie mit dem Modell experimentieren, ohne unnötigen Aufwand für die Einrichtung betreiben zu müssen.

- Benutzerfreundlichkeit: Importieren Sie das Modell einfach in ein Colab-Notebook und beginnen Sie mit der Verwendung.

- Zusammenarbeit: Die Sharing-Funktionen von Colab erleichtern die Zusammenarbeit an Projekten.

Hier ist ein kurzes Code-Snippet, um Guanaco 65B in Google Colab zu verwenden:

# Beispielcode zur Verwendung von Guanaco 65B in Google Colab

# Stellen Sie sicher, dass Sie zuerst die Transformers-Bibliothek installieren

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "Was ist KI?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Unterschiedliche Versionen von Guanaco 65B

Verwendung der 4-Bit Guanaco 65B-Version

Wenn es darum geht, sowohl die Leistung als auch den Speicherplatz zu optimieren, ist die 4-Bit Guanaco 65B-GPTQ-Version eine Revolution. Diese Variante wurde entwickelt, um auf GPUs zu laufen, aber mit einem Twist - sie verwendet Quantisierung, um die Größe des Modells zu reduzieren, ohne die Leistung signifikant zu beeinträchtigen.

Features:

- Reduzierter Speicherbedarf: Die 4-Bit-Quantisierung reduziert den VRAM-Bedarf drastisch.

- Mehrere Quantisierungsparameter: Ermöglicht Anpassungen gemäß Ihren spezifischen Anforderungen.

- Nahezu ursprüngliche Leistung: Trotz der reduzierten Größe behält das Modell ein hohes Maß an Genauigkeit bei.

Wer sollte es verwenden?

- Forscher, die sich auf effizientes maschinelles Lernen konzentrieren

- Entwickler mit begrenzten GPU-Ressourcen

- Jeder, der sich für Edge Computing interessiert

Hier ist ein Beispielcode-Snippet zur Verwendung von Guanaco 65B-GPTQ:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "Wie ist das Wetter?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Durch die Auswahl der richtigen Version von Guanaco 65B können Sie Ihre Textgenerierungsaufgaben an Ihre Hardware anpassen. Ob CPU, GPU oder die 4-Bit-Version - jede bietet einzigartige Vorteile, die den unterschiedlichsten Anforderungen gerecht werden.

Verwenden Sie Guanaco 65B mit QLoRA

Eine der herausragenden Funktionen von Guanaco 65B ist seine Kompatibilität mit QLoRA, einem auf Abfragen basierenden Sprachmodell. Diese Funktion ermöglicht es Ihnen, spezifischere und gezieltere Textgenerierungsaufgaben durchzuführen.

- Abfragebasierte Aufgaben: Ideal für Suchmaschinen oder Empfehlungssysteme.

- Erhöhte Genauigkeit: QLoRA-Kompatibilität gewährleistet präzisere und relevantere Textgenerierung.

Hier ist ein Beispielcode-Snippet zur Verwendung von Guanaco 65B mit QLoRA:

# Beispielcode zur Verwendung von Guanaco 65B mit QLoRA

# Hinweis: Dies ist ein hypothetisches Beispiel; die tatsächliche Implementierung kann variieren.

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "Was ist die Hauptstadt von Frankreich?"

response = qlora_model.generate(query)

print(response)Fazit: Warum Guanaco 65B eine Revolution ist

Während wir diesen umfassenden Leitfaden abschließen, wird deutlich, dass Guanaco 65B nicht einfach nur ein weiteres Textgenerierungsmodell ist. Es ist ein vielseitiges, leistungsstarkes und hochgradig anpassbares Werkzeug, das eine Vielzahl von Anwendungen und Hardware-Konfigurationen abdeckt. Von den verschiedenen Versionen bis zur Kompatibilität mit auf Abfragen basierenden Modellen wie QLoRA ist Guanaco 65B wahrhaftig eine Revolution auf dem Gebiet der Textgenerierung.

Egal, ob Sie ein erfahrener Entwickler oder ein neugieriger Enthusiast sind, dieses Modell bietet für jeden etwas. Warum also warten? Tauchen Sie ein in die Welt von Guanaco 65B und schalten Sie noch heute das Potenzial der Textgenerierung frei!

Möchten Sie die neuesten LLM-Nachrichten erfahren? Schauen Sie sich das aktuelle LLM-Leaderboard an!