Gedankenkettens-Prompting: Entfesseln Sie die Power von LLMs anhand von Beispielen

Published on

Willkommen zu diesem umfassenden Leitfaden zum Gedankenhettens-Prompting! Wenn Sie sich jemals gefragt haben, wie Sie die Denkfähigkeiten großer Sprachmodelle verbessern können, sind Sie hier genau richtig. Diese Technik ist ein Game-Changer auf dem Gebiet des maschinellen Lernens und der natürlichen Sprachverarbeitung.

In diesem Artikel werden wir tief in das Gedankenkettens-Prompting eintauchen, was es ist, wie es funktioniert, seine vielfältigen Vorteile und praktischen Anwendungen. Wir werden auch untersuchen, wie diese Technik in verschiedenen Kontexten wie Langchain, ChatGPT und Python angewendet wird. Also lassen Sie uns anfangen!

Was ist Gedankenkettens-Prompting?

Das Gedankenkettens-Prompting ist eine Technik, die große Sprachmodelle dazu ermutigt, logisch und sequentiell zu denken. Im Gegensatz zu traditionellen Prompting-Methoden bewertet das Modell im Rahmen des Gedankenkettens-Promptings seine Denkweise in jeder Phase und kann bei Bedarf auf alternative Methoden umschalten. Dies führt zu präziseren und zuverlässigeren Ergebnissen.

Wie funktioniert es?

Die Grundidee besteht darin, dem großen Sprachmodell eine Reihe von Prompts zu geben, die seinen Denkprozess lenken. Jeder Prompt dient als "Gedankenknoten", und das Modell muss den Ausgang jedes Knotens bewerten, bevor es zum nächsten übergeht. Auf diese Weise kann das Modell sich selbst korrigieren, wenn es vom Kurs abkommt.

Die Implementierung des Gedankenkettens-Promptings ähnelt dem Erstellen einer Roadmap für Ihr Sprachmodell. Hier ist, wie es gemacht wird:

- Problembestimmung: Definieren Sie deutlich das mehrschrittige Problem, das Sie vom Sprachmodell lösen möchten.

- Zerlegen Sie es in kleinere Aufgaben: Zerlegen Sie das Problem in kleinere Aufgaben oder Fragen, die zur endgültigen Lösung führen.

- Erstellen Sie Prompts: Für jede kleinere Aufgabe erstellen Sie einen Prompt, der das Sprachmodell lenkt.

- Ausführen: Geben Sie diese Prompts in einer Sequenz an das Sprachmodell weiter und sammeln Sie die Ausgaben bei jedem Schritt.

- Analysieren und verfeinern: Bewerten Sie die Ausgaben und verfeinern Sie die Prompts bei Bedarf.

Beispiel: Angenommen, Sie möchten ein mathematisches Textproblem lösen, bei dem die Durchschnittsgeschwindigkeit eines Autos auf einer Reise berechnet werden soll. Anstatt das Modell direkt zu fragen, können Sie es in Schritte zerlegen:

- Berechnen Sie die insgesamt zurückgelegte Strecke.

- Berechnen Sie die insgesamt benötigte Zeit.

- Berechnen Sie die Durchschnittsgeschwindigkeit mit der Formel:

Durchschnittsgeschwindigkeit = Gesamtstrecke / Gesamtzeit

Vorteile des Gedankenkettens-Promptings

Verbesserte Denkfähigkeit und Problemlösung

Einer der überzeugendsten Vorteile des Gedankenkettens-Promptings besteht in seiner Fähigkeit, die Denkfähigkeiten großer Sprachmodelle signifikant zu verbessern. Traditionelle Sprachmodelle stoßen oft an ihre Grenzen, wenn es um mehrschrittige oder komplexe Denkaufgaben geht. Das Gedankenkettens-Prompting beseitigt diese Grenzen effektiv.

- Genauigkeit: Durch die Zerlegung eines Problems in kleinere Aufgaben kann das Modell sich auf jeden Schritt konzentrieren, was zu genaueren Ergebnissen führt.

- Komplexe Aufgaben: Egal, ob es darum geht, mathematische Probleme zu lösen oder komplexe Szenarien zu verstehen, das Gedankenkettens-Prompting rüstet Sprachmodelle effizient dafür aus.

Gedankenkettens-Prompting in ChatGPT

Beispiele für Gedankenkettens-Prompting

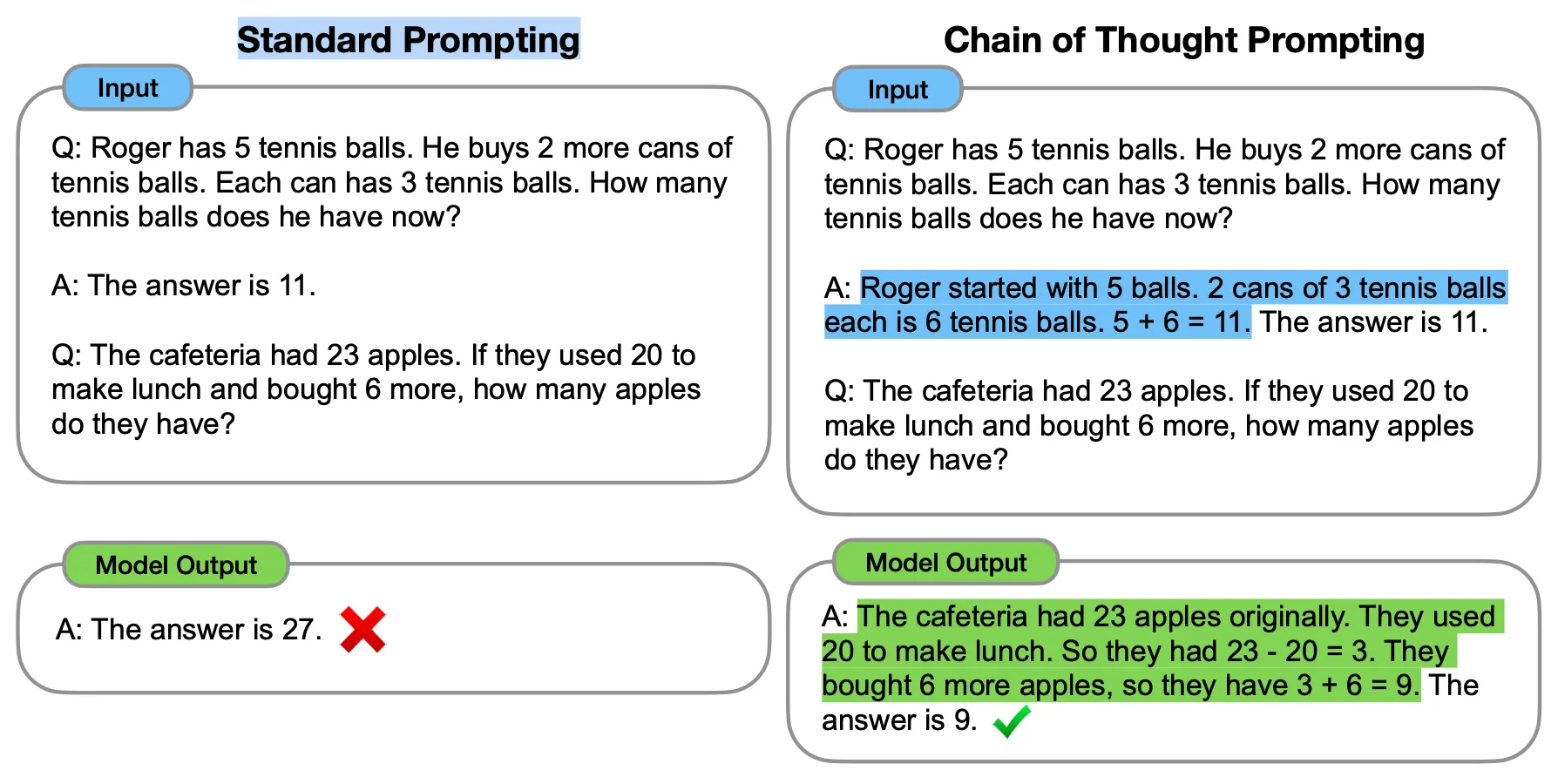

Das Gedankenkettens-Prompting, oder CoT, ist eine innovative Technik, die darauf abzielt, große Sprachmodelle wie ChatGPT in ihrer Denkfähigkeit zu verbessern. Im Gegensatz zu traditionellen Prompting-Methoden verwendet das Gedankenkettens-Prompting eine Reihe von "few-shot exemplars", die das Modell durch eine logische Sequenz von Schritten führen. Dies führt zu präziseren und zuverlässigeren Ergebnissen.

Die Hauptidee hinter dem Gedankenkettens-Prompting besteht darin, diese "few-shot exemplars" zu verwenden, um den logischen Denkprozess explizit darzustellen. Wenn das Modell auf diese Weise gepromptet wird, zeigt es auch seine Denkschritte auf, was zu präziseren und aufschlussreicheren Antworten führt.

Gedankenkettens-Prompting-Benchmarks

Beispielsweise wurde GPT-3 (davinci-003) mit einem einfachen Textproblem getestet. Anfangs konnte es das Problem nicht mit traditionellem Prompting lösen. Wenn jedoch das Gedankenkettens-Prompting angewendet wurde, konnte das Modell das gleiche Problem erfolgreich lösen. Dies zeigt die Wirksamkeit des Gedankenkettens-Prompting bei der Verbesserung der Problemlösungsfähigkeiten des Modells.

Das Gedankenkettens-Prompting hat sich als äußerst effektiv bei der Verbesserung der Leistung von LLMs in verschiedenen Aufgaben erwiesen, einschließlich Arithmetik, gesundem Menschenverstand und symbolischem Denken. Insbesondere haben Modelle, die mit Gedankenkettens-Prompting gepromptet wurden, auf dem GSM8K-Benchmark eine Genauigkeit von 57% erreicht, was zu dieser Zeit als das Beste galt.

!Gedankenkettens-Prompting-Benchmarks](https://raw.githubusercontent.com/lynn-mikami/Images/main/chain-of-thought-prompting-chatgpt-3.webp (opens in a new tab))

Es ist erwähnenswert, dass das Gedankenkettens-Prompting am effektivsten in Verbindung mit größeren Modellen ist, insbesondere solchen mit etwa 100 Milliarden Parametern. Kleinere Modelle neigen dazu, unlogische Gedankenketten zu erzeugen, was sich negativ auf die Genauigkeit auswirken kann. Daher stehen die Leistungsgewinne durch das Gedankenkettens-Prompting im Allgemeinen in proportionalem Verhältnis zur Größe des Modells.

Gedankenkettens-Prompting in LangChain

So verwendet Langchain Gedankenkettens-Prompting in Python:

from langchain.chains import SequentialChain

# Die Ketten definieren

Kette1 = ...

Kette2 = ...

Kette3 = ...

Kette4 = ...

# Die Ketten verbinden

gesamte_kette = SequentialChain(chains=[Kette1, Kette2, Kette3, Kette4], input_variables=["Eingabe", "perfekte_faktoren"], output_variables=["sortierte_loesungen"], verbose=True)

# Die gesamte Kette ausführen

print(overall_chain({"input": "Menschliche Besiedlung des Mars", "perfect_factors": "Die Entfernung zwischen Erde und Mars ist sehr groß, was regelmäßige Nachschübe schwierig macht"}))Dieser Codeausschnitt zeigt, wie Langchain verschiedene Ketten mit Hilfe der Klasse SequentialChain verbindet. Die Ausgabe einer Kette wird zur Eingabe der nächsten, was eine komplexe Gedankenkette ermöglicht.

Fazit

Zusammenfassung der wichtigsten Punkte

Wir haben die faszinierende Welt des Chain of Thought Prompting (CoT) erkundet, eine Technik, die die Art und Weise, wie Large Language Models (LLMs) wie ChatGPT und Langchain arbeiten, revolutioniert. Im Gegensatz zu herkömmlichen Promoting-Methoden führt CoT das Modell durch eine logische Sequenz von Schritten, wodurch seine Denk- und Problemlösungsfähigkeiten verbessert werden. Dies führt insbesondere in Aufgaben, die komplexes Denken erfordern, zu präziseren und zuverlässigeren Ergebnissen.

Warum CoT bahnbrechend ist

CoT ist mehr als nur eine neue Technik; es ist ein Game-Changer auf dem Gebiet des maschinellen Lernens und der natürlichen Sprachverarbeitung. Durch die Verbesserung der Artikulation des Modells in seinem Denken eröffnet CoT neue Möglichkeiten für Anwendungen, die komplexe Problemlösung und logisches Denken erfordern. Ob es sich um arithmetische Aufgaben, gesunder Menschenverstand oder symbolisches Denken handelt, CoT hat sich als deutliche Verbesserung der Leistungsmetriken erwiesen.

FAQs

Was ist das Chain of Thought Prompting in Langchain?

In Langchain wird das Chain of Thought Prompting durch einen Baum von Gedanken (Tree of Thoughts, ToT) Algorithmus umgesetzt, der LLMs und heuristische Suche kombiniert. Dadurch kann die Plattform komplexere sprachliche Aufgaben bewältigen, indem das Modell durch eine Reihe logischer Schritte geführt wird.

Was ist die Strategie der Gedankenkette?

Die Strategie der Gedankenkette ist eine Methode, die den Denkprozess eines Modells durch eine Reihe logischer Schritte oder "Gedankenknoten" leitet. Jeder Knoten dient als Aufforderung, die das Modell bewerten muss, bevor es zum nächsten übergeht, was es ihm ermöglicht, sich zu korrigieren, falls es vom richtigen Weg abkommt.

Was ist ein Beispiel für eine Gedankenkette?

Ein Beispiel für eine Gedankenkette wäre die Aufteilung eines komplexen mathematischen Problems in kleinere Aufgaben und deren schrittweise Lösung. Wenn zum Beispiel das Problem darin besteht, die Fläche eines Trapezes zu berechnen, könnte die Gedankenkette die Berechnung des Durchschnitts der beiden parallelen Seiten, die Bestimmung der Höhe und schließlich die Multiplikation der beiden Werte zur Berechnung der Fläche beinhalten.