Verständnis des Few-Shot Prompting in der Prompt Engineering

Published on

Einführung in das Few-Shot Prompting

Willkommen in der faszinierenden Welt des Few-Shot Prompting in der Prompt Engineering! Wenn Sie sich schon den Kopf zerbrochen haben und sich fragen, wie Sie Ihre Sprachmodelle mit minimalen Beispielen spezifische Aufgaben erledigen lassen können, sind Sie hier genau richtig. Dieser Artikel soll Ihre Ressource sein, um die Ins und Outs des Few-Shot Prompting zu verstehen.

In den nächsten Abschnitten werden wir uns mit der Mechanik, den Typen und den praktischen Beispielen des Few-Shot Prompting beschäftigen. Am Ende dieser Lektüre werden Sie nicht nur das Konzept verstehen, sondern auch wissen, wie man es effektiv umsetzt. Also, lassen Sie uns anfangen!

Wie funktioniert das Few-Shot Prompting?

Was ist das Few-Shot Prompting?

Few-Shot Prompting ist eine Technik, bei der Sie einem Maschinenlernmodell, insbesondere einem Sprachmodell, einen kleinen Satz von Beispielen geben, um sein Verhalten für eine bestimmte Aufgabe zu steuern. Im Gegensatz zu traditionellen Methoden des maschinellen Lernens, die umfangreiche Trainingsdaten erfordern, ermöglicht das Few-Shot Prompting dem Modell, die Aufgabe mit nur wenigen Beispielen zu verstehen. Dies ist besonders nützlich, wenn Sie über begrenzte Daten verfügen oder schnelle Ergebnisse benötigen.

Hauptkomponenten:

- Prompt-Vorlage: Dies ist die Struktur, die Ihre Beispiele enthält. Es handelt sich in der Regel um einen String, in den Variablen eingefügt werden können.

- Beispiele: Dies sind die tatsächlichen Datenpunkte, die das Modell führen. Jedes Beispiel ist ein Wörterbuch mit Schlüsseln als Eingabevariablen und Werten als entsprechenden Daten.

Beispiele für Few-Shot Prompting

Jetzt, da wir die Mechanik und Typen des Few-Shot Prompting abgedeckt haben, lassen Sie uns einige praktische Beispiele betrachten. Diese werden Ihnen ein klareres Bild davon geben, wie diese Technik in verschiedenen Szenarien angewendet werden kann.

Muhammad Ali vs Alan Turing: Wer hat länger gelebt?

In diesem Beispiel verwenden wir Few-Shot Prompting mit Zwischenschritten, um herauszufinden, wer länger gelebt hat: Muhammad Ali oder Alan Turing.

Folgende Schritte sind zu befolgen:

-

Definieren Sie die Aufgabe: Das Endziel ist herauszufinden, wer länger zwischen Muhammad Ali und Alan Turing gelebt hat.

-

Identifizieren Sie Zwischenschritte: Die Zwischenschritte beinhalten das Finden des Alters von Muhammad Ali und Alan Turing zum Zeitpunkt ihres Todes.

intermediate_steps = [

"Finden Sie das Alter von Muhammad Ali, als er gestorben ist.",

"Finden Sie das Alter von Alan Turing, als er gestorben ist."

]- Führen Sie das Modell aus: Geben Sie diese Zwischenschritte als Few-Shot Beispiele an das Modell weiter.

examples = [

{

"question": "Wie alt war Muhammad Ali, als er gestorben ist?",

"answer": "74"

},

{

"question": "Wie alt war Alan Turing, als er gestorben ist?",

"answer": "41"

}

]- Analysieren Sie die Ergebnisse: Basierend auf den Antworten können wir schlussfolgern, dass Muhammad Ali länger als Alan Turing gelebt hat.

Maternaler Großvater von George Washington

Angenommen, Sie interessieren sich für den mütterlichen Großvater von George Washington. Dies ist eine perfekte Aufgabe für Few-Shot Prompting mit Zwischenschritten.

Folgende Schritte sind zu befolgen:

-

Definieren Sie die Aufgabe: Das Endziel besteht darin, den mütterlichen Großvater von George Washington zu identifizieren.

-

Identifizieren Sie Zwischenschritte: Zuerst finden Sie heraus, wer die Mutter von George Washington war, und dann identifizieren Sie ihren Vater.

intermediate_steps = [

"Identifizieren Sie die Mutter von George Washington.",

"Finden Sie heraus, wer ihr Vater war."

]- Führen Sie das Modell aus: Geben Sie diese Schritte als Few-Shot Beispiele an.

examples = [

{

"question": "Wer war die Mutter von George Washington?",

"answer": "Mary Ball Washington"

},

{

"question": "Wer war der Vater von Mary Ball Washington?",

"answer": "Joseph Ball"

}

]- Analysieren Sie die Ergebnisse: Basierend auf den Antworten des Modells können wir schlussfolgern, dass der mütterliche Großvater von George Washington Joseph Ball war.

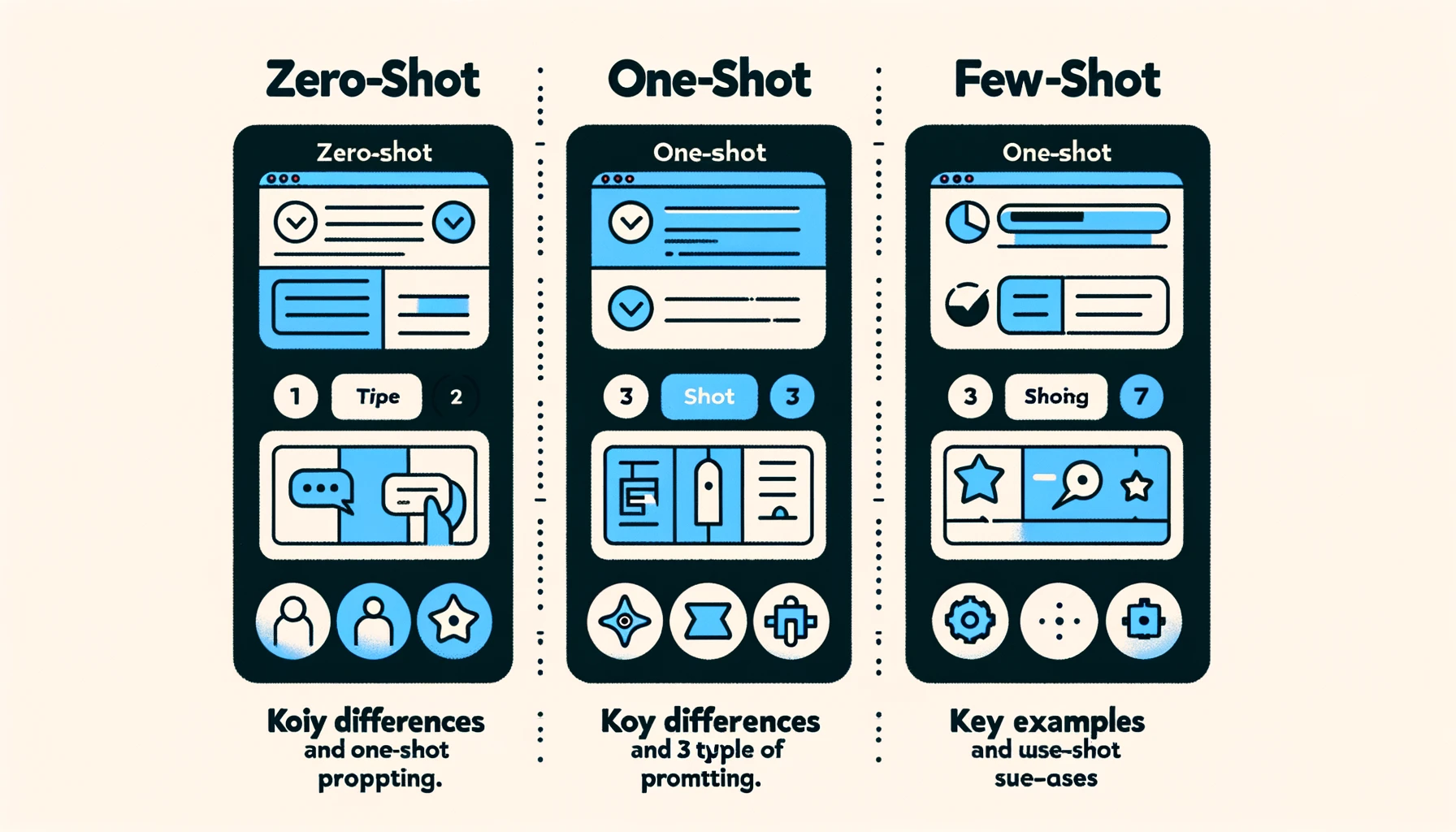

Zero-Shot vs Few-Shot Prompting

Zero-Shot Prompting ist, wenn Sie das Modell bitten, eine Aufgabe ohne Bereitstellung von Beispielen auszuführen. Das Modell stützt sich allein auf die in der Anforderung gegebenen Anweisungen. Wenn Sie zum Beispiel das Modell bitten, einen Text in positive, neutrale oder negative Stimmung einzuteilen, wird es dies allein aufgrund der Frage tun.

Bei Few-Shot Prompting dagegen werden eine Reihe von Beispielen bereitgestellt, um das Verhalten des Modells zu führen. Diese Beispiele fungieren als Roadmap und helfen dem Modell, die Aufgabe besser zu verstehen.

**Wann soll man Zero-Shot und wann soll man Few-Shot verwenden? **

-

Zero-Shot Prompting: Ideal für einfache Aufgaben, die kein kontextuelles Verständnis erfordern. Zum Beispiel können einfache Anfragen wie "Was ist die Hauptstadt von Frankreich?" effektiv mit Zero-Shot Prompting beantwortet werden.

-

Few-Shot Prompting: Am besten geeignet für komplexe Aufgaben, die ein tieferes Verständnis erfordern oder mehrere Schritte beinhalten. Wenn Sie zum Beispiel herausfinden möchten, wer von zwei historischen Persönlichkeiten länger gelebt hat, ist Few-Shot Prompting mit Zwischenschritten der richtige Weg.

Einrichten von Few-Shot Prompts

- Erstellen Sie eine Liste von Beispielen: Der erste Schritt besteht darin, eine Liste von Beispielen zu erstellen, die das Modell zur Orientierung verwendet. Jedes Beispiel sollte ein Wörterbuch sein. Zum Beispiel:

examples = [

{

"question": "Was ist die Hauptstadt von Frankreich?",

---

title: Few-Shot Prompting in Natural Language Processing

lang: de

---

# Few-Shot Prompting in Natural Language Processing

Few-shot prompting is a technique in natural language processing that allows machine learning models to perform tasks with minimal training data. By providing a small number of examples, the models can generalize and make accurate predictions on new, unseen inputs.

In this article, we will explore the concept of few-shot prompting, different types of few-shot prompting techniques, and how to implement them.

## What is Few-Shot Prompting?

Traditional machine learning models require a large amount of labeled data to learn and generalize well. However, in real-world scenarios, collecting and labeling such data can be time-consuming and expensive.

Few-shot prompting addresses this challenge by enabling models to learn from a minimal amount of examples. It allows models to leverage prior knowledge and apply it to new tasks without extensive training.

The idea behind few-shot prompting is to provide the model with a few examples of the desired task and then use this information to prompt the model to perform the task. This approach is particularly useful when dealing with complex tasks that require reasoning, understanding, and pattern recognition.

## Types of Few-Shot Prompting

There are several types of few-shot prompting techniques that can be used depending on the specific task at hand. Let's explore some of the most common ones:

### Few-Shot Prompting: Input Encoding

One common approach to few-shot prompting is to encode the few-shot examples directly in the input. This allows the model to learn from the examples and use this information to make predictions.

Here's an example of how this can be done using an input format similar to JSON:

```json

examples = [

{

"question": "What is the capital of France?",

"answer": "Paris"

},

{

"question": "What is 2 + 2?",

"answer": "4"

}

]- Format the Examples: The next step is to format these examples into a string that the model can understand. This is where the PromptTemplate object comes in. Here's how you can do it:

from some_library import PromptTemplate

example_prompt = PromptTemplate(input_variables=["question", "answer"], template="Question: {question}\nAnswer: {answer}")- Feed Examples to the Model: Finally, you feed these formatted examples to the model along with the task you want it to perform. This is usually done by appending the examples to the actual prompt.

prompt = "Question: What is the capital of Germany?"

formatted_examples = example_prompt.format(examples)

final_prompt = formatted_examples + promptBy following these steps, you've essentially set up a few-shot prompt. The model will now use the examples to better understand and answer the question in the final prompt.

Few-Shot Prompting: Self-Ask with Search

One of the most intriguing types of few-shot prompting is the "Self-Ask with Search" method. In this approach, the model is configured to ask itself questions based on the few-shot examples provided. This is particularly useful when you're dealing with complex queries that require the model to sift through a lot of information.

How it Works:

- Configure the Model: First, you need to set up your model to be able to ask itself questions. This usually involves some initial setup where you define the types of questions the model can ask.

self_ask_config = {

"types_of_questions": ["definition", "example", "explanation"]

}- Provide Few-Shot Examples: Next, you provide the model with a set of few-shot examples that guide its questioning process.

examples = [

{

"self_ask_type": "definition",

"question": "What is photosynthesis?",

"answer": "The process by which green plants convert sunlight into food."

},

{

"self_ask_type": "example",

"question": "Give an example of a renewable resource.",

"answer": "Solar energy"

}

]- Run the Model: Finally, you run the model with these configurations and examples. The model will now ask itself questions based on the examples and types defined, helping it to better understand the task at hand.

Few-Shot Prompting with Intermediate Steps

Another powerful type of few-shot prompting involves using intermediate steps to arrive at a final answer. This is especially useful for tasks that require logical reasoning or multiple steps to solve.

How it Works:

-

Define the Task: Clearly define what the end goal or final answer should be. For example, if you're trying to find out who lived longer between two individuals, your end goal is to identify that person.

-

Identify Intermediate Steps: List down the steps or questions that need to be answered to reach the final conclusion. For instance, you might need to first find out the ages of the two individuals at the time of their death.

intermediate_steps = [

"Find the age of Muhammad Ali when he died.",

"Find the age of Alan Turing when he died."

]- Run the Model: Feed these intermediate steps as few-shot examples to the model. The model will then use these steps to logically arrive at the final answer.

By understanding and implementing these types of few-shot prompting, you can tackle a wide range of complex tasks with your language model. Whether it's answering intricate questions or solving multi-step problems, few-shot prompting offers a robust and flexible solution.

Frequently Asked Questions (FAQ)

What is zero-shot prompting vs few-shot prompting?

Zero-shot prompting involves asking the model to perform tasks without any prior examples. Few-shot prompting, on the other hand, provides the model with a set of examples to guide its behavior.

What is an example of few shots learning?

An example of few-shot learning would be teaching a model to identify different breeds of dogs by providing it with just a couple of examples for each breed.

What is one-shot or few-shot learning in prompt engineering?

One-shot learning involves providing a single example to guide the model's behavior, while few-shot learning involves multiple examples. Both techniques fall under the umbrella of prompt engineering, which is the practice of crafting effective prompts for machine learning models.

What are three types of prompting?

The three main types of prompting are zero-shot prompting, one-shot prompting, and few-shot prompting. Each has its own set of advantages and disadvantages, and the choice between them depends on the specific task at hand.

Conclusion

Few-shot prompting is a powerful and versatile technique in prompt engineering. Whether you're dealing with simple queries or complex multi-step tasks, few-shot prompting offers a robust solution. By understanding its mechanics, types, and practical applications, you can unlock a whole new level of capability with your language models.

Stay tuned for more insightful articles on prompt engineering and machine learning. Happy prompting!