Guanaco 65B: Chatbots de código abierto optimizados que desafían a GPT-4

Published on

En el cambiante panorama de la inteligencia artificial, los modelos de generación de texto se han convertido en la piedra angular de diversas aplicaciones, desde chatbots hasta creación de contenido. Guanaco 65B destaca como un modelo revolucionario que ha generado gran atención por sus capacidades. Pero, ¿qué lo hace tan especial? En esta guía completa, exploraremos los pormenores de Guanaco 65B, incluyendo sus diferentes versiones, características de compatibilidad e incluso cómo obtenerlo.

Si eres desarrollador, científico de datos o simplemente un entusiasta de la IA, comprender Guanaco 65B podría ser tu próximo gran avance en el campo. Ya sea que desees generar texto, analizar datos o desarrollar una nueva aplicación, esta guía será tu recurso definitivo. ¡Así que comencemos!

¿Quieres conocer las últimas noticias de LLM? ¡Echa un vistazo a las últimas clasificaciones LLM!

¿Qué es Guanaco 65B y por qué deberías preocuparte?

Guanaco 65B es un avanzado modelo de lenguaje diseñado para la generación de texto. No es sólo otro modelo, sino una herramienta flexible y poderosa que está disponible en varias versiones para adaptarse a diferentes requerimientos de hardware. Ya sea que estés trabajando con una CPU o una GPU de alta gama, hay un Guanaco 65B para ti. Ahora, veamos en detalle estas versiones.

Evaluando Guanaco 65B: ¿Cómo se compara?

Cuando se trata de evaluar el rendimiento de modelos de lenguaje como Guanaco 65B, los benchmarks son cruciales. Proporcionan una manera estandarizada de medir diversos aspectos como velocidad, precisión y capacidades en general. Sin embargo, los benchmarks no son la única forma de evaluar la efectividad de un modelo. Las experiencias de usuario y las discusiones en la comunidad también ofrecen información valiosa.

Desafortunadamente, hasta ahora, Guanaco 65B no está listado en ningún ranking oficial. Sin embargo, vale la pena señalar que:

- Ajuste fino: Guanaco 65B es uno de los pocos modelos preajustados disponibles para la arquitectura 65B, lo que lo convierte en una oferta única.

- Tareas especializadas: La compatibilidad del modelo con QLoRA sugiere que podría destacarse en tareas basadas en consultas, aunque esto debe verificarse empíricamente.

Ventajas de Guanaco 65B

Después de usar el modelo, estas son las ventajas de Guanaco-65B:

- Velocidad y eficiencia: Algunos usuarios encontraron que la versión 65B era más lenta, lo que afectaba su usabilidad en ciertas tareas.

- Juego de roles y coherencia de personajes: Los usuarios notaron que los modelos Guanaco destacan en mantener la coherencia de personajes, especialmente cuando se usan tarjetas de personaje.

- Generación de texto: Los modelos Guanaco son elogiados por su capacidad para generar una gran cantidad de texto mientras comprenden eficazmente las indicaciones.

Licencias de Guanaco 65B

Antes de adentrarnos en el mundo de Guanaco 65B, es crucial comprender los términos de licencia que acompañan a cada versión. Diferentes licencias regulan cómo puedes utilizar, modificar y distribuir el modelo.

- Licencias de código abierto: Algunas versiones vienen con licencias de código abierto, lo que permite su uso y modificación de forma gratuita.

- Licencias comerciales: Otras versiones pueden requerir una licencia comercial, especialmente si planeas utilizar el modelo en un entorno con fines de lucro.

Puedes consultar la página de Guanaco 65B en Huggingface aquí (opens in a new tab).

Una guía paso a paso para usar Guanaco 65B

Navegar por el mundo de los modelos de generación de texto puede ser desalentador, especialmente si eres nuevo en el campo. Por eso, hemos preparado una guía completa paso a paso para que puedas comenzar a utilizar Guanaco 65B rápidamente.

Paso 1. Descargar Guanaco 65B

Antes de poder comenzar a generar texto, deberás descargar el modelo de Guanaco 65B que mejor se adapte a tus necesidades. Así es cómo puedes hacerlo:

- Visitar el repositorio Hugging Face: Ve al sitio web de Hugging Face y busca la versión de Guanaco 65B que deseas.

- Seleccionar el modelo: Haz clic en el modelo para ir a su página dedicada.

- Copiar el nombre del modelo: Encontrarás el nombre del modelo cerca de la parte superior de la página. Cópialo para usarlo más adelante.

Paso 2. Generación de texto usando Guanaco 65B

Una vez que hayas descargado el modelo, es hora de escribir un poco de código. A continuación, se muestra un fragmento de código de ejemplo en Python que demuestra cómo generar texto usando Guanaco 65B.

from transformers import AutoTokenizer, AutoModelForCausalLM

# Inicializar el tokenizer y el modelo

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# Preparar la entrada de texto

input_text = "Cuéntame un chiste."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# Generar texto

output = model.generate(input_ids)

# Decodificar e imprimir el texto generado

print(tokenizer.decode(output[0], skip_special_tokens=True))Para ejecutar este código, asegúrate de tener instalada la biblioteca transformers. Si no lo tienes, puedes instalarlo usando pip:

pip install transformersY ahí lo tienes, una forma sencilla pero efectiva de generar texto usando Guanaco 65B. Ya sea que estés construyendo un chatbot, un generador de contenido o cualquier otra aplicación basada en texto, este modelo te cubre.

Paso 3. Usar Guanaco 65B con Google Colab

Para aquellos que prefieren un enfoque más práctico, Guanaco 65B se puede implementar fácilmente en cuadernos de Google Colab. Esto te permite experimentar con el modelo sin complicaciones de instalación.

- Facilidad de uso: Simplemente importa el modelo en un cuaderno de Colab y comienza a usarlo.

- Colaboración: Las funciones de compartir de Colab facilitan la colaboración en proyectos.

Aquí tienes un fragmento de código rápido para usar Guanaco 65B en Google Colab:

# Código de ejemplo para usar Guanaco 65B en Google Colab

# Asegúrate de instalar primero la biblioteca transformers

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "¿Qué es la IA?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

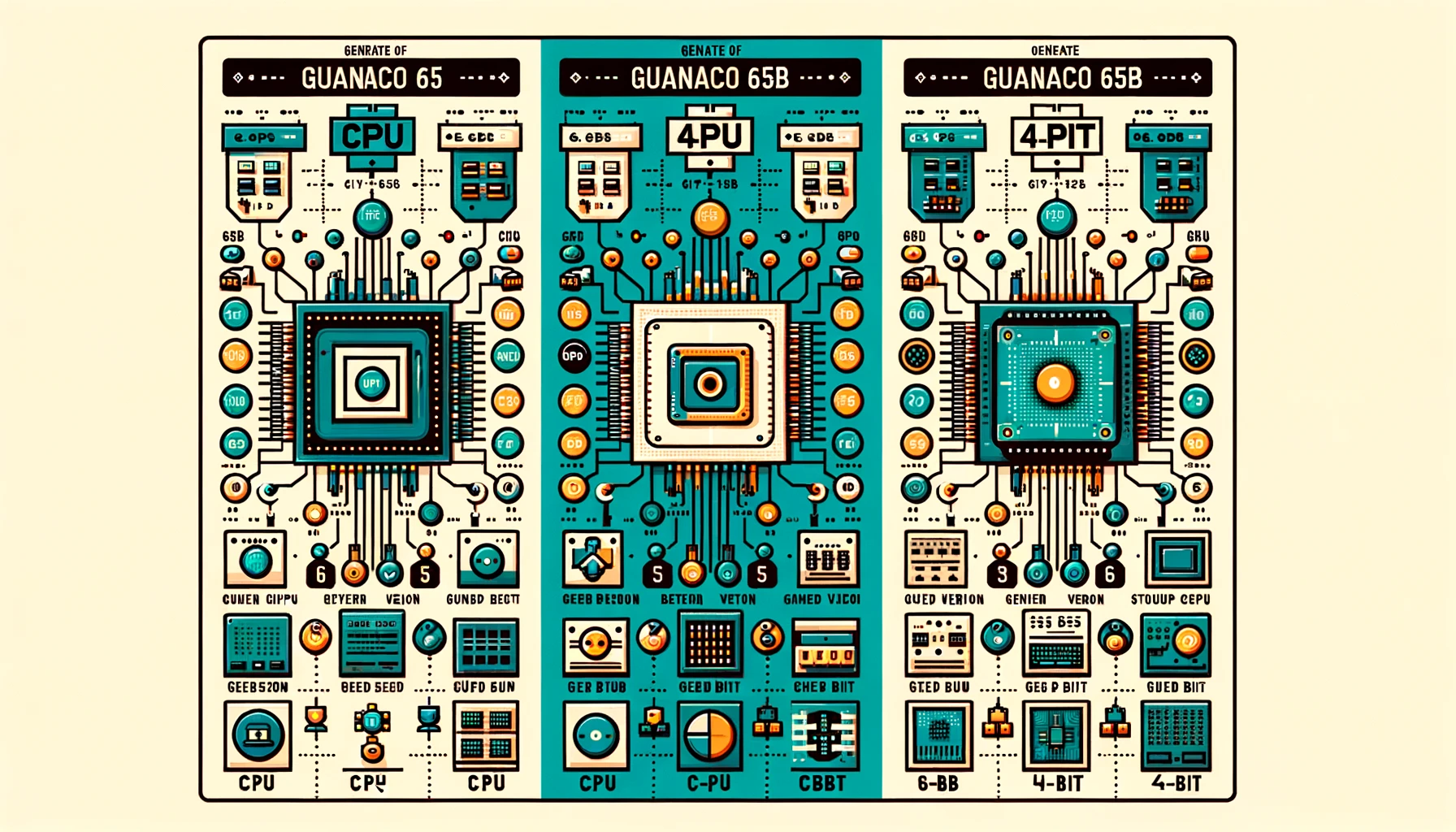

print(tokenizer.decode(output[0], skip_special_tokens=True))Diferentes versiones de Guanaco 65B

Uso de la versión Guanaco 65B de 4 bits

Cuando se trata de optimizar tanto el rendimiento como la memoria, la versión Guanaco 65B-GPTQ de 4 bits es un cambio de juego. Esta variante está diseñada para ejecutarse en GPUs, pero con un giro: utiliza cuantización para reducir el tamaño del modelo sin comprometer significativamente su rendimiento.

Características:

- Reducción del uso de memoria: La cuantización de 4 bits reduce drásticamente los requisitos de VRAM.

- Múltiples parámetros de cuantización: Permite personalización según tus necesidades específicas.

- Rendimiento cercano al original: A pesar del tamaño reducido, el modelo mantiene un alto nivel de precisión.

¿Quién debería usarlo?

- Investigadores enfocados en el aprendizaje automático eficiente.

- Desarrolladores con recursos limitados de GPU.

- Cualquier persona interesada en la computación en el borde.

Aquí tienes un fragmento de código de ejemplo para usar Guanaco 65B-GPTQ:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "¿Cómo está el clima?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Al elegir la versión adecuada de Guanaco 65B, puedes adaptar tus tareas de generación de texto a las capacidades de tu hardware. Ya sea la CPU, GPU o la versión de 4 bits, cada una ofrece ventajas únicas que se adaptan a una amplia gama de necesidades.

Usa Guanaco 65B con QLoRA

Una de las características destacadas de Guanaco 65B es su compatibilidad con QLoRA, un modelo de lenguaje basado en consultas. Esta característica te permite realizar tareas de generación de texto más específicas y dirigidas.

- Tareas basadas en consultas: Ideal para motores de búsqueda o sistemas de recomendación.

- Mayor precisión: La compatibilidad con QLoRA garantiza una generación de texto más precisa y relevante.

Aquí tienes un fragmento de código de ejemplo para usar Guanaco 65B con QLoRA:

# Código de ejemplo para usar Guanaco 65B con QLoRA

# Nota: Este es un ejemplo hipotético; la implementación real puede variar.

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "¿Cuál es la capital de Francia?"

response = qlora_model.generate(query)

print(response)Conclusion: Por qué Guanaco 65B es un cambio de juego

A medida que concluimos esta guía completa, está claro que Guanaco 65B no es solo otro modelo de generación de texto. Es una herramienta versátil, potente y altamente personalizable que se adapta a una amplia gama de aplicaciones y configuraciones de hardware. Desde sus diferentes versiones hasta su compatibilidad con modelos basados en consultas como QLoRA, Guanaco 65B es realmente un cambio de juego en el campo de la generación de texto.

Ya seas un desarrollador experimentado o un entusiasta curioso, este modelo ofrece algo para todos. ¿Entonces por qué esperar? ¡Sumérgete en el mundo de Guanaco 65B y descubre el futuro de la generación de texto hoy mismo!

¿Quieres conocer las últimas noticias de LLM? ¡Consulta la última clasificación de LLM!