QA-LoRA: Una guía para ajustar eficientemente los Modelos de Lenguaje a Gran Escala

Published on

¡Bienvenido al fascinante universo de los Modelos de Lenguaje a Gran Escala (LLMs)! Estos gigantes computacionales son la base de numerosas aplicaciones, desde chatbots y traductores hasta generadores de contenido y sistemas de recomendación. Sin embargo, por maravillosos que sean, desplegarlos no es tarea fácil. Los requisitos computacionales y de memoria pueden ser abrumadores, a menudo requiriendo hardware especializado y mucha paciencia.

Aquí es donde entra en juego QA-LoRA. Este método innovador está cambiando el juego, facilitando y optimizando el ajuste fino y despliegue de los LLMs. Así que, si estás luchando con la carga computacional de los LLMs o buscando una forma más inteligente de ajustarlos, has llegado al lugar correcto.

Por qué QA-LoRA es un cambio de juego para los LLMs

¿Quieres conocer las últimas noticias sobre LLM? ¡Echa un vistazo a la última tabla de clasificación de LLM!

¿Qué es exactamente QA-LoRA y en qué se diferencia de LoRA?

Antes de profundizar en los detalles, definamos nuestro tema. QA-LoRA significa Adaptación de Bajo Rango Consciente de la Cuantificación. En términos más simples, es un método diseñado para hacer el ajuste fino de los Modelos de Lenguaje a Gran Escala más eficiente. Ahora, es posible que te preguntes, "Entonces, ¿qué es LoRA?" LoRA es el acrónimo de Adaptación de Bajo Rango, una técnica que busca reducir la complejidad de un modelo sin sacrificar su rendimiento. Lo que distingue a QA-LoRA es su aspecto consciente de la cuantificación.

- Cuantificación: Este es el proceso de restringir los valores posibles que puede tomar una función. En el contexto de los LLMs, ayuda a reducir el tamaño del modelo.

- Adaptación de Bajo Rango: Esto implica aproximar los datos originales de alta dimensionalidad con una forma de menor dimensionalidad, lo que hace que el modelo sea menos costoso computacionalmente.

Por lo tanto, al combinar estos dos elementos: cuantificación y adaptación de bajo rango, obtienes QA-LoRA, un método que no solo reduce el tamaño del modelo, sino que también lo hace más eficiente computacionalmente. Esto es crucial para desplegar LLMs en dispositivos con recursos computacionales limitados.

El método LoRA simplificado

El método LoRA es esencialmente una forma de aproximar las matrices de pesos originales de un LLM utilizando matrices de bajo rango. Este es un truco inteligente para reducir los requisitos computacionales sin sacrificar mucho en términos de rendimiento. En el contexto de QA-LoRA, esta adaptación de bajo rango funciona en conjunto con la cuantificación para proporcionar un modelo aún más eficiente.

- Paso 1: Comienza identificando las matrices de pesos en tu LLM que sean adecuadas para la aproximación de bajo rango.

- Paso 2: Utiliza técnicas matemáticas como la Descomposición en Valores Singulares (SVD, por sus siglas en inglés) para encontrar estas aproximaciones de bajo rango.

- Paso 3: Reemplaza las matrices de pesos originales con estas aproximaciones de bajo rango.

- Paso 4: Aplica la cuantificación para reducir aún más el tamaño del modelo.

Siguiendo estos pasos, puedes reducir significativamente la carga computacional de tu LLM, facilitando y acelerando su despliegue.

Equilibrando la cuantificación y la adaptación en QA-LoRA

Uno de los aspectos más intrigantes de QA-LoRA es cómo equilibra los grados de libertad entre la cuantificación y la adaptación. Este equilibrio es crucial porque permite que QA-LoRA sea eficiente y preciso al mismo tiempo. Demasiada cuantificación puede llevar a una pérdida de precisión, mientras que demasiada adaptación puede hacer que el modelo sea computacionalmente costoso. QA-LoRA encuentra el punto óptimo entre estos dos.

- Eficiencia: Al utilizar la cuantificación, QA-LoRA reduce el tamaño del modelo, lo que permite cargarlo y ejecutarlo más rápidamente.

- Precisión: A través de la adaptación de bajo rango, mantiene el rendimiento del modelo, asegurando que no tengas que comprometer la calidad.

Como podemos ver, QA-LoRA ofrece un enfoque equilibrado que lo convierte en un método imprescindible para cualquier persona que desee ajustar y desplegar Modelos de Lenguaje a Gran Escala eficientemente. Combina lo mejor de ambos mundos - eficiencia y precisión - lo que lo convierte en un cambio de juego en el campo del aprendizaje automático.

Cómo empezar con QA-LoRA

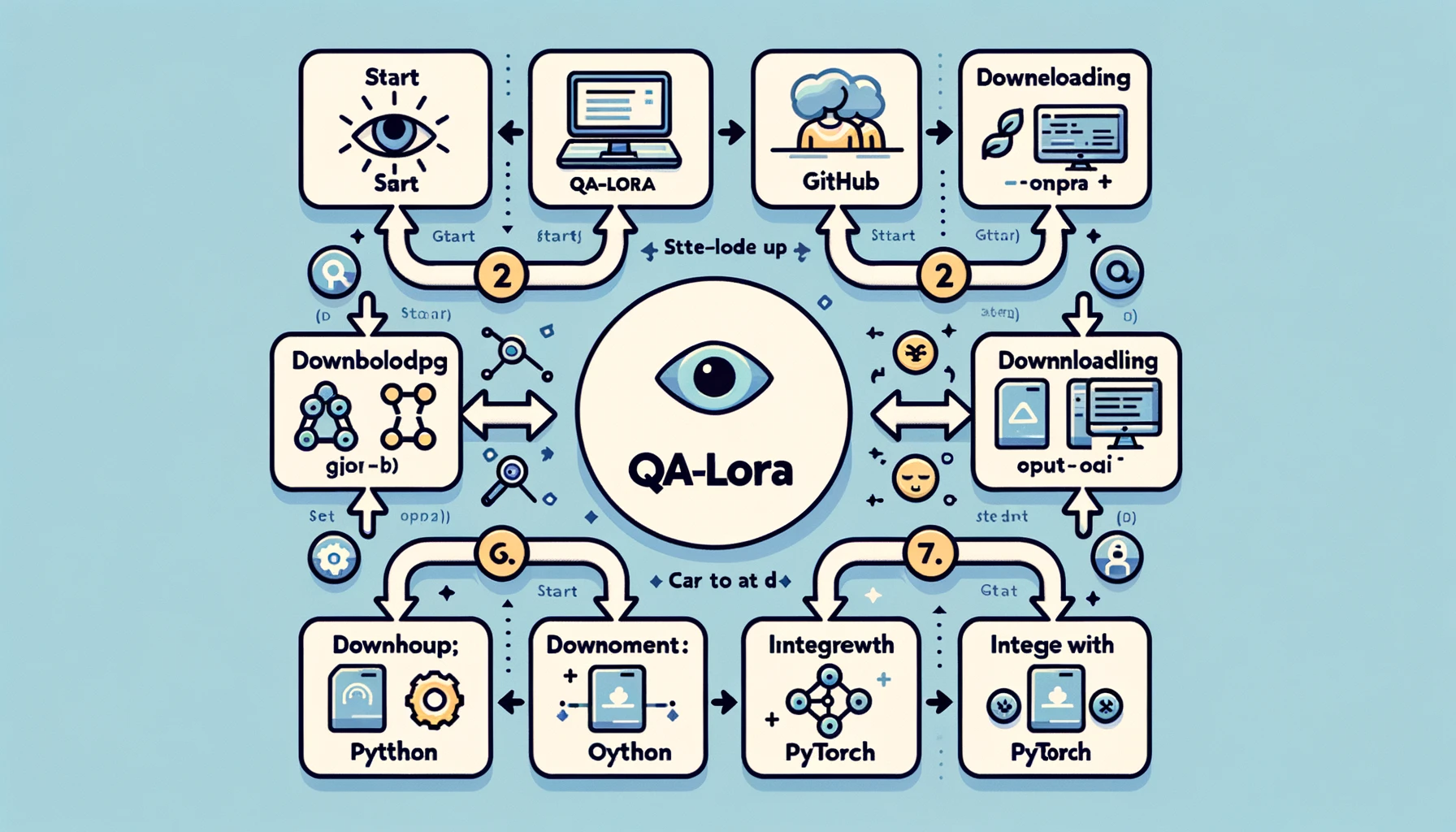

Preparar tu entorno para QA-LoRA

Antes de sumergirte en el mundo de QA-LoRA, deberás configurar tu entorno de desarrollo. Este es un paso crucial porque la configuración adecuada puede hacer que tu experiencia sea más fluida y eficiente. Esto es lo que debes hacer:

- Paso 1: Instalar Python: Si aún no lo has hecho, instala Python en tu sistema. Se recomienda Python 3.x.

- Paso 2: Configurar un entorno virtual: Siempre es una buena idea trabajar en un entorno virtual para evitar conflictos de dependencia. Puedes utilizar herramientas como

venvocondapara esto. - Paso 3: Instalar las bibliotecas necesarias: Necesitarás bibliotecas como PyTorch, NumPy y otras. Utiliza pip o conda para instalarlas.

- Paso 4: Clonar el repositorio de GitHub: Hay un repositorio de GitHub dedicado a QA-LoRA. Clónalo en tu máquina local para obtener el código de ejemplo y otros recursos.

Siguiendo estos pasos, tendrás un entorno de desarrollo sólido listo para implementar QA-LoRA. Esta configuración garantiza que tengas todas las herramientas y bibliotecas necesarias para que tu implementación sea lo más fluida posible.

Implementando QA-LoRA: Un recorrido paso a paso

Ahora que tu entorno está configurado, veamos la implementación real. Aquí es donde verás a QA-LoRA en acción. Aquí tienes una guía paso a paso para implementar QA-LoRA:

-

Paso 1: Importar Bibliotecas: Comienza importando todas las bibliotecas necesarias. Esto usualmente incluye PyTorch para el modelo y NumPy para operaciones numéricas.

import torch import numpy as np -

Paso 2: Cargar tu Modelo: Carga el Modelo de Lenguaje Grande que deseas afinar. Este puede ser un modelo pre-entrenado o un modelo que hayas entrenado tú mismo.

model = torch.load('tu_modelo.pth') -

Paso 3: Identificar Matrices de Pesos: Identifica las matrices de pesos en tu modelo que sean adecuadas para una aproximación de baja calidad. Estas suelen ser las capas totalmente conectadas.

-

Paso 4: Aplicar Aproximación de Baja Calidad: Utiliza técnicas como la descomposición de valores singulares (SVD) para aproximar estas matrices de pesos.

u, s, v = torch.svd(matriz_de_pesos) -

Paso 5: Reemplazar las Matrices Originales: Reemplaza las matrices de pesos originales con las aproximaciones de baja calidad.

matriz_aproximada = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

Paso 6: Aplicar Cuantización: Finalmente, aplica cuantización para reducir aún más el tamaño del modelo. Esto se puede hacer utilizando las utilidades de cuantización de PyTorch.

modelo_cuantizado = torch.quantization.quantize_dynamic(modelo)

Siguiendo este detallado proceso, tendrás una implementación funcional de QA-LoRA. Esto no solo hará que tu modelo sea más eficiente, sino que también mantendrá su rendimiento, brindándote lo mejor de ambos mundos.

Los siguientes pasos en la investigación de QA-LoRA

Si bien QA-LoRA ya es un método innovador, es importante destacar que la investigación en esta área está lejos de terminar. Este campo está lleno de oportunidades para la innovación, y existen varias áreas para mejorar aún más. Por ejemplo, la investigación actual se centra en hacer que QA-LoRA sea aún más eficiente sin comprometer la precisión. Esto implica afinar el equilibrio entre la cuantización y la adaptación de baja calidad, entre otras cosas.

- Optimización de la Cuantización: Una área de enfoque es optimizar el proceso de cuantización para garantizar una pérdida mínima de información.

- Aproximación de Baja Calidad Adaptativa: Otra área de desarrollo es hacer que el proceso de aproximación de baja calidad sea adaptativo, permitiendo que el modelo se ajuste según la tarea en cuestión.

Estos esfuerzos de investigación en curso tienen como objetivo hacer que QA-LoRA sea aún más robusta y versátil, asegurando que se mantenga como el método preferido para afinar Modelos de Lenguaje Grande de manera eficiente.

Puedes leer más sobre el Paper de QA-LoRA aquí (opens in a new tab).

Conclusión: Por qué QA-LoRA es importante

Reflexiones finales sobre QA-LoRA y su impacto

Al llegar al final de esta guía exhaustiva, es importante dar un paso atrás y apreciar el poder transformador de QA-LoRA. Este método no es solo otro jerga técnica arrojada al mar en constante expansión de algoritmos de aprendizaje automático. Es un avance fundamental que aborda desafíos del mundo real en la implementación de Modelos de Lenguaje Grande.

-

Eficiencia: Una de las ventajas más convincentes de QA-LoRA es su eficiencia. Al combinar cuantización y adaptación de baja calidad, reduce significativamente los requisitos computacionales y de memoria de los Modelos de Lenguaje Grande. Esto es beneficioso para desarrolladores y organizaciones que buscan implementar estos modelos a gran escala o en dispositivos con recursos limitados.

-

Precisión: QA-LoRA no compromete el rendimiento. A pesar de su eficiencia, el método mantiene la precisión del modelo, asegurando resultados de alta calidad. Este equilibrio entre eficiencia y precisión es lo que distingue a QA-LoRA de otros métodos de afinamiento.

-

Versatilidad: El método es versátil y se puede aplicar a varios tipos de Modelos de Lenguaje Grande. Ya sea que estés trabajando en procesamiento de lenguaje natural, visión por computadora o cualquier otro dominio, QA-LoRA se puede adaptar para adaptarse a tus necesidades.

-

Facilidad de Implementación: Con código fácilmente disponible y una comunidad de apoyo, implementar QA-LoRA es más fácil que nunca. Incluso si no eres un experto en aprendizaje automático, el método es accesible y fácil de aplicar.

En resumen, QA-LoRA es más que un método de afinamiento; es un cambio de paradigma en cómo abordamos la implementación de Modelos de Lenguaje Grande. Ofrece una forma equilibrada, eficiente y efectiva de acercar estos gigantes computacionales a aplicaciones prácticas del mundo real. Si te encuentras en el campo del aprendizaje automático o te intriga el potencial de los Modelos de Lenguaje Grande, QA-LoRA es un tema que no puedes ignorar.

Conclusión

El mundo de los Modelos de Lenguaje Grande es emocionante pero está lleno de desafíos, especialmente cuando se trata de la implementación. QA-LoRA emerge como un rayo de esperanza, ofreciendo un método equilibrado y eficiente para afinar estos modelos. Desde sus complejidades técnicas hasta su implementación práctica, QA-LoRA se presenta como un testimonio de lo que se puede lograr cuando la eficiencia y la precisión van de la mano.

Entonces, a medida que te adentres en tu próximo proyecto que involucre Modelos de Lenguaje Grande, recuerda que QA-LoRA es tu compañero confiable para un afinamiento eficiente y efectivo. Pruébalo y únete a la revolución que está estableciendo nuevos estándares en el mundo del aprendizaje automático.

¿Quieres conocer las últimas noticias sobre Modelos de Lenguaje Grande? ¡Consulta la última tabla de clasificación de LLM!