Comparaison des puissants cadres d'application LLM : LlamaIndex vs LangChain

Published on

Introduction

Dans le domaine du traitement du langage naturel (NLP) et des grands modèles de langage (LLMs), les développeurs recherchent constamment des outils puissants pour créer des applications de pointe. Deux frameworks importants se sont imposés comme des leaders dans ce domaine : LlamaIndex et LangChain. Bien que les deux visent à simplifier l'intégration des LLM dans des applications personnalisées, ils diffèrent par leur approche et leur orientation. Dans cet article, nous nous plongerons dans les principales différences entre LlamaIndex et LangChain, afin de vous aider à prendre une décision éclairée lors du choix d'un framework pour vos projets.

Partie 1. Qu'est-ce que LlamaIndex ?

LlamaIndex est un puissant framework de données qui vous permet de connecter facilement vos propres données aux LLMs. Il propose des connecteurs de données flexibles pour ingérer des données à partir de différentes sources telles que des API, des bases de données, des fichiers PDF, etc. Ces données privées sont ensuite indexées dans des représentations optimisées que les LLMs peuvent accéder et interpréter à grande échelle, sans avoir besoin de retrainer le modèle sous-jacent.

LlamaIndex dote les LLMs d'une "mémoire" de vos données privées qu'ils peuvent exploiter pour fournir des réponses informées et contextuelles. Que vous souhaitiez créer un chatbot basé sur la documentation de votre entreprise, un outil d'analyse de CV personnalisé ou un assistant IA capable de répondre à des questions spécifiques dans un domaine de connaissances particulier, LlamaIndex rend cela possible en seulement quelques lignes de code.

Fonctionnement de LlamaIndex

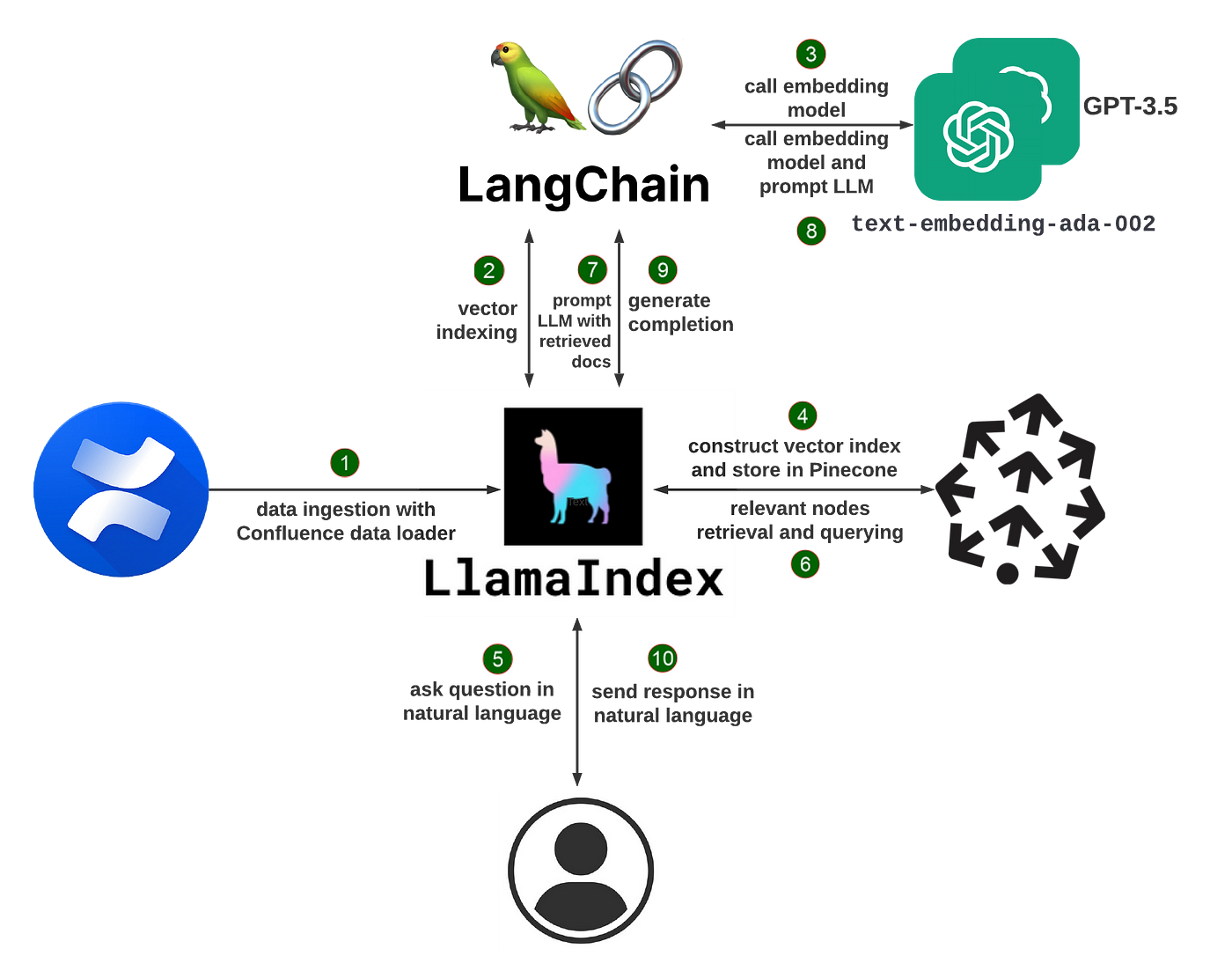

Le cœur de LlamaIndex repose sur une technique appelée retrieval augmented generation (RAG). Un système RAG typique comporte deux étapes clés :

-

Étape d'indexation : Pendant l'indexation, vos données privées sont converties de manière efficace en un index vectoriel consultable. LlamaIndex peut traiter des documents textuels non structurés, des enregistrements de bases de données structurées, des graphes de connaissances, et plus encore. Les données sont transformées en embeddings numériques qui capturent leur signification sémantique, permettant des recherches de similarité rapides ultérieurement.

-

Étape de requête : Lorsqu'un utilisateur interroge le système, les informations les plus pertinentes sont extraites de l'index vectoriel en fonction de la similarité sémantique de la requête. Ces extraits, ainsi que la requête originale, sont transmis au LLM qui génère une réponse finale. En intégrant dynamiquement un contexte pertinent, le LLM peut produire des réponses de meilleure qualité et plus factuelles qu'en se basant uniquement sur ses connaissances de base.

LlamaIndex masque une grande partie de la complexité de la construction d'un système RAG. Il propose à la fois des API de haut niveau qui vous permettent de commencer avec seulement quelques lignes de code, ainsi que des blocs de construction de bas niveau pour une personnalisation fine du pipeline de données.

Construction d'un chatbot de CV avec LlamaIndex

Pour illustrer les capacités de LlamaIndex, voyons comment construire un chatbot capable de répondre à des questions sur votre CV.

Tout d'abord, installez les packages nécessaires :

pip install llama-index openai pypdfEnsuite, chargez votre CV au format PDF et construisez un index :

from llama_index import TreeIndex, SimpleDirectoryReader

resume = SimpleDirectoryReader("chemin/vers/le/cv").load_data()

index = TreeIndex.from_documents(resume)Vous pouvez maintenant interroger l'index en utilisant un langage naturel :

query_engine = index.as_query_engine()

response = query_engine.query("Quel est le titre du poste ?")

print(response)Le moteur de requête effectuera une recherche dans l'index du CV et renverra un extrait pertinent en réponse, par exemple : "Le titre du poste est Ingénieur logiciel".

Vous pouvez également engager une conversation interactive :

chat_engine = index.as_chat_engine()

response = chat_engine.chat("Que faisait cette personne dans son dernier poste ?")

print(response)

follow_up = chat_engine.chat("Quels langages de programmation a-t-elle utilisés ?")

print(follow_up)Le moteur de conversation maintient le contexte, ce qui vous permet de poser des questions de suivi sans avoir à rester explicitement le sujet.

Pour éviter de reconstruire l'index à chaque fois, vous pouvez le sauvegarder sur le disque :

index.storage_context.persist()Et le recharger ultérieurement :

from llama_index import StorageContext, load_index_from_storage

storage_context = StorageContext.from_defaults(persist_dir="./storage")

index = load_index_from_storage(storage_context)Au-delà des chatbots : cas d'utilisation de LlamaIndex

Les chatbots ne sont que l'une des nombreuses applications que vous pouvez développer avec LlamaIndex. Voici quelques autres exemples :

- Questions et réponses sur de longs documents : Ingestion de documents tels que des manuels, des contrats juridiques ou des articles de recherche, et poser des questions sur leur contenu

- Recommandations personnalisées : Construire des indices sur des catalogues de produits ou des bibliothèques de contenu, et fournir des recommandations basées sur les requêtes de l'utilisateur

- Agents basés sur les données : Créer des assistants IA capables d'accéder à des bases de données, des API et d'autres outils pour réaliser des tâches complexes

- Construction de bases de connaissances : Extraire automatiquement des données structurées telles que des entités et des relations à partir de texte non structuré pour construire des graphes de connaissances

LlamaIndex offre une boîte à outils flexible pour créer toutes sortes d'applications alimentées par des LLMs. Vous pouvez mélanger et associer des chargeurs de données, des index, des moteurs de requête, des agents, etc., pour créer des pipelines personnalisés adaptés à votre cas d'utilisation.

Commencer avec LlamaIndex

Pour commencer à utiliser LlamaIndex, installez d'abord le package :

pip install llama-indexVous aurez également besoin d'une clé API OpenAI pour accéder aux modèles sous-jacents par défaut. Définissez cette clé en tant que variable d'environnement :

import osos.environ["OPENAI_API_KEY"] = "votre_clé_d'API_ici"

À partir de là, vous pouvez commencer à ingérer des données et à construire des index ! Les documents de LlamaIndex fournissent des guides détaillés et des exemples pour les cas d'utilisation courants.

À mesure que vous plongez plus profondément, vous pouvez explorer le Llama Hub - une collection de chargeurs de données, d'indices, de moteurs de requête et plus encore contribués par la communauté. Vous pouvez utiliser ces plugins tels quels ou comme point de départ pour vos propres composants personnalisés.

### Qu'est-ce que LangChain ?

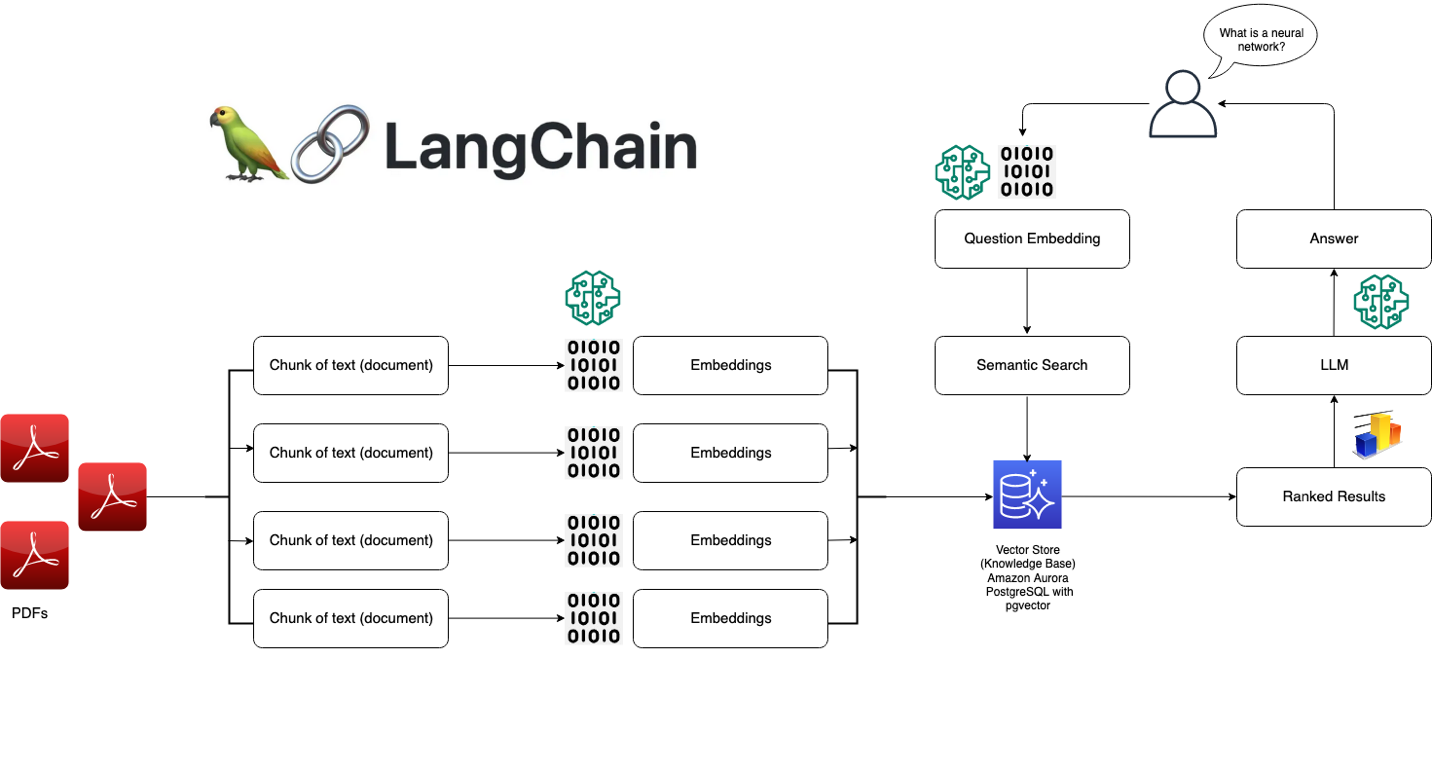

LangChain est un framework puissant pour développer des applications alimentées par des modèles de langage. Il vous permet de connecter facilement vos propres données aux LLM (langage model models) et de construire des applications de modèles de langage sensibles aux données. LangChain fournit une interface standard pour les chaînes, de nombreuses intégrations avec d'autres outils et des chaînes de bout en bout pour les applications courantes.

Avec LangChain, vous pouvez charger des données à partir de sources variées telles que des documents, des bases de données, des API et des bases de connaissances. Ces données privées sont ensuite rendues accessibles aux LLM pendant l'inférence, ce qui leur permet de tirer parti de ce contexte pour fournir des réponses informées et pertinentes. Que vous souhaitiez créer un chatbot sur la documentation de votre entreprise, un outil d'analyse de données ou un assistant IA qui interagit avec vos bases de données et vos API, LangChain rend cela possible.

### Comment fonctionne LangChain

Au cœur de LangChain se trouvent quelques concepts clés :

1. Prompts : Les prompts sont les instructions que vous donnez au modèle de langage pour orienter sa sortie. LangChain fournit une interface standard pour construire et travailler avec des prompts.

2. Modèles : LangChain fournit une interface standard pour travailler avec différents LLM et une manière facile de les échanger. Il prend en charge des modèles comme le GPT-3 d'OpenAI, Claude d'Anthropic, les modèles de Cohere, et bien d'autres.

3. Indexes : Les indexes désignent la manière dont les données textuelles sont stockées et rendues accessibles au modèle de langage. LangChain propose plusieurs techniques d'indexation optimisées pour les LLM, telles que les vecteurs-stock et les suites d'insertions en mémoire.

4. Chains : Les chaînes sont des séquences d'appels aux LLM et à d'autres outils, l'outpute d'une étape étant l'input de la suivante. LangChain fournit une interface standard pour les chaînes et de nombreux composants réutilisables.

5. Agents : Les agents utilisent un LLM pour déterminer les actions à prendre et dans quel ordre. LangChain propose une sélection d'agents qui peuvent exploiter des outils pour accomplir des tâches.

Avec ces éléments de base, vous pouvez créer toutes sortes d'applications puissantes de modèles de langage. LangChain abstrait une grande partie de la complexité, ce qui vous permet de vous concentrer sur la logique de haut niveau de votre application.

### Construction d'un système de question-réponse avec LangChain

Pour illustrer les capacités de LangChain, parcourons la création d'un système de question-réponse simple sur un ensemble de documents.

Tout d'abord, installez les packages nécessaires :

pip install langchain openai faiss-cpu

Ensuite, chargez vos données et créez un index :

```python

from langchain.document_loaders import TextLoader

from langchain.indexes import VectorstoreIndexCreator

loader = TextLoader('chemin/vers/document.txt')

index = VectorstoreIndexCreator().from_loaders([loader])Maintenant, vous pouvez interroger l'index en utilisant le langage naturel :

query = "Quel est le sujet principal de ce document ?"

result = index.query(query)

print(result)La requête recherchera dans le document et renverra le passage le plus pertinent en réponse.

Vous pouvez également avoir une conversation avec les données en utilisant une ConversationalRetrievalChain :

from langchain.chains import ConversationalRetrievalChain

from langchain.chat_models import ChatOpenAI

model = ChatOpenAI(temperature=0)

qa = ConversationalRetrievalChain.from_llm(model,retriever=index.vectorstore.as_retriever())

historique_chat = []

while True:

query = input("Humain : ")

result = qa({"question": query, "historique_chat": historique_chat})

historique_chat.append((query, result['answer']))

print(f"Assistant : {result['answer']}")Cela permet une conversation interactive où le modèle a accès au contexte pertinent des

documents.

Au-delà des questions-réponses : cas d'utilisation de LangChain

La réponse aux questions n'est qu'une des nombreuses applications que vous pouvez créer avec LangChain. Voici quelques autres exemples :

- Chatbots : Créez des agents conversationnels capables de dialoguer librement en exploitant des données privées

- Analyse de données : Connectez les LLM aux bases de données SQL, aux dataframes pandas et aux bibliothèques de visualisation de données pour une exploration interactive des données

- Agents : Développez des agents IA capables d'utiliser des outils comme les navigateurs web, les APIs et les calculatrices pour accomplir des tâches ouvertes.

- Génération d'applications : Générez automatiquement des applications entières à partir de spécifications en langage naturel.

LangChain offre un ensemble flexible de composants qui peuvent être combinés de nombreuses manières pour créer des applications puissantes de modèles de langage. Vous pouvez utiliser les chaînes et agents prédéfinis ou créer vos propres pipelines personnalisés.

Commencer avec LangChain

Pour commencer à travailler avec LangChain, installez d'abord le package :

pip install langchainVous devrez également configurer les clés d'API nécessaires aux modèles et aux outils que vous souhaitez utiliser. Par exemple, pour utiliser les modèles d'OpenAI :

import os

os.environ["OPENAI_API_KEY"] = "votre_clé_d'API_ici"À partir de là, vous pouvez commencer à charger des données, à créer des chaînes et à construire votre application ! Les documents de LangChain fournissent des guides détaillés et des exemples pour différents cas d'utilisation.

Au fur et à mesure que vous plongez plus profondément, vous pouvez explorer l'écosystème croissant des intégrations et extensions de LangChain. La communauté a développé des connecteurs vers de nombreuses sources de données, outils et frameworks, ce qui facilite l'intégration des LLM dans n'importe quel flux de travail.

Meilleurs cas d'utilisation de LlamaIndex par rapport à LangChain

LlamaIndex :

- Construction de moteurs de recherche et de systèmes de recherche d'informations

- Création de bases de connaissances et de chatbots FAQ

- Analyse et résumé de grandes collections de documents

- Permettre la recherche conversationnelle et les questions-réponses

LangChain :

- Développer des chatbots et des agents conversationnels

- Construire des pipelines et des workflows NLP personnalisés

- Intégrer des LLM avec des sources de données externes et des APIs

- Expérimenter avec différentes prompts, mémoires et configurations d'agents

LlamaIndex vs LangChain : Choisir le bon framework

Lorsque vous décidez entre LlamaIndex et LangChain, prenez en compte les facteurs suivants :

-

Exigences du projet : Si votre application se concentre principalement sur la recherche et la récupération, LlamaIndex pourrait correspondre davantage. Pour des tâches NLP plus diversifiées et des workflows personnalisés, LangChain offre une plus grande flexibilité.

-

Facilité d'utilisation : LlamaIndex offre une interface plus simplifiée et conviviale pour les débutants, tandis que LangChain nécessite une meilleure compréhension des concepts et des composants NLP.

-

Personnalisation : L'architecture modulaire de LangChain permet une personnalisation et un ajustement étendus, tandis que LlamaIndex propose une approche plus orientée opinion optimisée pour la recherche et la récupération.

-

Écosystème et communauté : Les deux frameworks ont des communautés actives et des écosystèmes en croissance. Explorez leur documentation, leurs exemples et leurs ressources communautaires pour évaluer le niveau de support et de ressources disponibles.

Conclusion

LlamaIndex et LangChain sont des frameworks puissants pour la création d'applications alimentées par des LLMs, chacun ayant ses propres forces et domaines d'expertise. LlamaIndex excelle dans les tâches de recherche et de récupération, offrant des capacités d'indexation et de requêtage de données simplifiées. D'autre part, LangChain adopte une approche modulaire, offrant un ensemble d'outils et de composants flexibles pour la création d'applications NLP diverses.

Lors du choix entre les deux, prenez en compte les exigences de votre projet, la facilité d'utilisation, les besoins de personnalisation et le support offert par leurs communautés respectives. Quel que soit votre choix, LlamaIndex et LangChain permettent aux développeurs de tirer parti du potentiel des grands modèles de langage et de créer des applications NLP innovantes.

Au fur et à mesure de votre parcours de développement d'applications LLM, n'hésitez pas à explorer les deux frameworks, à expérimenter avec leurs fonctionnalités et à tirer parti de leurs forces pour créer des expériences de langage naturel puissantes et attrayantes.