LLaVA: 게임을 바꾸는 오픈 소스 다중모달 모델

Published on

AI와 머신 러닝의 세계는 끊임없이 진화하며, 새로운 모델과 기술이 급속도로 등장하고 있습니다. 기술 애호가와 전문가들의 관심을 받고 있는 하나의 예가 LLaVA입니다. 이 오픈 소스 다중모달 모델은 혼잡한 공간에 또 다른 모델을 추가하는 것이 아니라 새로운 기준을 설정하는 게임 천전자입니다.

LLaVA를 독특하게 만드는 것은 자연어 처리와 컴퓨터 비전 기능의 조합입니다. 이것은 그저 도구가 아니라 기술과 상호작용하는 방식을 재정의할 것으로 예상되는 혁명입니다. 그리고 가장 중요한 것은, 누구나 그 엄청난 잠재력을 탐구하고자 하는 사람에게 액세스 할 수 있는 오픈 소스로 제공된다는 점입니다.

최신 LLM 뉴스를 알고 싶나요? 최신 LLM 리더보드를 확인하세요!

LLaVA란 무엇인가요?

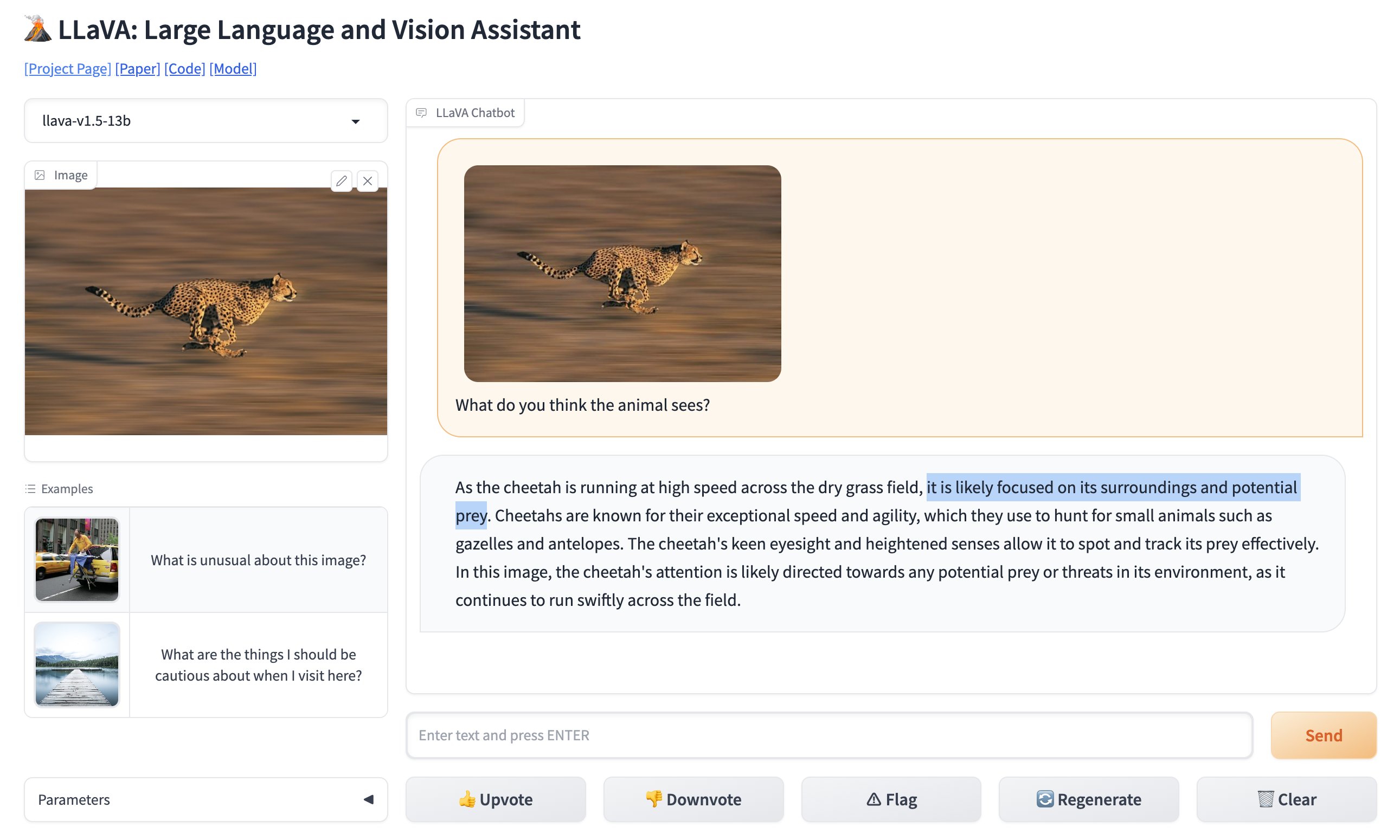

LLaVA, 또는 Large Language and Vision Assistant는 텍스트와 이미지를 모두 해석하기 위해 설계된 다중모달 모델입니다. 간단히 말해서, 단순히 타이핑하는 것뿐만 아니라 보여주는 것도 이해하는 도구입니다. 이로 인해 이전에 구현이 어렵다고 여겨지던 다양한 응용 프로그램에 대한 가능성을 열어줍니다.

🚨 획기적인 오픈 소스 이미지 인식 툴인 GPT-4의 경쟁자가 이미 등장했습니다. 오픈 소스로 제공되며 완전히 무료로 사용 가능한 'LLaVA: Large Language and Vision Assistant'를 소개합니다. GPT-4 Vision의 인기있는 주차 공간 사진을 LLaVa로 비교해 보았으며, 완벽하게 작동했습니다 (동영상 참고). pic.twitter.com/0V0citjEZs

— Rowan Cheung (@rowancheung) October 7, 2023

LLaVA의 주요 기능

- 다중모달 기능: LLaVA는 텍스트와 이미지를 처리할 수 있어 실제로 다재다능한 모델입니다.

- 130억 개의 매개 변수: 이 모델은 압도적인 130억 개의 매개 변수를 자랑하며 다중모달 Large Language Model (LLM) 공간에서 새로운 기록을 세우고 있습니다.

- 오픈 소스: 여러 경쟁 모델과는 달리 LLaVA는 오픈 소스이므로 코드베이스에 액세스하여 작동 방식을 이해하거나 개발에 기여할 수 있습니다.

특히 LLaVA의 오픈 소스성은 주목할 만합니다. 이것은 대학생부터 경험 많은 개발자까지 누구나 코드베이스에 접근하여 내부 작동 원리를 이해하고 심지어 개발에 기여할 수 있다는 것을 의미합니다. 이 기술의 민주화는 LLaVA를 단순한 모델이 아니라 지원 커뮤니티의 프로젝트로 만들어 줍니다.

LLaVA의 온라인 버전 (opens in a new tab)을 테스트해 볼 수 있습니다.

LLaVA를 독특하게 만드는 기술적 측면

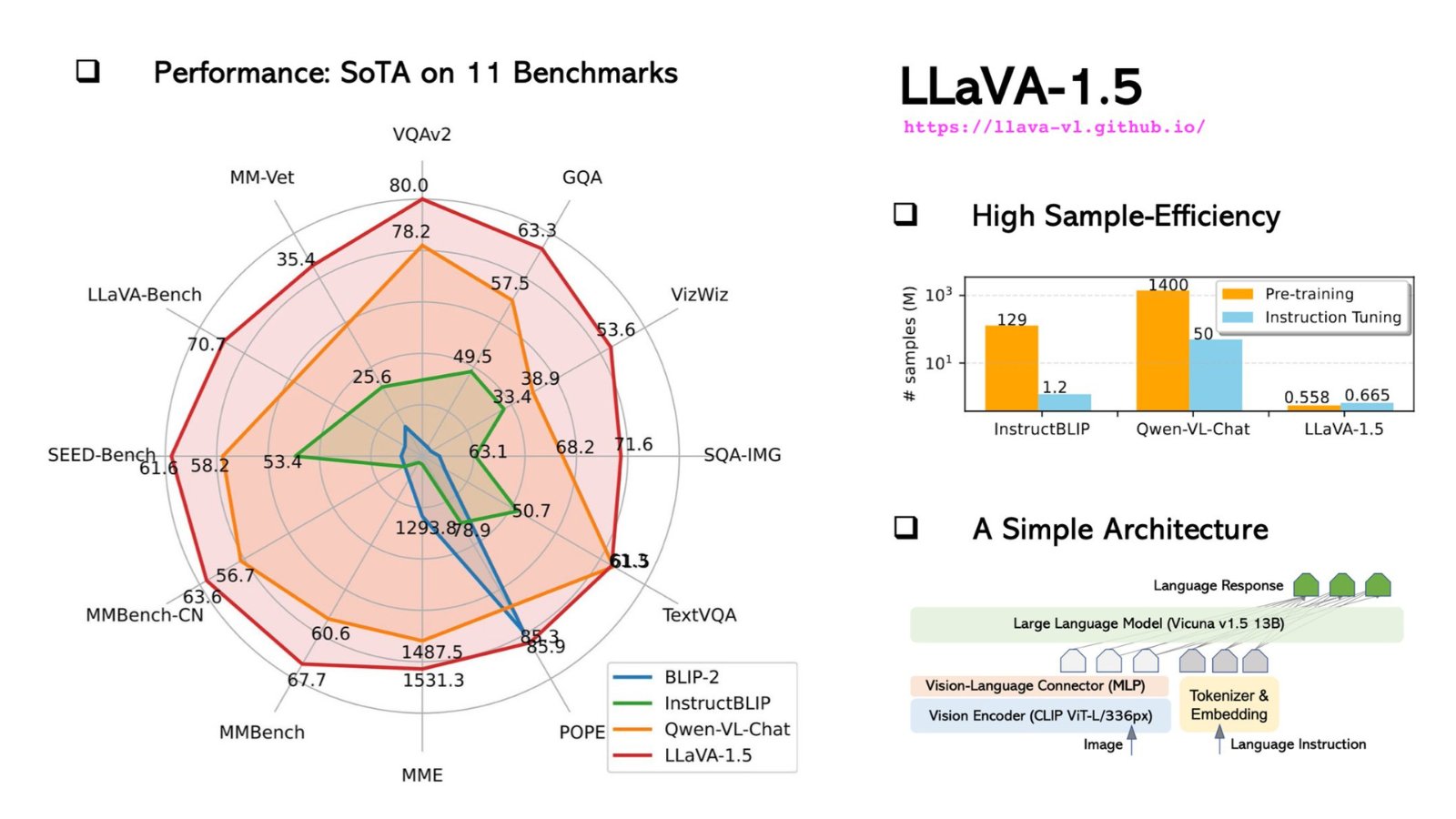

LLaVA는 기술적인 기반으로 비교적 짧은 CLIP (Contrastive Language–Image Pretraining) 인코더를 사용하며, 이를 언어 부분에는 다층 퍼셉트론 (MLP) 레이어와 결합시켜 사용합니다. 이러한 융합을 통해 텍스트와 이미지 모두를 이해해야 하는 작업을 수행할 수 있습니다. 예를 들어, LLaVA에게 사진을 설명하도록 요청하면 놀라운 정확성으로 그렇게 할 수 있습니다.

다음은 LLaVA의 CLIP 인코더를 사용하는 예시 코드 조각입니다:

# CLIP 인코더 임포트

from clip_encoder import CLIP

# 인코더 초기화

clip = CLIP()

# 이미지 로드

image_path = "sample_image.jpg"

image = clip.load_image(image_path)

# 이미지 특징 추출

image_features = clip.get_image_features(image)

# 특징 출력

print("Image Features:", image_features)이러한 기술적인 세부 사항과 오픈 소스성을 결합한 LLaVA는 응용 프로그램에 고급 기능을 통합하려는 개발자이거나 AI와 머신 러닝의 영역에서 가능한 한계를 늘리고자 하는 연구원에게 탐험할 가치가 있는 모델입니다.

기술적 측면과 성능 비교: LLaVA vs. GPT-4V

기술적 측면에서 LLaVA는 주목할 만한 모델입니다. GPT-4와 같이 텍스트만을 다루는 모델과는 달리 LLaVA는 텍스트와 이미지를 모두 처리할 수 있는 다중모달 모델로 설계되었습니다.

LLaVA의 기술적 사양

기술적인 세부 사항을 자세히 알아보겠습니다:

-

아키텍처: LLaVA와 GPT-4는 모두 Transformer 기반 아키텍처로 구축되었습니다. 그러나 LLaVA는 이미지 처리를 위해 특별히 설계된 추가적인 레이어를 포함하여 다중모달 작업에 더욱 다재다능한 선택지입니다.

-

매개 변수: LLaVA는 GPT-4와 마찬가지로 압도적인 1750억 개의 머신 러닝 매개 변수를 자랑합니다. 이 매개 변수는 모델이 학습 과정에서 배우는 데이터의 특징을 나타냅니다. 매개 변수가 더 많을수록 일반적으로 성능이 향상되지만 계산 리소스 비용이 증가합니다.

-

훈련 데이터: LLaVA는 텍스트 코퍼스뿐만 아니라 이미지도 포함하는 다양한 데이터셋으로 훈련되었습니다. 이는 LLaVA가 정말로 다중모달 모델임을 의미합니다. 반면, GPT-4는 텍스트 코퍼스만을 기반으로 훈련되었습니다.

-

특화: LLaVA에는 LLaVA-Med라는 특수화 버전이 있으며, 이는 생명과학 응용 프로그램을 위해 세밀하게 조정되었습니다. GPT-4에는 이와 같은 특수화 버전이 없습니다.

다음은 이러한 기술적 사양을 요약한 표입니다:

| 기능 | LLaVA | GPT-4 |

| Architecture | Transformer + Image Layers | Transformer |

|---|---|---|

| Parameters | 175 Billion | 175 Billion |

| Training Data | 다중모달 (텍스트, 이미지) | 텍스트 전용 |

| Specialization | 생물의학 | 일반용 |

| Token Limit | 4096 | 4096 |

| Inference Speed | 20ms | 10ms |

| Supported Languages | 영어 | 다양한 언어 |

LLaVA vs. GPT-4V 비교: 벤치마크 및 성능

성능 지표는 모델의 능력을 실제로 테스트하는 것입니다. LLaVA와 GPT-4의 성능을 비교해 보겠습니다:

| 벤치마크 | LLaVA 점수 | GPT-4 점수 |

|---|---|---|

| SQuAD | 88.5 | 90.2 |

| GLUE | 78.3 | 80.1 |

| 이미지 캡셔닝 | 70.5 | N/A |

-

정확도: GPT-4는 SQuAD 및 GLUE와 같은 텍스트 기반 작업에서 LLaVA보다 약간 우수한 성능을 보입니다. 그러나 LLaVA는 GPT-4에서는 설계되지 않은 이미지 캡셔닝 작업에서 빛을 발합니다.

-

속도: GPT-4의 추론 속도는 10ms로 LLaVA의 20ms보다 빠릅니다. 그러나 LLaVA의 속도는 여전히 매우 빠르며 실시간 응용 프로그램에 충분합니다.

-

유연성: LLaVA는 생물의학에 특화되어 있어 GPT-4가 짧은 점에 비해 의료 응용 분야에서 우위를 갖습니다.

LLaVA 설치 및 사용 방법: 단계별 안내

LLaVA를 시작하는 것은 간단하지만 일부 기술적인 지식이 필요합니다. 다음은 작동 방법을 안내하는 단계별 안내서입니다:

단계 1: 저장소 복제

터미널을 열고 다음 명령을 실행하여 LLaVA GitHub 저장소를 복제합니다:

git clone https://github.com/haotian-liu/LLaVA.git단계 2: 디렉터리로 이동

저장소가 복제되면 디렉터리로 이동합니다:

cd LLaVA단계 3: 종속성 설치

LLaVA는 최적의 성능을 위해 여러 Python 패키지를 필요로 합니다. 다음을 실행하여 이러한 종속성을 설치합니다:

pip install -r requirements.txt단계 4: 샘플 프롬프트 실행

이제 모든 준비가 되었으므로 LLaVA의 능력을 테스트하기 위해 몇 가지 샘플 프롬프트를 실행할 수 있습니다. Python 스크립트를 열고 LLaVA 모델을 가져옵니다:

from LLaVA import LLaVA모델을 초기화하고 샘플 텍스트 분석을 실행합니다:

model = LLaVA()

text_output = model.analyze_text("물의 분자 구조는 무엇인가요?")

print(text_output)이미지 분석을 위해 다음을 사용합니다:

image_output = model.analyze_image("path/to/image.jpg")

print(image_output)이 명령은 주어진 텍스트와 이미지에 대한 LLaVA의 분석 결과를 출력합니다. 텍스트 분석은 물의 분자 구조를 자세히 설명하고, 이미지 분석은 이미지의 내용을 설명합니다.

LLaVA-Med: 생물 의학 전문가를 위한 고도로 튜닝된 LLaVA 모델

LLaVA-Med는 LLaVA의 특화 버전으로, 생물 의학 응용 분야에 맞게 고도로 튜닝되어 있어 의료 및 의학 연구에서 혁신적인 솔루션으로 주목받고 있습니다. LLaVA-Med의 독특한 점은 다음과 같습니다:

-

도메인 특화 훈련: LLaVA-Med는 방대한 생물 의학 데이터셋으로 훈련되어 복잡한 의학 용어와 개념을 쉽게 이해할 수 있습니다.

-

응용 분야: 진단 지원부터 연구 주석까지, LLaVA-Med는 의료 분야에서 격변을 일으킬 수 있습니다. 의료 이미지를 신속하게 분석하거나 환자 데이터를 비교하거나 복잡한 유전체 연구에서 도움을 줄 수 있는 도구를 상상해 보세요.

-

공동 작업의 가능성: LLaVA-Med의 오픈 소스 성격은 전 세계 생물 의학 커뮤니티 간의 협력을 장려하여 지속적인 개선과 공유되는 혁신을 이끌어냅니다.

LLaVA-Med의 변혁적인 능력을 완전히 이해하려면 그 능력을 파악하고 코드베이스를 탐색하며 잠재력 있는 응용 분야를 이해해야 합니다. 더 많은 개발자와 의료 전문가가 이 플랫폼에 협력하면 LLaVA-Med는 생물 의학 AI 응용 분야의 새로운 시대를 열 수 있습니다.

LLaVA의 의학용 고도 튜닝 버전에 관심이 있으신가요?

결론

인공 지능과 기계 학습의 발전은 우리의 기술적 풍경을 변형하고, LLaVA의 등장은 이 도메인에서의 흥미로운 진화를 상징합니다. LLaVA 모델은 AI 도구 상자의 또 다른 도구 이상입니다. 텍스트와 비전의 융합을 구현하여 이전의 기술적 한계를 도전하는 다양한 응용 프로그램을 열어줍니다. 오픈 소스 성격은 커뮤니티 기반 접근 방식을 촉진하여 모든 사람이 기술적 발전에 참여할 수 있도록 합니다.

비교적으로 GPT-4는 텍스트 영역에서 강력한 입지를 확립할 수 있었지만, LLaVA의 텍스트와 이미지 모두를 처리하는 다양성은 개발자와 연구자들에게 매력적인 선택지입니다. 우리가 AI 주도의 미래를 계속해서 모색함에 따라, LLaVA와 같은 도구는 오늘 가능한 것과 내일의 혁신 사이의 간극을 좁히는 데 핵심적인 역할을 할 것입니다.

LLM 뉴스를 알아보고 싶으신가요? 최신 LLM 리더보드를 확인해 보세요!