Guanaco 65B: GPT-4에 도전하는 오픈 소스 파인튜닝 가능한 챗봇

Published on

인공 지능의 끊임없이 진화하는 세계에서 텍스트 생성 모델은 챗봇부터 콘텐츠 생성까지 다양한 응용 프로그램의 근간이 되었습니다. Guanaco 65B는 뛰어난 능력으로 주목받은 혁신적인 모델로서 돋보입니다. 그렇다면 이 모델을 특별하게 만드는 요소는 무엇일까요? 이 포괄적인 가이드에서는 Guanaco 65B의 세부 사항, 호환성 기능, 그리고 어떻게 사용할 수 있는지 알아보겠습니다.

개발자, 데이터 과학자 또는 AI 애호가라면 Guanaco 65B를 이해하는 것은 이 분야에서의 큰 발전이 될 수 있습니다. 텍스트 생성, 데이터 분석, 새로운 응용 프로그램 개발 등을 원한다면 이 가이드는 궁극적인 자료가 될 것입니다. 자, 시작해봅시다!

최신 LLM 뉴스를 알고 싶나요? 최신 LLM 리더보드를 확인해보세요!

Guanaco 65B란 무엇이며 왜 중요한가요?

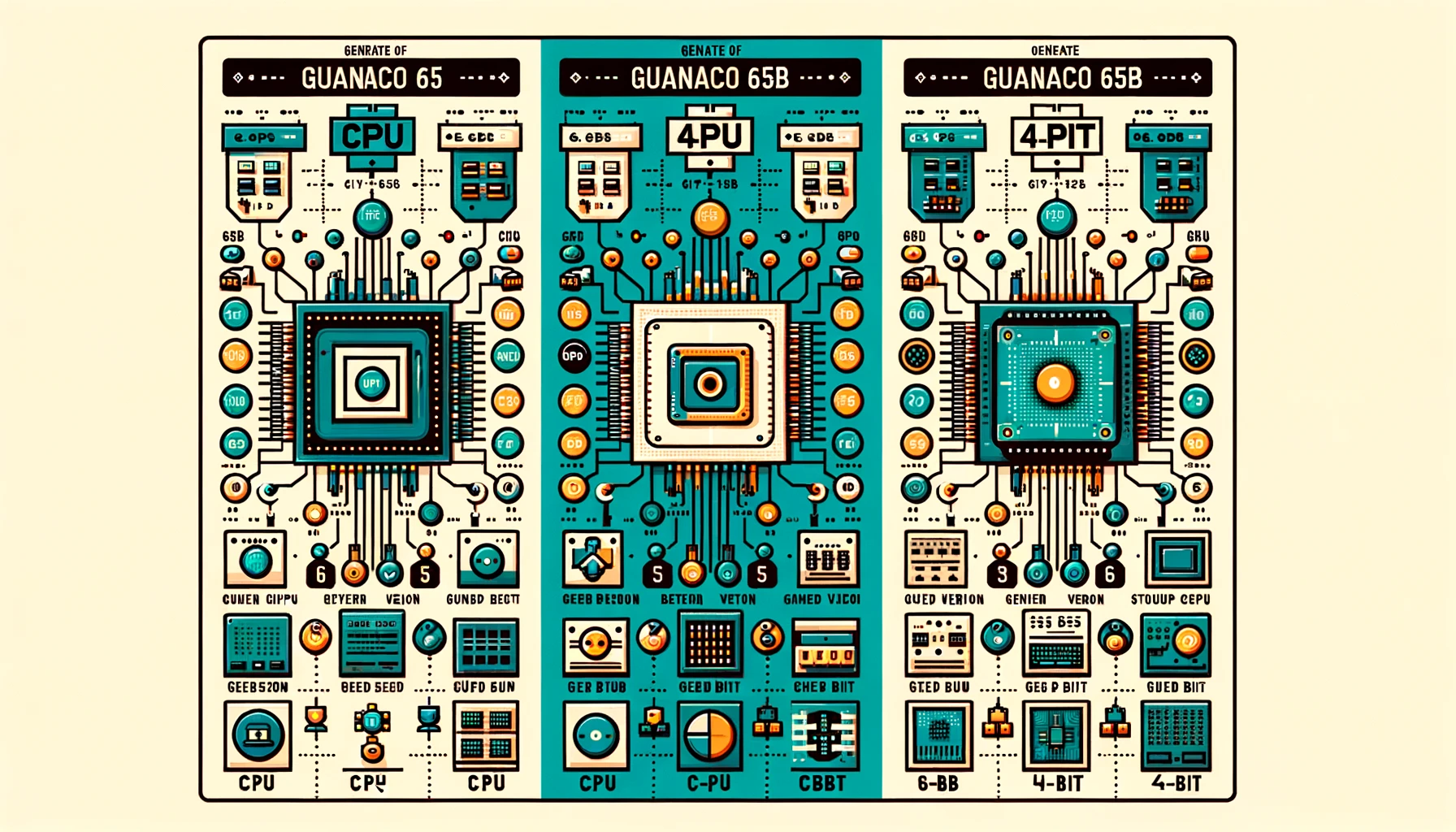

Guanaco 65B는 텍스트 생성을 위한 최첨단 언어 모델입니다. 단순히 다른 모델이 아닌 가변적이고 강력한 도구로, 다른 하드웨어 요구사항에 맞춰 여러 버전으로 제공됩니다. CPU 또는 고성능 GPU를 사용하든 Guanaco 65B가 있습니다. 이제 이러한 버전들을 자세히 살펴봅시다.

Guanaco 65B의 성능 평가

Guanaco 65B와 같은 언어 모델의 성능을 평가할 때 기준이 되는 것은 중요합니다. 속도, 정확도, 전반적인 기능 등을 측정하는 표준화된 방법을 제공하며 이것을 벤치마킹(benchmarks)이라고 합니다. 그러나 벤치마킹만으로 모델의 효과를 평가하는 것은 아닙니다. 사용자 경험과 커뮤니티 토론 역시 중요한 통찰을 제공합니다.

유감스럽게도, 현재 Guanaco 65B는 공식 리더보드에 등재되어 있지 않습니다. 그러나 다음 사항을 고려해야 합니다:

- 파인튜닝: Guanaco 65B는 65B 아키텍처를 위한 소수의 파인튜닝 모델 중 하나로서 독특한 제공물입니다.

- 전문적인 작업: QLoRA와의 호환성을 통해 모델이 쿼리 기반 작업에 뛰어나다는 가능성을 시사합니다. 당연히 이는 경험적으로 검증되어야 합니다.

Guanaco 65B의 장점

모델을 사용한 후에는 Guanaco-65B의 다음과 같은 장점을 찾을 수 있습니다:

- 속도와 효율성: 사용자 중 일부는 65B 버전이 느려져 특정 작업에 대한 유용성이 감소한다고 지적했습니다.

- 역할 연기와 캐릭터 일관성: 사용자들은 캐릭터 카드를 사용할 때 특히 Guanaco 모델이 역할 일관성을 유지하는 데 뛰어나다고 지적했습니다.

- 텍스트 생성: Guanaco 모델은 프롬프트를 효과적으로 이해하면서 많은 텍스트를 생성하는 능력이 칭찬받았습니다.

Guanaco 65B의 라이선스

Guanaco 65B의 세계에 빠지기 전에, 각 버전에 따라 어떤 라이선스가 적용되는지 이해하는 것이 중요합니다. 다양한 라이선스는 모델의 사용, 수정, 배포 방법을 규정합니다.

- 오픈 소스 라이선스: 일부 버전은 오픈 소스 라이선스로 제공되어 무료로 사용하고 수정할 수 있습니다.

- 상업용 라이선스: 다른 버전은 상업용 라이선스가 필요할 수 있습니다. 특히 영리 목적으로 모델을 사용하려는 경우에 해당합니다.

Guanaco 65B의 Huggingface 페이지는 여기 (opens in a new tab)에서 확인할 수 있습니다.

Guanaco 65B 사용 안내서

텍스트 생성 모델의 세계를 탐험하는 것은 처음이라면 다소 어렵게 느껴질 수 있습니다. 그래서 Guanaco 65B를 사용하여 시작하는 포괄적인 단계별 안내서를 준비했습니다.

단계 1. Guanaco 65B 다운로드하기

텍스트를 생성하기 전에 필요에 맞는 Guanaco 65B 모델을 다운로드해야 합니다. 아래와 같은 방법으로 진행해 보세요.

- Hugging Face 저장소 방문: Hugging Face 웹사이트로 이동하여 원하는 Guanaco 65B 버전을 검색합니다.

- 모델 선택: 모델을 클릭하여 해당 모델의 전용 페이지로 이동합니다.

- 모델 이름 복사: 페이지 상단 근처에서 모델 이름을 찾아 나중에 사용할 수 있도록 복사합니다.

단계 2. Guanaco 65B를 사용한 텍스트 생성

모델을 다운로드한 후에는 코드를 작성할 시간입니다. 아래는 Guanaco 65B를 사용한 텍스트 생성 방법을 보여주는 Python 샘플 코드입니다.

from transformers import AutoTokenizer, AutoModelForCausalLM

# 토크나이저와 모델 초기화

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# 텍스트 입력 준비

input_text = "Tell me a joke."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# 텍스트 생성

output = model.generate(input_ids)

# 생성된 텍스트 디코딩 및 출력

print(tokenizer.decode(output[0], skip_special_tokens=True))이 코드를 실행하려면 transformers 라이브러리가 설치된 상태여야 합니다. 그렇지 않다면 다음과 같이 pip를 사용하여 설치할 수 있습니다.

pip install transformers이제 Guanaco 65B를 사용하여 텍스트를 생성하기 위한 간단하고 효과적인 방법을 알게 되었습니다. 챗봇, 콘텐츠 생성기, 텍스트 기반 응용 프로그램 등 어떤 분야에서든 이 모델을 활용할 수 있습니다.

단계 3. Google Colab에서 Guanaco 65B 사용하기

보다 실용적인 방법을 선호하는 경우, Guanaco 65B를 Google Colab 노트북에서 쉽게 사용할 수 있습니다. 이를 통해 설정의 고민 없이 모델을 실험해볼 수 있습니다.

- 사용 편의성: Colab 노트북에서 모델을 가져와 사용하기만 하면 됩니다.

- 협업: Colab의 공유 기능을 통해 프로젝트에 대한 협업이 쉽습니다.

Google Colab에서 Guanaco 65B를 사용하는 빠른 코드 조각입니다:

# Google Colab에서 Guanaco 65B를 사용하는 샘플 코드

# 먼저 transformers 라이브러리를 설치해야 합니다.

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "What is AI?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Guanaco 65B의 다른 버전

4비트 Guanaco 65B 버전 사용하기

성능과 메모리 최적화를 위해, 4비트 Guanaco 65B-GPTQ 버전은 게임 체인저입니다. 이 버전은 GPU에서 실행되도록 설계되었지만, 모델의 크기를 크게 희생하지 않고 크기를 줄이기 위해 양자화를 사용합니다.

기능:

- 메모리 사용량 감소: 4비트 양자화는 VRAM 요구 사항을 크게 줄입니다.

- 다양한 양자화 매개변수: 특정 요구 사항을 기반으로 사용자 정의가 가능합니다.

- 원본 성능에 가까운 성능: 크기가 줄어들었지만 모델은 높은 수준의 정확도를 유지합니다.

누가 사용해야 할까요?

- 효율적인 머신러닝에 초점을 맞춘 연구자

- 제한된 GPU 자원을 가진 개발자

- 엣지 컴퓨팅에 관심이 있는 모든 이들

Guanaco 65B-GPTQ를 사용하는 예시 코드 조각입니다:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "What's the weather like?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))적절한 Guanaco 65B 버전을 선택함으로써 하드웨어 성능에 맞게 텍스트 생성 작업을 맞춤 설정할 수 있습니다. CPU, GPU 또는 4비트 버전 중 어느 것을 선택하든 각각 독특한 장점을 제공하여 다양한 요구 사항을 충족시킵니다.

QLoRA와 함께 Guanaco 65B 사용하기

Guanaco 65B의 중요한 기능 중 하나는 QLoRA와의 호환성입니다. 이 기능을 통해 더 구체적이고 목표-oriented 텍스트 생성 작업을 수행할 수 있습니다.

- 쿼리 기반 작업: 검색 엔진이나 추천 시스템에 이상적입니다.

- 향상된 정확성: QLoRA 호환성은 더 정확하고 관련성 있는 텍스트 생성을 보장합니다.

QLoRA와 함께 Guanaco 65B를 사용하는 예시 코드 조각입니다:

# QLoRA와 함께 Guanaco 65B를 사용하는 샘플 코드

# 참고: 이것은 가상의 예시입니다; 실제 구현은 달라질 수 있습니다.

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "프랑스의 수도는 무엇인가요?"

response = qlora_model.generate(query)

print(response)결론: Guanaco 65B가 게임 체인저인 이유

이 포괄적인 가이드를 마치면, Guanaco 65B가 또 다른 텍스트 생성 모델이 아니라는 것이 명확해집니다. 이 모델은 다양한 응용 분야와 하드웨어 설정에 맞춤 설정할 수 있는 다재다능하고 강력하며 매우 유연한 도구입니다. 다른 버전부터 QLoRA와의 호환성까지, Guanaco 65B는 텍스트 생성 분야에서 진정한 게임 체인저입니다.

경험 많은 개발자든 호기심 많은 열정가든, 이 모델은 모두에게 무언가를 제공합니다. 그러니 더 이상 기다릴 필요는 없습니다. 지금 Guanaco 65B의 세계로 뛰어들어 텍스트 생성의 미래를 해제하세요!

최신 LLM 뉴스를 알고 싶나요? 최신 LLM 리더보드를 확인해보세요!