LlamaIndex vs LangChain: Comparando Frameworks Poderosos de Aplicações LLM

Published on

Introdução

No mundo do processamento de linguagem natural (NLP) e modelos de linguagem grandes (LLM), os desenvolvedores estão constantemente em busca de ferramentas poderosas para construir aplicações de ponta. Dois frameworks proeminentes têm se destacado nesse domínio: LlamaIndex e LangChain. Embora ambos visem simplificar a integração de LLMs em aplicações personalizadas, eles diferem em sua abordagem e foco. Neste artigo, iremos mergulhar nas principais distinções entre LlamaIndex e LangChain, ajudando você a tomar uma decisão informada ao escolher um framework para seus projetos.

Parte 1. O que é LlamaIndex?

LlamaIndex é um poderoso framework de dados que permite conectar facilmente seus próprios dados aos LLMs. Ele fornece conectores de dados flexíveis para ingestão de dados de uma variedade de fontes como APIs, bancos de dados, PDFs e muito mais. Esses dados privados são então indexados em representações otimizadas que os LLMs podem acessar e interpretar em grande escala, sem a necessidade de retreinar o modelo subjacente.

LlamaIndex capacita os LLMs com uma "memória" dos seus dados privados que eles podem aproveitar para fornecer respostas informadas e contextuais. Se você deseja construir um chatbot sobre a documentação da sua empresa, uma ferramenta de análise personalizada de currículos ou um assistente de IA capaz de responder a perguntas sobre um domínio de conhecimento específico, LlamaIndex torna isso possível com apenas algumas linhas de código.

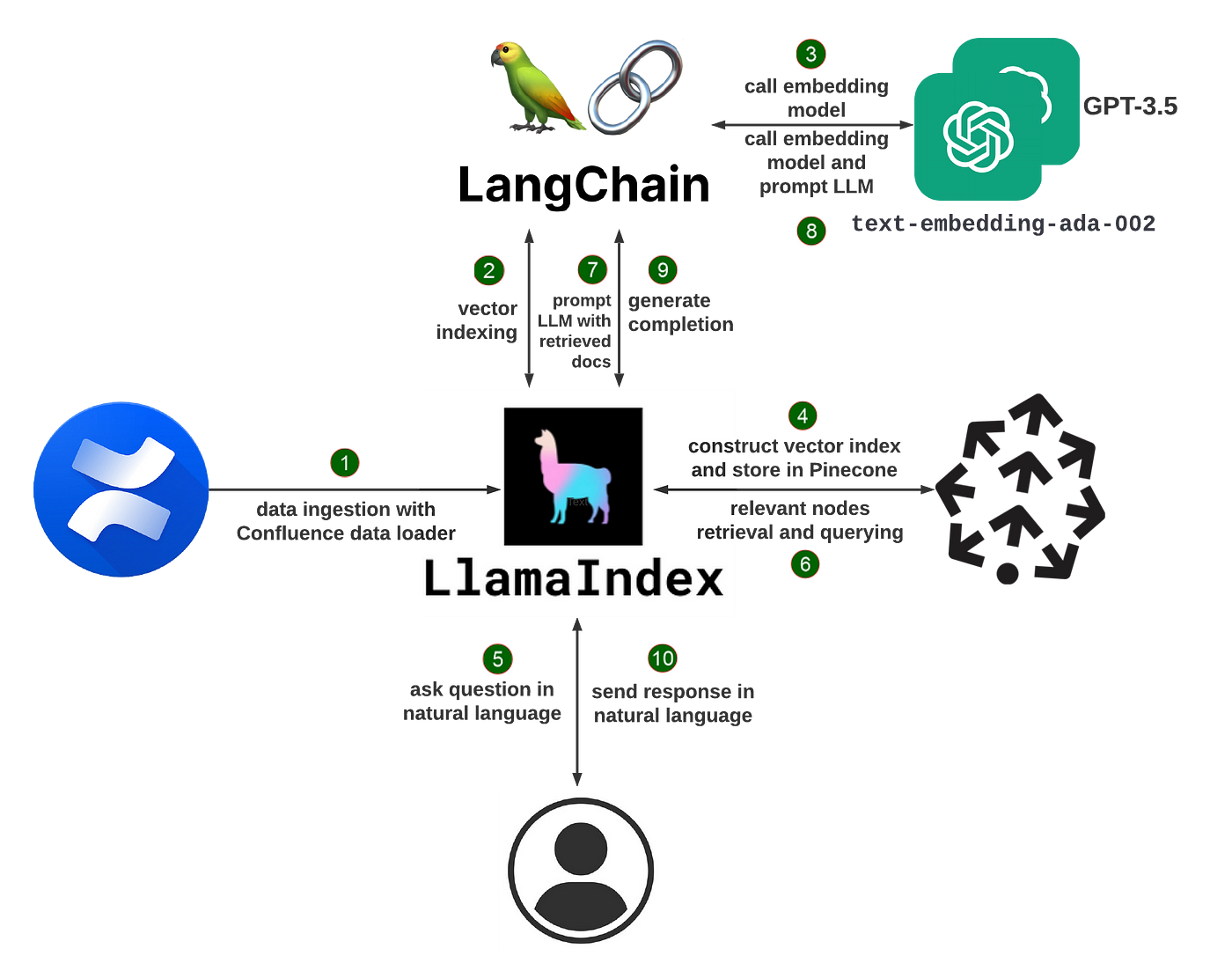

Como LlamaIndex Funciona

Em sua essência, LlamaIndex utiliza uma técnica chamada geração aumentada por recuperação (RAG). Um sistema RAG típico possui duas etapas principais:

-

Etapa de Indexação: Durante a indexação, seus dados privados são convertidos de forma eficiente em um índice vetorial pesquisável. LlamaIndex pode processar documentos de texto não estruturados, registros estruturados de banco de dados, grafos de conhecimento e muito mais. Os dados são transformados em embeddings numéricos que capturam seu significado semântico, permitindo buscas rápidas de similaridade posteriormente.

-

Etapa de Consulta: Quando um usuário faz uma consulta ao sistema, os trechos de informações mais relevantes são recuperados do índice vetorial com base na similaridade semântica da consulta. Esses trechos, juntamente com a consulta original, são passados para o LLM, que gera uma resposta final. Ao buscar dinamicamente o contexto pertinente, o LLM pode fornecer respostas de maior qualidade e mais factuais do que poderia apenas com seu conhecimento básico.

LlamaIndex abstrai grande parte da complexidade de construir um sistema RAG. Ele oferece APIs de alto nível que permitem começar com apenas algumas linhas de código, bem como blocos de construção de baixo nível para customização detalhada do pipeline de dados.

Construindo um Chatbot de Currículo com LlamaIndex

Para ilustrar as capacidades do LlamaIndex, vamos construir um chatbot que pode responder perguntas sobre o seu currículo.

Primeiro, instale os pacotes necessários:

pip install llama-index openai pypdfEm seguida, carregue seu currículo em PDF e construa um índice:

from llama_index import TreeIndex, SimpleDirectoryReader

resume = SimpleDirectoryReader("caminho/para/curriculo").load_data()

index = TreeIndex.from_documents(resume)Agora você pode fazer consultas no índice usando linguagem natural:

query_engine = index.as_query_engine()

response = query_engine.query("Qual é o título do cargo?")

print(response)O mecanismo de consulta buscará no índice do currículo e retornará o trecho mais relevante como resposta, por exemplo, "O título do cargo é Engenheiro de Software".

Você também pode participar de uma conversa contínua:

chat_engine = index.as_chat_engine()

response = chat_engine.chat("O que essa pessoa fez em seu último cargo?")

print(response)

follow_up = chat_engine.chat("Quais linguagens de programação ela utilizou?")

print(follow_up)O mecanismo de chat mantém o contexto da conversa, permitindo fazer perguntas de acompanhamento sem mencionar explicitamente o assunto novamente.

Para evitar reconstruir o índice toda vez, você pode armazená-lo em disco:

index.storage_context.persist()E carregá-lo posteriormente:

from llama_index import StorageContext, load_index_from_storage

storage_context = StorageContext.from_defaults(persist_dir="./storage")

index = load_index_from_storage(storage_context)Além dos Chatbots: Casos de Uso do LlamaIndex

Chatbots são apenas uma das muitas aplicações que você pode construir com o LlamaIndex. Alguns outros exemplos incluem:

- Perguntas e respostas sobre documentos extensos: Ingestão de documentos como manuais, contratos legais ou artigos de pesquisa e fazer perguntas sobre seu conteúdo

- Recomendações personalizadas: Construir índices sobre catálogos de produtos ou bibliotecas de conteúdo e fornecer recomendações com base nas consultas do usuário

- Agentes orientados por dados: Criar assistentes de IA que podem acessar e realizar ações em bancos de dados, APIs e outras ferramentas para completar tarefas complexas

- Construção de base de conhecimento: Extrair automaticamente dados estruturados como entidades e relacionamentos de texto não estruturado para construir grafos de conhecimento

LlamaIndex fornece um conjunto de ferramentas flexíveis para construir todos os tipos de aplicativos alimentados por LLMs. Você pode combinar carregadores de dados, índices, motores de consulta, agentes e muito mais para criar pipelines personalizados para seu caso de uso.

Começando com o LlamaIndex

Para começar a construir com o LlamaIndex, primeiro instale o pacote:

pip install llama-indexVocê também precisará de uma chave de API da OpenAI para acessar os modelos subjacentes padrão. Configure-a como uma variável de ambiente:

import osos.environ["OPENAI_API_KEY"] = "sua_chave_api_aqui"

A partir daí, você pode começar a ingestão de dados e construir índices! A documentação do LlamaIndex fornece orientações detalhadas e exemplos para casos de uso comuns.

Conforme você aprofunda, pode explorar o Llama Hub - uma coleção de carregadores de dados, índices, mecanismos de consulta e muito mais contribuídos pela comunidade. Você pode usar esses plugins prontos para uso ou como ponto de partida para seus próprios componentes personalizados.

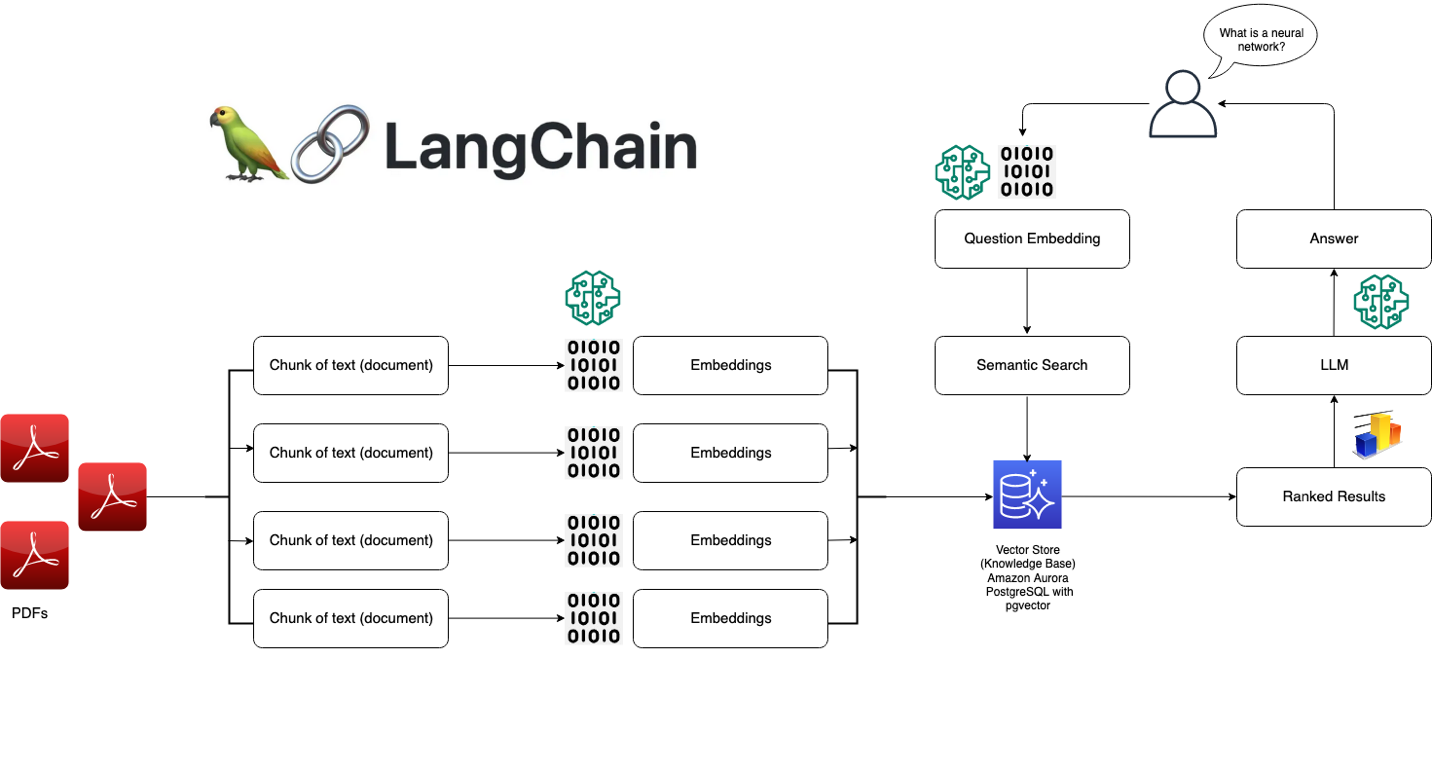

### O que é o LangChain?

LangChain é um framework poderoso para desenvolver aplicativos alimentados por modelos de linguagem. Ele permite que você conecte facilmente seus próprios dados aos LLMs e construa aplicativos de modelo de linguagem conscientes de dados. LangChain fornece uma interface padrão para cadeias, muitas integrações com outras ferramentas, e cadeias de ponta a ponta para aplicativos comuns.

Com o LangChain, você pode carregar dados de várias fontes, como documentos, bancos de dados, APIs e bases de conhecimento. Esses dados privados são então acessíveis aos LLMs durante o tempo de inferência, permitindo que eles aproveitem esse contexto para fornecer respostas informativas e relevantes. Se você deseja construir um chatbot com base na documentação da sua empresa, uma ferramenta de análise de dados ou um assistente de IA que interage com seus bancos de dados e APIs, o LangChain torna isso possível.

### Como o LangChain funciona

Em seu núcleo, o LangChain é projetado em torno de alguns conceitos-chave:

1. Instruções: As instruções são as orientações que você dá ao modelo de linguagem para direcionar sua saída. O LangChain fornece uma interface padrão para a construção e trabalho com instruções.

2. Modelos: O LangChain fornece uma interface padrão para o trabalho com diferentes LLMs e uma maneira fácil de alternar entre eles. Ele suporta modelos como o GPT-3 da OpenAI, o Claude da Anthropic, os modelos da Cohere e outros.

3. Índices: Os índices se referem à forma como os dados textuais são armazenados e disponibilizados para o modelo de linguagem. O LangChain fornece diversas técnicas de indexação otimizadas para LLMs, como vetores em memória e incorporações.

4. Cadeias: As cadeias são sequências de chamadas para LLMs e outras ferramentas, com a saída de uma etapa sendo a entrada para a próxima. O LangChain fornece uma interface padrão para cadeias e muitos componentes reutilizáveis.

5. Agentes: Os agentes usam um LLM para determinar quais ações tomar e em que ordem. O LangChain fornece uma seleção de agentes que podem aproveitar ferramentas para realizar tarefas.

Com esses blocos de construção, você pode criar todo tipo de aplicativos poderosos com modelos de linguagem. O LangChain abstrai grande parte da complexidade, permitindo que você se concentre na lógica de alto nível do seu aplicativo.

### Construindo um sistema de perguntas e respostas com o LangChain

Para ilustrar as capacidades do LangChain, vamos percorrer a construção de um simples sistema de perguntas e respostas sobre um conjunto de documentos.

Primeiro, instale os pacotes necessários:

pip install langchain openai faiss-cpu

Em seguida, carregue seus dados e crie um índice:

```python

from langchain.document_loaders import TextLoader

from langchain.indexes import VectorstoreIndexCreator

carregador = TextLoader('caminho/para/documento.txt')

índice = VectorstoreIndexCreator().from_loaders([carregador])Agora você pode consultar o índice usando linguagem natural:

consulta = "Qual é o tópico principal deste documento?"

resultado = índice.query(consulta)

print(resultado)A consulta irá pesquisar o documento e retornar o trecho mais relevante como resposta.

Você também pode ter uma conversa com os dados usando uma ConversationalRetrievalChain:

from langchain.chains import ConversationalRetrievalChain

from langchain.chat_models import ChatOpenAI

modelo = ChatOpenAI(temperature=0)

qa = ConversationalRetrievalChain.from_llm(modelo, retriever=índice.vectorstore.as_retriever())

histórico_de_chat = []

while True:

consulta = input("Human: ")

resultado = qa({"question": consulta, "chat_history": histórico_de_chat})

histórico_de_chat.append((consulta, resultado['answer']))

print(f"Assistente: {resultado['answer']}")Isso permite uma conversa de ida e volta onde o modelo tem acesso ao contexto relevante dos documentos.

Além do Q&A: Casos de Uso do LangChain

A pergunta e resposta é apenas uma das muitas aplicativos que você pode construir com o LangChain. Alguns outros exemplos incluem:

- Chatbots: Crie agentes conversacionais que podem se envolver em diálogos livres, aproveitando dados privados

- Análise de dados: Conecte LLMs a bancos de dados SQL, estruturas de dados pandas e bibliotecas de visualização de dados para exploração interativa de dados

- Agentes: Desenvolva agentes de IA que podem usar ferramentas como navegadores de web, APIs e calculadoras para realizar tarefas abertas

- Geração de aplicativos: Gere automaticamente aplicativos inteiros a partir de especificações em linguagem natural

O LangChain fornece um conjunto flexível de componentes que podem ser combinados de várias maneiras para criar aplicativos poderosos com modelos de linguagem. Você pode usar as cadeias e agentes integrados ou criar seus próprios pipelines personalizados.

Começando com o LangChain

Para começar a construir com o LangChain, primeiro instale o pacote:

pip install langchainVocê também precisará configurar quaisquer chaves de API necessárias para os modelos e ferramentas que deseja usar. Por exemplo, para usar os modelos da OpenAI:

import os

os.environ["OPENAI_API_KEY"] = "sua_chave_api_aqui"A partir daí, você pode começar a carregar dados, criar cadeias e construir seu aplicativo! A documentação do LangChain fornece guias detalhados e exemplos para vários casos de uso.

Conforme você aprofunda, pode explorar o ecossistema em expansão de integrações e extensões do LangChain. A comunidade construiu conectores para inúmeras fontes de dados, ferramentas e estruturas, facilitando a incorporação de LLMs em qualquer fluxo de trabalho.

Melhores Casos de Uso do LlamaIndex vs LangChain

LlamaIndex:

- Construir mecanismos de busca e sistemas de recuperação de informações

- Criar bases de conhecimento e chatbots de perguntas frequentes

- Analisar e resumir grandes coleções de documentos

- Possibilitar busca conversacional e perguntas e respostas

LangChain:

- Desenvolvendo chatbots e agentes de conversação

- Construindo pipelines e fluxos de trabalho personalizados de PNL

- Integrando LLMs com fontes de dados externas e APIs

- Experimentando com diferentes prompts, memória e configurações do agente

LlamaIndex vs LangChain: Escolhendo o framework certo

Ao decidir entre LlamaIndex e LangChain, considere os seguintes fatores:

-

Requisitos do projeto: Se o seu aplicativo estiver focado principalmente em pesquisa e recuperação, o LlamaIndex pode ser uma opção melhor. Para tarefas de PNL mais diversas e fluxos de trabalho personalizados, o LangChain oferece maior flexibilidade.

-

Facilidade de uso: O LlamaIndex fornece uma interface mais simplificada e amigável para iniciantes, enquanto o LangChain requer um entendimento mais profundo dos conceitos e componentes de PNL.

-

Customização: A arquitetura modular do LangChain permite extensa customização e ajuste fino, enquanto o LlamaIndex oferece uma abordagem mais opinativa otimizada para pesquisa e recuperação.

-

Ecossistema e comunidade: Ambos os frameworks possuem comunidades ativas e ecossistemas em crescimento. Considere explorar sua documentação, exemplos e recursos da comunidade para avaliar o nível de suporte e recursos disponíveis.

Conclusão

LlamaIndex e LangChain são frameworks poderosos para construir aplicativos alimentados por LLM, cada um com suas próprias forças e áreas de foco. O LlamaIndex se destaca em tarefas de pesquisa e recuperação, oferecendo recursos simplificados de indexação e consulta de dados. Por outro lado, o LangChain adota uma abordagem modular, fornecendo um conjunto flexível de ferramentas e componentes para construir aplicativos de PNL diversos.

Ao escolher entre os dois, leve em consideração os requisitos do seu projeto, a facilidade de uso, as necessidades de customização e o suporte oferecido pelas respectivas comunidades. Independentemente da sua escolha, tanto o LlamaIndex quanto o LangChain capacitam os desenvolvedores a aproveitar o potencial de grandes modelos de linguagem e criar aplicativos de PNL inovadores.

Ao embarcar em sua jornada de desenvolvimento de aplicativos com LLM, não hesite em explorar ambos os frameworks, experimentar seus recursos e aproveitar suas vantagens para criar experiências de linguagem natural poderosas e envolventes.