GPT-4 Prompt Engineering: Comment commencer

Published on

Vous avez entendu parler de GPT-4, le dernier modèle de langage d'OpenAI qui fait sensation dans le monde de la technologie. Ce n'est pas simplement une mise à jour de plus ; c'est un véritable game-changer à bien des égards. Mais comment tirer le meilleur parti de cette technologie de pointe ? La réponse réside dans la compréhension des tenants et aboutissants de l'"ingénierie des prompts".

Plongeons dans ce guide complet qui dévoile le monde mystérieux de l'ingénierie des prompts de GPT-4. De la compréhension des bases de GPT-4 à la maîtrise de l'art de peaufiner ses performances grâce à des techniques de prompting avancées, cet article couvre tous les aspects.

Section 1 : Un regard attentif sur GPT-4

Quelles sont les capacités de GPT-4 ?

GPT-4, ou Generative Pre-trained Transformer 4, est un puissant modèle de langage développé par OpenAI. Il a atteint des performances de niveau humain sur divers benchmarks professionnels et académiques. En termes simples, c'est comme avoir un assistant super intelligent capable d'accomplir des tâches allant de la rédaction de code à la réponse à des questions complexes.

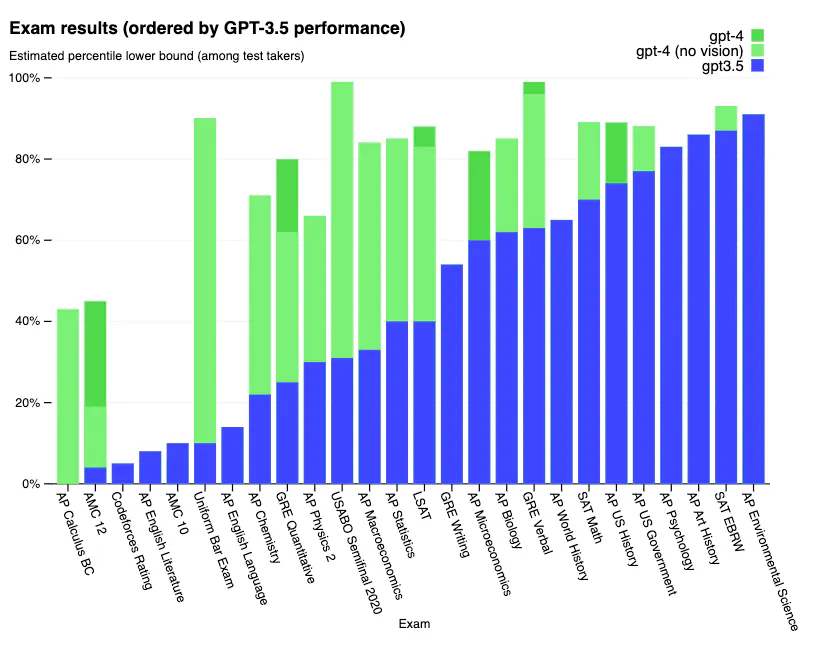

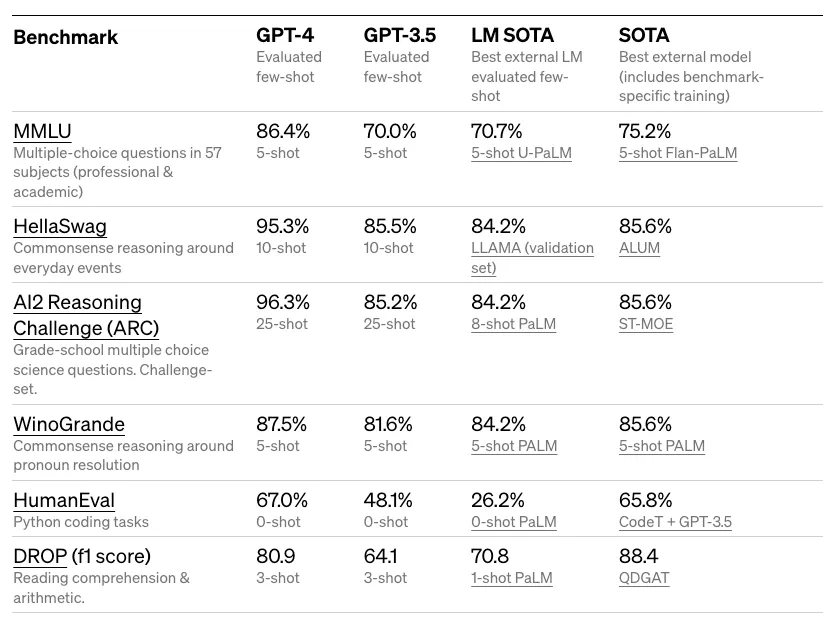

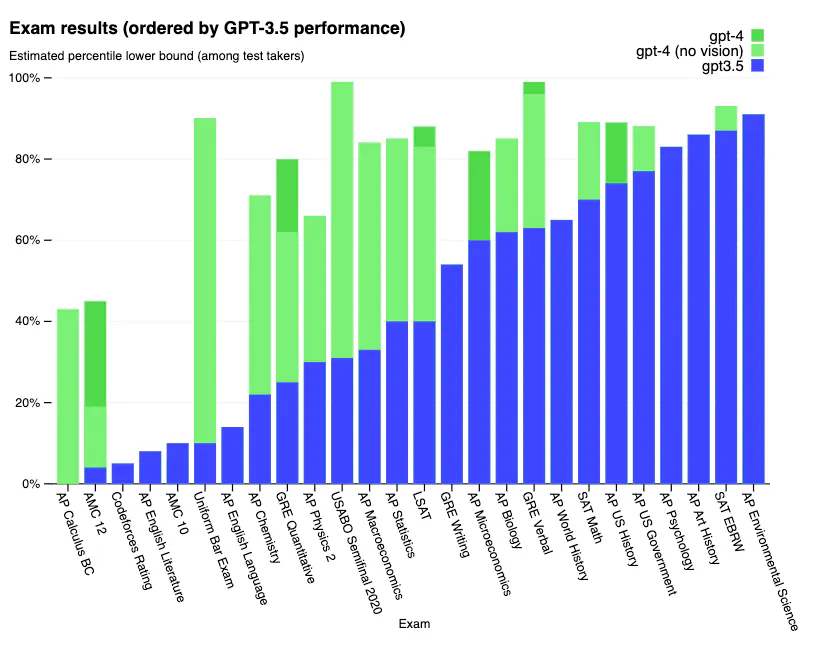

- Scores de référence impressionnants : GPT-4 a obtenu un score dans le top 10 % des participants aux examens de droit simulés. Il montre également des performances remarquables sur des benchmarks difficiles tels que la compréhension du langage multi-modal et HellaSwag.

- Fiabilité et orientabilité : OpenAI a intégré les leçons de leur programme de tests adversaires et de ChatGPT, ce qui rend GPT-4 plus précis et mieux aligné sur les entrées des utilisateurs.

Quoi de neuf dans GPT-4 ?

Avant d'approfondir l'ingénierie des prompts, il est essentiel de comprendre ce qui distingue GPT-4 de ses prédécesseurs.

- Apprentissage adversarial : OpenAI a utilisé des tests adversaires pour améliorer la capacité du modèle à générer des informations plus factuelles et fiables.

- Hallucination limitée : Bien qu'il ne soit pas totalement exempt d'erreurs, GPT-4 a tendance à moins halluciner et à commettre moins d'erreurs de raisonnement par rapport aux versions précédentes.

Capacités de vision dans GPT-4

Bien que GPT-4 ne propose pas encore de capacités d'entrée d'image publique, il est conçu pour gérer de telles extensions futures. Pour l'instant, il surpasse GPT-3.5, notamment dans les tâches basées sur du texte, en étant plus fiable et créatif.

- Augmentation texte-image : Même sans une entrée d'image directe, GPT-4 peut fonctionner avec des tâches liées à l'image en utilisant des techniques de prompting de few-shot ou de chaîne de pensée.

Exemple : Vous pouvez féliciter GPT-4 de la manière suivante pour effectuer une analyse étape par étape sur des informations liées à l'image :

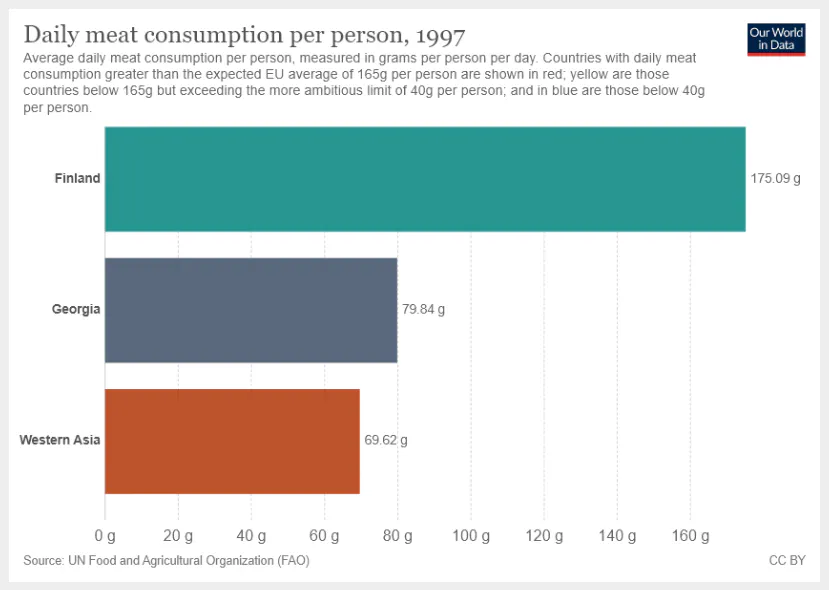

(prompt) "Quelle est la somme de la consommation quotidienne moyenne de viande pour la Géorgie et l'Asie occidentale ? Fournissez un raisonnement étape par étape avant de donner votre réponse."

GPT-4 fournirait alors un calcul détaillé, étape par étape, basé sur l'image ou le graphique auquel vous vous référez.

C'est juste la partie émergée de l'iceberg. La vraie magie opère lorsque vous maîtrisez l'ingénierie des prompts de GPT-4, une compétence que nous explorerons dans les sections suivantes.

Section 2 : Maîtriser l'ingénierie des prompts avec GPT-4

Commencer avec des prompts de base

L'art de l'ingénierie des prompts commence par comprendre comment créer des prompts simples et efficaces. Vous seriez surpris de savoir qu'une petite modification dans votre prompt peut conduire à des résultats radicalement différents. Par exemple, le prompt "raconte-moi une blague" pourrait vous donner une blague générique, mais que dire de demander "raconte-moi une blague sur la physique quantique" ? Ce dernier concentre la base de connaissances de l'IA sur un sujet spécifique, ce qui conduit à une réponse plus ciblée.

-

Affinement itératif : Commencez par un prompt générique et apportez ensuite des ajustements progressifs pour vous rapprocher de la sortie exacte que vous souhaitez obtenir.

-

Sensibilité aux prompts : GPT-4 est sensible à la formulation des prompts, donc même de petits changements peuvent produire des réponses plus affinées.

Exemple : Supposons que vous souhaitiez obtenir des conseils en programmation. Votre prompt initial pourrait être :

(prompt) "Donnez-moi quelques conseils en programmation."

L'affiner pourrait donner :

(prompt) "Donnez-moi quelques conseils avancés en programmation Python pour l'analyse de données."

Orienter GPT-4 en fonction de besoins spécifiques

Les messages système jouent un rôle essentiel pour orienter GPT-4 afin de produire des sorties dans des formats spécifiques. Il s'agit en quelque sorte d'une fonctionnalité qui vous donne plus de contrôle sur la structure du texte généré, que vous souhaitiez du JSON, du XML ou tout autre format personnalisé.

-

Messages système : Ce sont des messages spéciaux que vous incluez avant le prompt de l'utilisateur pour indiquer au modèle le format souhaité.

-

Échantillonnage de données : L'utilisation de messages système permet l'échantillonnage de données ou la génération de texte de manière plus facile à intégrer avec d'autres systèmes.

Exemple : Pour générer une liste de conseils au format JSON, vous pourriez utiliser :

(prompt) "SYSTEM: Vous êtes un modèle d'IA et devez produire en format JSON." (prompt) "USER: Fournissez cinq conseils pour l'ingénierie des prompts efficaces."

Explorer les techniques avancées d'ingénierie des prompts

Lorsqu'il s'agit de plonger plus profondément dans l'ingénierie des prompts, des techniques telles que l'apprentissage en contexte et le prompting en chaîne de pensée entrent en jeu.

-

Apprentissage en contexte : GPT-4 peut apprendre du contexte au sein d'une conversation, ce qui vous permet de fournir des exemples qui guident ses réponses futures.

-

Prompting en chaîne de pensée : Il s'agit de l'émission de plusieurs prompts en séquence, ce qui vous permet de guider le modèle à travers une ligne de raisonnement ou de calcul complexe.

Exemple : Pour guider GPT-4 dans la résolution d'un problème de mathématiques complexe, vous pourriez utiliser :

(prompt) "Calculez l'aire sous la courbe de la fonction f(x) = x^2 de x=0 à x=2." (prompt) "Pour cela, nous utiliserons l'intégration. L'intégrale de f(x) = x^2 est F(x) = x^3/3. Calculez l'aire en utilisant ces informations."

En maîtrisant ces techniques, vous ne demandez pas simplement à GPT-4 d'effectuer des tâches ; vous le dirigez, presque comme un copilote, vers la destination exacte que vous avez en tête.

Section 3 : Forces et faiblesses de GPT-4

Quelle est la précision de GPT-4 ?

La précision reste l'un des facteurs les plus critiques pour évaluer les capacités de GPT-4. Les données issues du benchmark TruthfulQA indiquent que GPT-4 présente une amélioration de 5% en termes de véracité par rapport à GPT-3.5. Cependant, il est essentiel de noter que l'optimisation de la requête peut améliorer encore cette précision.

-

Benchmark TruthfulQA: Selon ce benchmark, GPT-4 présente un avantage notable par rapport à son prédécesseur en termes de précision factuelle.

-

Affinement de la requête: Des requêtes correctement optimisées peuvent atténuer les problèmes de réponses incorrectes ou incomplètes.

Exemple: Pour évaluer la précision du modèle, vous pourriez utiliser une requête comme :

(prompt) "Fournissez des informations factuelles sur le point d'ébullition de l'eau à différentes pressions atmosphériques."

Rendre GPT-4 plus fiable

La fiabilité de GPT-4 peut être améliorée grâce à des expérimentations rigoureuses et à une utilisation créative de différentes techniques d'optimisation de requêtes.

-

Stratégies d'expérimentation: Cela implique l'utilisation d'un mélange de requêtes de type few-shot, zero-shot et de type chaîne de pensée pour comprendre comment chacune se comporte dans différentes conditions.

-

Combinaison de techniques: Différentes techniques peuvent être combinées de manière synergique pour des résultats encore plus précis et fiables.

Conclusion

Le paysage de l'IA et des modèles linguistiques a été profondément transformé avec l'avènement de GPT-4. Grâce à des techniques telles que l'optimisation de requêtes, nous pouvons désormais adapter GPT-4 à une variété de tâches spécialisées, ce qui en fait non seulement un couteau suisse, mais aussi un expert dans de nombreux domaines. Que ce soit pour réussir des benchmarks professionnels, orienter le modèle pour des sorties personnalisées ou se préparer à ses capacités futures en vision, GPT-4 représente une réalisation monumentale dans le domaine de l'IA.

Qu'est-ce que l'optimisation de requêtes dans GPT ?

L'optimisation de requêtes est le processus de création de requêtes ou d'énoncés efficaces afin de guider la sortie d'un modèle GPT pour répondre à des besoins ou critères spécifiques.

Quelles sont les techniques d'optimisation de requêtes dans GPT-4 ?

Les techniques d'optimisation de requêtes dans GPT-4 incluent l'optimisation de base, la conduite par message système, l'apprentissage en contexte et l'optimisation en chaîne de pensée.

Comment optimiser GPT-4 avec une requête ?

Pour optimiser GPT-4, vous entrez une requête ou un énoncé texte et vous recevez une sortie texte. Vous pouvez affiner la requête de manière itérative et utiliser des messages système pour des sorties plus spécialisées.

Comment utiliser ChatGPT pour l'optimisation de requêtes ?

On peut utiliser ChatGPT pour les tâches d'optimisation en utilisant des requêtes spécialisées et des messages système pour générer des extraits de code, des ensembles de données et plus encore.