Chain of Thought Prompting: LLMのパワーを例で解き放つ

Published on

Chain of Thought Prompting(CoT)に関する包括的なガイドへようこそ!大規模言語モデルの推論能力を向上させる方法について疑問に思ったことがあれば、正しい場所に来ました。この技術は、機械学習と自然言語処理の分野でゲームチェンジャーとなっています。

この記事では、Chain of Thought Promptingが何であり、どのように機能し、その様々な利点と現実世界での応用について深く掘り下げます。また、Langchain、ChatGPT、Pythonなどのさまざまなコンテキストでこの技術がどのように適用されるかも探求します。さあ、始めましょう!

Chain of Thought Promptingとは?

Chain of Thought Promptingは、大型言語モデル(LLM)が論理的に順序立てて思考することを促す技術です。従来のプロンプティング方法とは異なり、CoTではモデルが各段階でその推論を評価し、エラーが発生した場合に代替方法に切り替えることができます。これにより、より正確かつ信頼性の高い出力が得られます。

どのように機能するのか?

核心となるアイデアは、LLMに思考プロセスを導く一連のプロンプトを提供することです。各プロンプトは「思考ノード」として機能し、モデルは次に進む前に各ノードの出力を評価する必要があります。これにより、モデルは迷路に迷い込んだ場合に自己修正することができます。

Chain of Thought Promptingの実装は、言語モデルに対するロードマップの作成に似ています。以下に手順を示します。

- 問題の特定: 解決してもらいたい多段階の問題を明確に定義します。

- 問題の分解: 問題をより小さなタスクや質問に分解して最終的な解決策に導きます。

- プロンプトの作成: 各小さなタスクに対して、言語モデルを導くプロンプトを作成します。

- 実行: これらのプロンプトを順番に言語モデルにフィードし、各ステップでの出力を収集します。

- 分析と改善: 出力を評価し、必要に応じてプロンプトを改善します。

例: 車の旅行の平均速度を計算する数学のワード問題を解決したいとします。モデルに直接解決を求める代わりに、以下の手順に分解することができます。

- 総走行距離を計算する。

- 総所要時間を計算する。

- 式

平均速度 = 合計距離 / 合計時間を使って平均速度を計算する。

Chain of Thought Promptingの利点

推論と問題解決の向上

Chain of Thought Promptingの最も魅力的な利点の1つは、大型言語モデルの推論能力を大幅に向上させることができる点です。従来の言語モデルは、多段階や複雑な推論タスクに直面すると頓挫することが多いですが、CoTは効果的にこの壁を取り除くことができます。

- 正確性: 問題をより小さなタスクに分解することで、モデルは各ステップに集中することができ、より正確な結果を得ることができます。

- 複雑なタスク: 数学の問題を解くことや複雑なシナリオを理解することなど、CoTは言語モデルが効率的にこれらのタスクを処理する能力を持たせます。

ChatGPTでのChain of Thought Prompting

Chain of Thought Promptingの例

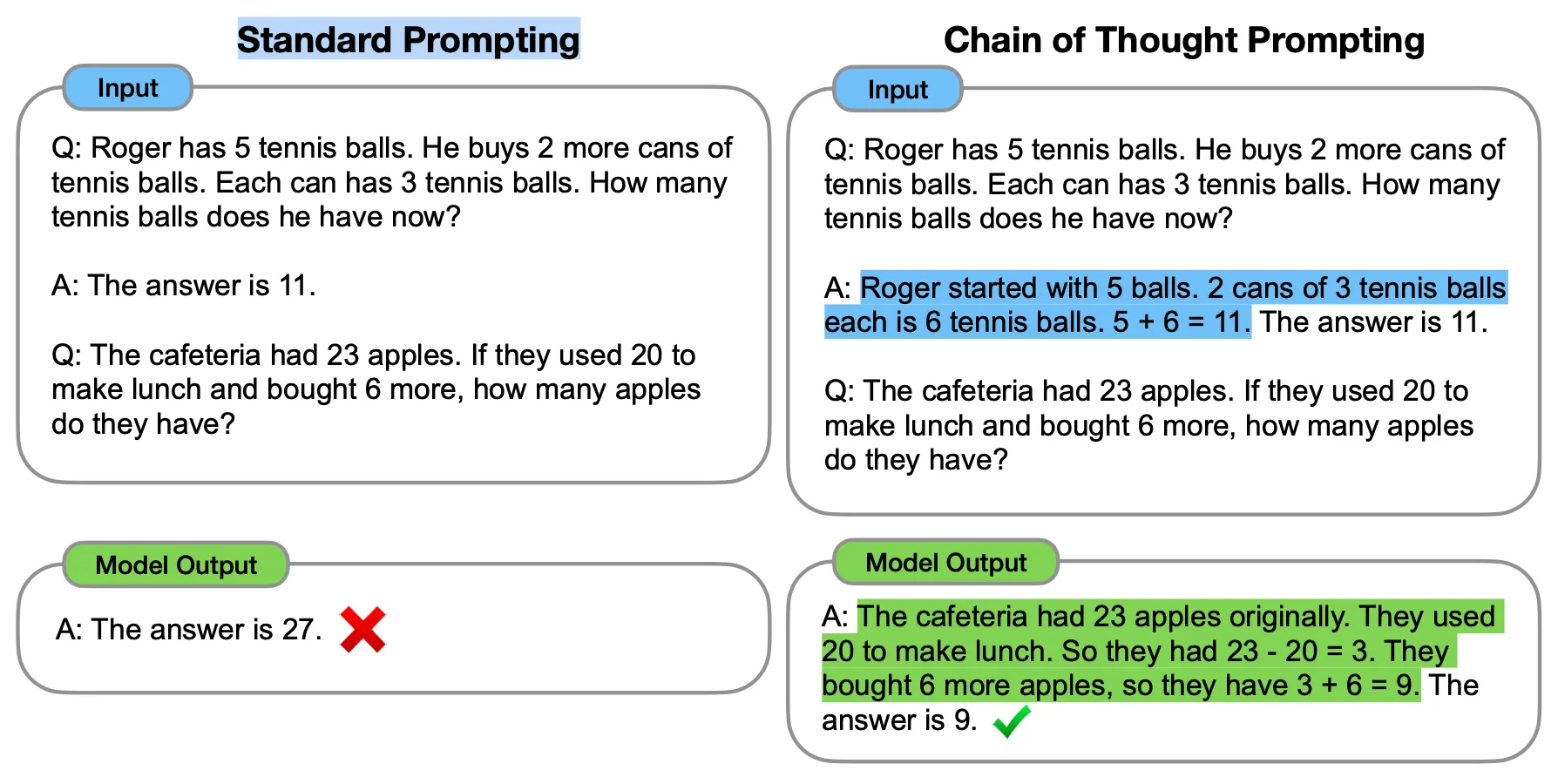

Chain of Thought Prompting(CoT)は、ChatGPTなどの大型言語モデル(LLM)が推論時により明確な表現力を持つようにするための先進的な技術です。従来のプロンプティング方法とは異なり、CoTは「フューショットの例証」と呼ばれる一連のプロンプトを使用して、モデルを論理的な手順の系列に導くことができます。これにより、より正確で信頼性の高い出力が得られます。

CoTの主なアイデアは、これらのフューショットの例証を使用して推論プロセスを明示的に表示することです。このようなプロンプトでモデルを促すと、推論ステップも明らかになり、より正確で深い回答が得られます。

Chain of Thought Promptingのベンチマーク

たとえば、GPT-3(davinci-003)は、シンプルなワード問題を使ってテストされました。従来のプロンプティングを使用した場合、問題を解決することができませんでした。しかし、CoTプロンプティングが適用された場合、モデルは同じ問題を正常に解決できます。これは、CoTがモデルの問題解決能力を向上させる効果を示しています。

CoTは、算術、常識的な推論、記号的推論など、さまざまなタスクでLLMのパフォーマンスを劇的に向上させることが証明されています。具体的には、CoTでプロンプティングされたモデルは、当時最高と考えられていたGSM8Kベンチマークで57%の解決率の正確性を達成しました。

!Chain of Thought Prompting Benchmarks](https://raw.githubusercontent.com/lynn-mikami/Images/main/chain-of-thought-prompting-chatgpt-3.webp (opens in a new tab))

CoTは、特に約1000億パラメータを持つ大きなモデルで使用する場合に最も効果的です。小さいモデルでは、論理的でない思考の連鎖が生成されることが多く、正確性に悪影響を与えることがあります。したがって、CoTによるパフォーマンスの向上は、一般的にモデルのサイズに比例します。

LangChainにおける思考の連鎖プロンプト

LangChainがPythonでCoTを使用する方法は次の通りです:

from langchain.chains import SequentialChain

# チェーンを定義する

chain1 = ...

chain2 = ...

chain3 = ...

chain4 = ...

# チェーンを接続する

overall_chain = SequentialChain(chains=[chain1, chain2, chain3, chain4], input_variables=["input", "perfect_factors"], output_variables=["ranked_solutions"], verbose=True)

# 全体のチェーンを実行する

print(overall_chain({"input": "火星の人類植民", "perfect_factors": "地球と火星の距離が非常に遠く、定期的な補給が難しい"}))このコードスニペットは、LangChainがSequentialChainクラスを使用して複数のチェーンを接続する方法を示しています。1つのチェーンの出力が次のチェーンの入力になり、複雑な思考の連鎖を可能にします。

結論

主なポイントの要約

私たちは、「Chain of Thought Prompting(CoT)」という興味深い方法を探求しました。これはChatGPTやLangchainなどの大規模言語モデル(LLM)の動作を革新する技術です。従来のプロンプティング手法とは異なり、CoTはモデルを論理的な手順の連続に沿ってガイドし、その推論と問題解決能力を向上させます。これにより、複雑な推論を必要とするタスクにおいて、より正確で信頼性の高い出力が得られます。

CoTがゲームチェンジャーである理由

CoTは単なる新しい技術にとどまらず、機械学習と自然言語処理の分野においてゲームチェンジャーです。CoTによってモデルの推論がより明確になることで、複雑な問題解決と論理的推論を必要とするアプリケーションに新たな可能性が開かれます。算術の課題、常識的な推論、または象徴的な推論であっても、CoTはパフォーマンス指標を大幅に向上させることが実証されています。

FAQs

LangchainのChain of Thought Promptingとは何ですか?

Langchainでは、Chain of Thought PromptingはLLMとヒューリスティック検索を組み合わせたToT(Tree of Thoughts)アルゴリズムを介して実装されています。これにより、より複雑な言語タスクを処理するプラットフォームが可能になります。

Chain of Thought戦略とは何ですか?

Chain of Thought戦略は、モデルの推論プロセスを論理的なステップや「思考ノード」の連続にガイドする手法です。各ノードは、モデルが次に進む前に評価するプロンプトとして機能し、迷路に入った場合に自己修正が可能になります。

Chain of Thoughtsの例は何ですか?

Chain of Thoughtsの例として、複雑な数学の問題を小さなタスクに分解してステップバイステップで解決することが考えられます。たとえば、台形の面積を求める問題の場合、Chain of Thoughtsには両平行辺の平均を計算し、次に高さを求め、最後にそれらを掛けて面積を求める手順が含まれるかもしれません。