Prompt de Cadeia de Pensamento: Desbloqueie o Poder de LLMs com Exemplos

Published on

Bem-vindo a este guia completo sobre o Prompt de Cadeia de Pensamento! Se você já se perguntou como aprimorar as capacidades de raciocínio de grandes modelos de linguagem, você está no lugar certo. Essa técnica está revolucionando o campo da aprendizagem de máquina e do processamento de linguagem natural.

Neste artigo, vamos mergulhar fundo no que é o Prompt de Cadeia de Pensamento, como ele funciona, seus inúmeros benefícios e suas aplicações práticas. Também exploraremos como essa técnica é aplicada em vários contextos, como Langchain, ChatGPT e Python. Então, vamos começar!

O que é Prompt de Cadeia de Pensamento?

O Prompt de Cadeia de Pensamento é uma técnica que incentiva os Modelos de Linguagem de Grande Porte (LLMs) a pensar logicamente e sequencialmente. Ao contrário dos métodos tradicionais de promoção, o CoT faz com que o modelo avalie seu raciocínio em cada etapa, permitindo que ele mude para métodos alternativos se ocorrer um erro. Isso resulta em saídas mais precisas e confiáveis.

Como Funciona?

A ideia principal é fornecer ao LLM uma série de prompts que orientem seu processo de pensamento. Cada prompt serve como um "nó de pensamento" e o modelo precisa avaliar a saída de cada nó antes de passar para o próximo. Dessa forma, o modelo pode se corrigir se sair do caminho correto.

Implementar o Prompt de Cadeia de Pensamento é como construir um mapa para o seu modelo de linguagem. Veja como fazer:

- Identificar o Problema: Defina claramente o problema de várias etapas que deseja que o modelo de linguagem resolva.

- Dividir em Etapas: Decomponha o problema em tarefas ou perguntas menores que levem à solução final.

- Criar Prompts: Para cada tarefa menor, crie um prompt que oriente o modelo de linguagem.

- Executar: Alimente esses prompts para o modelo de linguagem em sequência, coletando as saídas em cada etapa.

- Analisar e Refinar: Avalie as saídas e refine os prompts, se necessário.

Exemplo: Digamos que você queira resolver um problema matemático de cálculo de velocidade média de um carro em uma viagem. Em vez de pedir ao modelo para resolvê-lo diretamente, você pode dividi-lo em etapas:

- Calcular a distância total percorrida.

- Calcular o tempo total gasto.

- Calcular a velocidade média usando a fórmula:

Velocidade Média = Distância Total / Tempo Total

Benefícios do uso do Prompt de Cadeia de Pensamento

Raciocínio e Resolução de Problemas Aprimorados

Uma das vantagens mais convincentes do Prompt de Cadeia de Pensamento é sua capacidade de melhorar significativamente as habilidades de raciocínio de grandes modelos de linguagem. Modelos de linguagem tradicionais muitas vezes encontram dificuldades em tarefas de raciocínio de várias etapas ou complexas. O CoT destrói efetivamente essa dificuldade.

- Precisão: Ao dividir um problema em tarefas menores, o modelo pode focar em cada etapa, resultando em resultados mais precisos.

- Tarefas Complexas: Seja resolver problemas matemáticos ou interpretar cenários complexos, o CoT capacita os modelos de linguagem a lidar com eles de forma eficiente.

Prompt de Cadeia de Pensamento no ChatGPT

Exemplos de Prompt de Cadeia de Pensamento

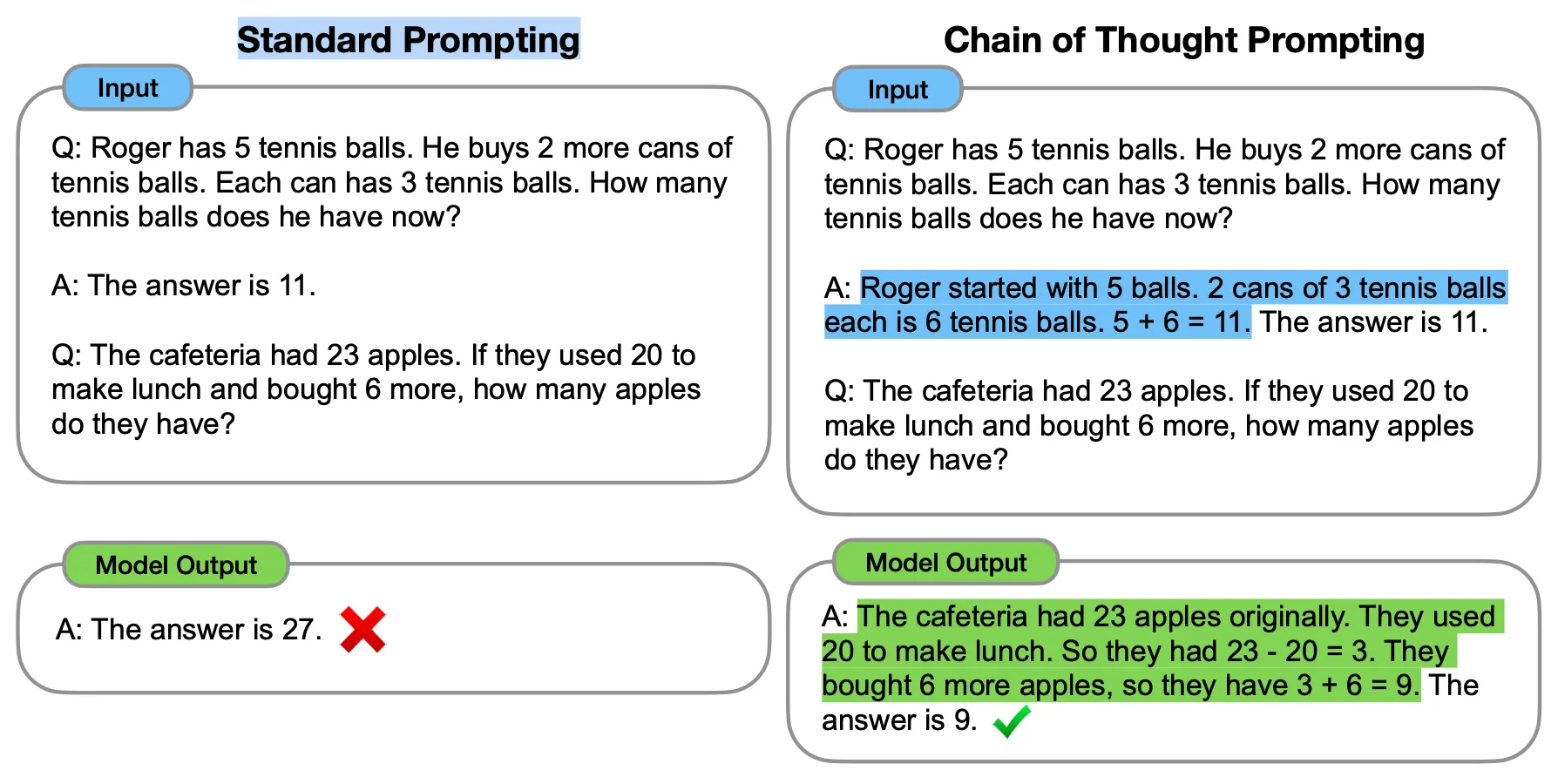

O Prompt de Cadeia de Pensamento, ou CoT, é uma técnica de ponta projetada para tornar os Modelos de Linguagem de Grande Porte (LLMs), como o ChatGPT, mais articulados em seu raciocínio. Ao contrário dos métodos tradicionais de promoção, o CoT usa uma série de "exemplos de poucas amostras" que orientam o modelo por meio de uma sequência lógica de etapas. Isso resulta em saídas mais precisas e confiáveis.

A ideia principal por trás do CoT é usar esses exemplos de poucas amostras para mostrar explicitamente o processo de raciocínio. Quando o modelo é solicitado dessa maneira, ele também revela seus passos de raciocínio, levando a respostas mais precisas e esclarecedoras.

Benchmarks do Prompt de Cadeia de Pensamento

Por exemplo, o GPT-3 (davinci-003) foi testado com um problema simples de palavras. Inicialmente, usando a promoção tradicional, ele não conseguiu resolver o problema. No entanto, quando o prompt CoT foi aplicado, o modelo conseguiu resolver o mesmo problema com sucesso. Isso demonstra a eficácia do CoT em aprimorar as habilidades do modelo na resolução de problemas.

O CoT tem se mostrado altamente eficaz em aprimorar o desempenho de LLMs em várias tarefas, incluindo aritmética, raciocínio do senso comum e raciocínio simbólico. Especificamente, os modelos solicitados com o CoT alcançaram uma taxa de precisão de resolução de 57% no benchmark GSM8K, que era considerado o melhor na época.

Vale ressaltar que o CoT é mais eficaz quando usado com modelos maiores, especificamente aqueles com cerca de 100 bilhões de parâmetros. Modelos menores tendem a produzir cadeias de pensamento ilógicas, o que pode afetar negativamente a precisão. Portanto, os ganhos de desempenho do CoT geralmente são proporcionais ao tamanho do modelo.

Prompt de Cadeia de Pensamento no LangChain

Veja como o LangChain usa o CoT em Python:

from langchain.chains import SequentialChain

# Definir as cadeias

chain1 = ...

chain2 = ...

chain3 = ...

chain4 = ...

# Conectar as cadeias

overall_chain = SequentialChain(chains=[chain1, chain2, chain3, chain4], input_variables=["input", "perfect_factors"], output_variables=["ranked_solutions"], verbose=True)

# Executar a cadeia geralprint(overall_chain({"input": "colonização humana em Marte", "perfect_factors": "A distância entre a Terra e Marte é muito grande, dificultando a ressuprimento regular"}))Este trecho de código mostra como o Langchain conecta várias correntes usando a classe SequentialChain. A saída de uma corrente se torna a entrada da próxima, permitindo uma cadeia de pensamentos complexa.

Conclusão

Resumo dos pontos-chave

Exploramos o fascinante mundo do Prompting da Cadeia de Pensamentos (CoT), uma técnica que está revolucionando a forma como os Modelos de Linguagem de Grande Porte (LLMs) como o ChatGPT e o Langchain operam. Ao contrário dos métodos tradicionais de prompt, o CoT guia o modelo por uma sequência lógica de passos, aprimorando seu raciocínio e habilidades de resolução de problemas. Isso resulta em saídas mais precisas e confiáveis, especialmente em tarefas que exigem raciocínio complexo.

Por que o CoT é uma mudança de jogo

O CoT é mais do que apenas uma nova técnica; ele é uma mudança de jogo no campo do aprendizado de máquina e processamento de linguagem natural. Ao tornar os modelos mais articulados em seu raciocínio, o CoT abre novas possibilidades para aplicações que requerem resolução de problemas complexos e raciocínio lógico. Seja em tarefas aritméticas, raciocínio de senso comum ou raciocínio simbólico, o CoT provou melhorar significativamente as métricas de desempenho.

Perguntas frequentes

O que é o prompting da cadeia de pensamentos no Langchain?

No Langchain, o Prompting da Cadeia de Pensamentos é implementado por meio de um algoritmo de Árvore de Pensamentos (ToT) que combina LLMs e busca heurística. Isso permite que a plataforma lide com tarefas de linguagem mais complexas, guiando o modelo por uma série de etapas lógicas.

Qual é a estratégia da cadeia de pensamentos?

A estratégia da cadeia de pensamentos é um método de guiar o processo de raciocínio de um modelo por uma série de etapas lógicas ou "nós de pensamento". Cada nó serve como um prompt que o modelo deve avaliar antes de avançar para o próximo, permitindo que ele se corrija caso se desvie.

Qual é um exemplo de uma cadeia de pensamentos?

Um exemplo de uma cadeia de pensamentos seria decompor um problema matemático complexo em tarefas menores e resolvê-las passo a passo. Por exemplo, se o problema for encontrar a área de um trapézio, a cadeia de pensamentos pode incluir calcular a média dos dois lados paralelos, em seguida, encontrar a altura e, por fim, multiplicá-los para obter a área.