Mistral AI dévoile le modèle révolutionnaire 8x22B Moe : Une nouvelle ère dans l'IA Open-Source

Published on

Introduction à Mistral 8x22B

Dans un développement stupéfiant qui a secoué la communauté de l'IA, Mistral AI vient d'annoncer la sortie de leur modèle 8x22B Moe très attendu. Cette réalisation révolutionnaire marque une étape significative dans le monde de l'intelligence artificielle open-source, car elle promet des performances et des capacités inégalées qui étaient auparavant réservées aux modèles exclusifs.

L'essor de l'IA Open-Source

Le domaine de l'intelligence artificielle connaît une transformation rapide ces dernières années, avec l'émergence de puissants modèles open-source qui ont remis en question la dominance des systèmes exclusifs. Ce changement est motivé par une reconnaissance croissante de l'importance de la collaboration et de la transparence dans le développement des technologies de l'IA, ainsi que par le désir de démocratiser l'accès à ces puissants outils.

Mistral AI est à l'avant-garde de ce mouvement, avec un historique de modèles de pointe qui repoussent régulièrement les limites de ce qui est possible avec l'IA open-source. Leurs précédentes publications, telles que le modèle très acclamé Mixtral 8x7b, ont été largement saluées par les chercheurs et les développeurs, et ont préparé le terrain pour des percées encore plus importantes à l'avenir.

Le modèle 8x22B Moe : Un bond en avant quantique

Le modèle 8x22B Moe représente un bond en avant quantique dans les capacités de l'IA open-source. Avec un nombre stupéfiant de 130 milliards de paramètres et environ 44 milliards de paramètres actifs par passage en avant, ce modèle est vraiment à part. Pour mettre les choses en perspective, le modèle 8x22B Moe est plus de deux fois plus grand que le plus grand modèle open-source précédemment disponible, et rivalise avec les performances de certains des modèles exclusifs les plus avancés qui existent.

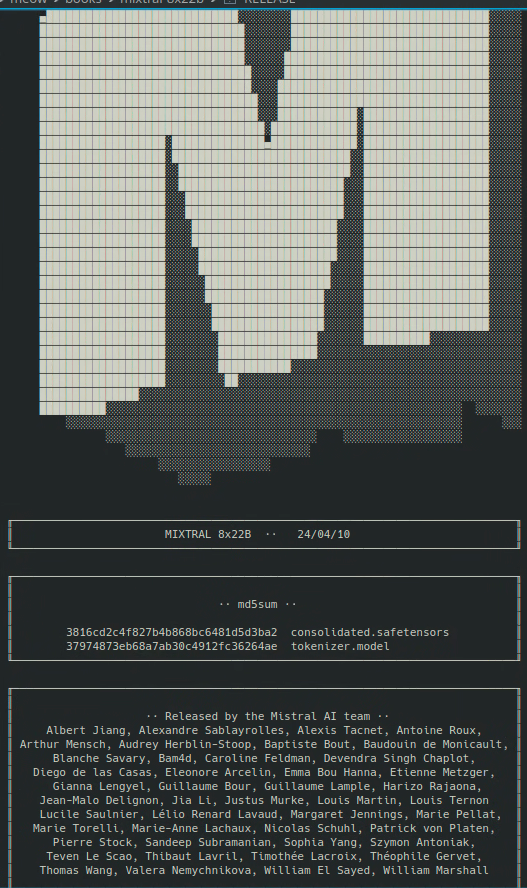

Téléchargez le lien magnétique Mistral 8x22b ici :

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce (opens in a new tab)

Caractéristiques et capacités clés

Alors, qu'est-ce qui distingue exactement le modèle 8x22B Moe de ses prédécesseurs ? Voici quelques-unes des caractéristiques et capacités clés qui rendent cette version si passionnante :

-

Compréhension linguistique inégalée : Le modèle 8x22B Moe a été entraîné sur un corpus énorme de données textuelles, ce qui lui permet de développer une compréhension profonde du langage naturel qui dépasse tout ce que nous avons vu auparavant dans un modèle open-source. Cela signifie que le modèle est capable d'engager des conversations plus nuancées et conscientes du contexte, et peut gérer une gamme plus large de tâches et d'applications que jamais auparavant.

-

Raisonnement et résolution de problèmes améliorés : En plus de ses capacités de compréhension du langage, le modèle 8x22B Moe a également été conçu pour exceller dans les tâches de raisonnement et de résolution de problèmes. Cela signifie qu'il peut relever des défis complexes qui nécessitent une pensée logique et une déduction, comme répondre à des questions basées sur un ensemble de faits donnés ou générer des solutions créatives à des problèmes ouverts.

-

Efficacité et extensibilité améliorées : Malgré sa taille massive, le modèle 8x22B Moe a été optimisé pour l'efficacité et l'extensibilité grâce à une gamme d'innovations techniques développées par l'équipe de Mistral AI. Cela signifie que le modèle peut être déployé et exécuté sur une plus large gamme de configurations matérielles que les modèles précédents, le rendant ainsi plus accessible aux chercheurs et aux développeurs du monde entier.

Implications pour l'avenir de l'IA

La sortie du modèle 8x22B Moe n'est pas seulement une réalisation technique, mais aussi une déclaration puissante sur l'avenir de l'intelligence artificielle. En démontrant que les modèles open-source peuvent atteindre ou même dépasser les performances des systèmes propriétaires, Mistral AI contribue à mettre sur un pied d'égalité et à garantir que les avantages de l'IA soient accessibles à tous.

Cela a des implications profondes pour un large éventail de domaines et d'industries, de la santé et l'éducation à la finance et aux transports. Avec le modèle 8x22B Moe et d'autres outils open-source à leur disposition, les chercheurs et les développeurs pourront relever certains des défis les plus urgents auxquels notre monde est confronté aujourd'hui, et créer de nouvelles applications et services qui étaient auparavant inimaginables.

Conclusion

Le lancement du modèle 8x22B Moe par Mistral AI est un moment charnière dans l'histoire de l'intelligence artificielle. En repoussant les limites de ce qui est possible avec l'IA open-source, cette version est destinée à accélérer le rythme de l'innovation et de la découverte dans le domaine, et à débloquer de nouvelles opportunités pour les chercheurs, les développeurs et les entreprises du monde entier.

Alors que nous regardons vers l'avenir, il est clair que l'IA open-source jouera un rôle de plus en plus important dans l'orientation du progrès technologique. Avec des outils comme le modèle 8x22B Moe à notre disposition, nous avons le pouvoir de créer un monde plus intelligent, plus connecté et plus équitable, où les avantages de l'IA sont partagés par tous.

title: Célébrons cette réalisation importante language: fr

Ainsi, célébrons cette réalisation importante et redoublons d'efforts pour construire un avenir dans lequel l'intelligence artificielle serve le bien commun. Ensemble, nous pouvons exploiter la puissance de l'IA open-source pour résoudre les plus grands défis de notre époque et créer un avenir meilleur et plus prometteur pour toute l'humanité.

Vous voulez connaître les dernières actualités LLM ? Consultez le dernier classement LLM !