Guanaco 65B : des chatbots finetunés open source qui défient GPT-4

Published on

Dans le paysage en constante évolution de l'intelligence artificielle, les modèles de génération de texte sont devenus la pierre angulaire de diverses applications, des chatbots à la création de contenu. Guanaco 65B se distingue comme un modèle révolutionnaire qui a suscité beaucoup d'attention pour ses capacités. Mais qu'est-ce qui le rend si spécial ? Dans ce guide complet, nous plongerons dans les détails de Guanaco 65B, explorant ses différentes versions, ses fonctionnalités de compatibilité et même la façon de s'en procurer.

Que vous soyez développeur, scientifique des données ou simplement passionné par l'IA, comprendre Guanaco 65B pourrait être votre prochain grand pas dans le domaine. Que vous souhaitiez générer du texte, analyser des données ou développer une nouvelle application, ce guide vous servira de ressource ultime. Alors, commençons !

Envie de connaître les dernières actualités sur LLM ? Consultez le dernier classement de LLM !

Qu'est-ce que Guanaco 65B et pourquoi devriez-vous vous en soucier ?

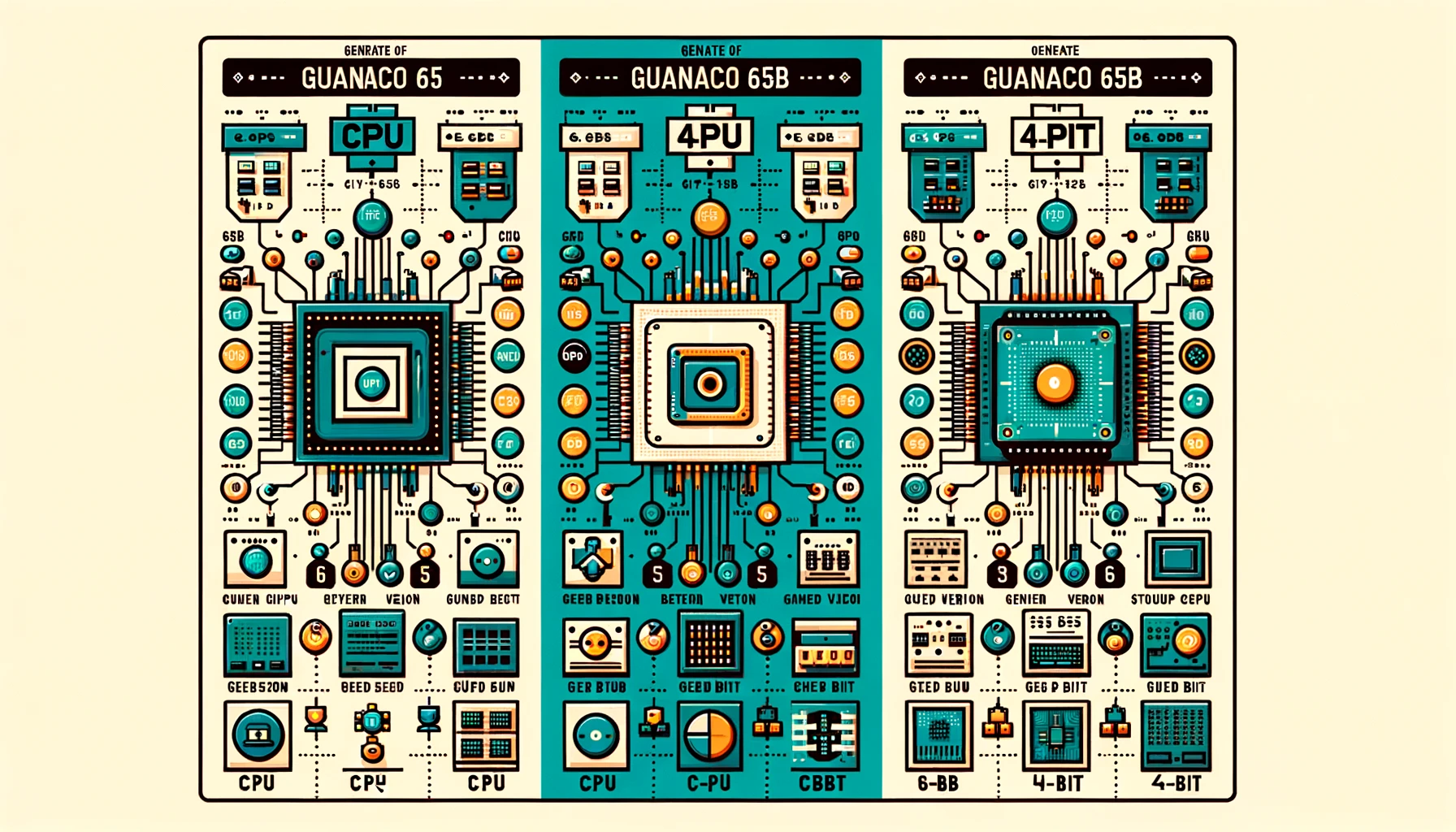

Guanaco 65B est un modèle de langage de pointe conçu pour la génération de texte. Ce n'est pas juste un autre modèle ; c'est un outil flexible et puissant qui existe dans différentes versions pour s'adapter à différentes exigences matérielles. Que vous travailliez avec un CPU ou un GPU haut de gamme, il y a un Guanaco 65B pour vous. Maintenant, examinons ces versions.

Évaluation de Guanaco 65B : Comment se mesure-t-il ?

Lorsqu'il s'agit d'évaluer les performances des modèles de langage comme Guanaco 65B, les évaluations sont cruciales. Elles fournissent une façon normalisée de mesurer divers aspects tels que la vitesse, la précision et les capacités globales. Cependant, les évaluations ne sont pas le seul moyen d'évaluer l'efficacité d'un modèle. Les expériences des utilisateurs et les discussions au sein de la communauté offrent également des perspectives précieuses.

Malheureusement, à l'heure actuelle, Guanaco 65B ne figure sur aucun classement officiel. Cependant, il convient de noter que :

- Finetuning : Guanaco 65B est l'un des rares modèles finetunés disponibles pour l'architecture 65B, ce qui en fait une offre unique.

- Tâches spécialisées : La compatibilité du modèle avec QLoRA suggère qu'il pourrait exceller dans les tâches basées sur des requêtes, bien que cela doive être vérifié empiriquement.

Les avantages de Guanaco 65B

Après avoir utilisé le modèle, voici les avantages de Guanaco 65B :

- Vitesse et efficacité : Certains utilisateurs ont constaté que la version 65B était plus lente, ce qui affecte son utilité pour certaines tâches.

- Jeu de rôle et cohérence du personnage : Les utilisateurs ont remarqué que les modèles Guanaco excellent dans le maintien de la cohérence des personnages, notamment lorsqu'ils sont utilisés avec des cartes de personnage.

- Génération de texte : Les modèles Guanaco sont salués pour leur capacité à générer beaucoup de texte tout en comprenant efficacement les consignes.

Licences Guanaco 65B

Avant de plonger dans le monde de Guanaco 65B, il est essentiel de comprendre les conditions de licence qui accompagnent chaque version. Différentes licences régissent l'utilisation, la modification et la distribution du modèle.

- Licences open source : Certaines versions sont fournies avec des licences open source, permettant une utilisation et une modification gratuites.

- Licences commerciales : D'autres versions peuvent nécessiter une licence commerciale, notamment si vous prévoyez d'utiliser le modèle dans un contexte à but lucratif.

Vous pouvez consulter la page Guanaco 65B sur Huggingface ici (opens in a new tab).

Un guide étape par étape pour utiliser Guanaco 65B

Naviguer dans le monde des modèles de génération de texte peut être intimidant, surtout si vous êtes nouveau dans le domaine. C'est pourquoi nous avons préparé un guide complet et étape par étape pour vous aider à démarrer avec Guanaco 65B.

Étape 1. Télécharger Guanaco 65B

Avant de pouvoir commencer à générer du texte, vous devrez télécharger le modèle Guanaco 65B qui correspond le mieux à vos besoins. Voici comment faire :

- Visitez le dépôt Hugging Face : Allez sur le site web de Hugging Face et recherchez la version de Guanaco 65B que vous souhaitez.

- Sélectionnez le modèle : Cliquez sur le modèle pour accéder à sa page dédiée.

- Copiez le nom du modèle : Vous trouverez le nom du modèle près du haut de la page. Copiez-le pour une utilisation ultérieure.

Étape 2. Génération de texte avec Guanaco 65B

Une fois que vous avez téléchargé le modèle, il est temps d'écrire du code. Voici un extrait de code Python qui montre comment générer du texte en utilisant Guanaco 65B.

from transformers import AutoTokenizer, AutoModelForCausalLM

# Initialisez le tokenizer et le modèle

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# Préparez l'entrée de texte

input_text = "Raconte-moi une blague."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# Générez du texte

output = model.generate(input_ids)

# Décodez et affichez le texte généré

print(tokenizer.decode(output[0], skip_special_tokens=True))Pour exécuter ce code, assurez-vous d'avoir installé la bibliothèque transformers. Sinon, vous pouvez l'installer avec pip :

pip install transformersEt voilà, une façon simple mais efficace de générer du texte avec Guanaco 65B. Que vous construisiez un chatbot, un générateur de contenu ou toute autre application textuelle, ce modèle vous couvre.

Étape 3. Utilisation de Guanaco 65B avec Google Colab

Pour ceux qui préfèrent une approche plus pratique, Guanaco 65B peut être facilement utilisé dans les cahiers Google Colab. Cela vous permet d'expérimenter le modèle sans aucun tracas de configuration.

- Facilité d'utilisation : Importez simplement le modèle dans un cahier Colab et commencez à l'utiliser.

- Collaboration: Les fonctionnalités de partage de Colab facilitent la collaboration sur des projets.

Voici un court extrait de code pour utiliser Guanaco 65B dans Google Colab :

# Exemple de code pour utiliser Guanaco 65B dans Google Colab

# Assurez-vous d'installer d'abord la bibliothèque transformers

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "Qu'est-ce que l'IA ?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Différentes versions de Guanaco 65B

Utilisation de la version 4 bits de Guanaco 65B

Lorsqu'il s'agit d'optimiser à la fois les performances et la mémoire, la version Guanaco 65B-GPTQ 4 bits est révolutionnaire. Cette variante est conçue pour fonctionner sur les GPU, mais avec une particularité : elle utilise la quantification pour réduire la taille du modèle sans compromettre significativement ses performances.

Fonctionnalités :

- Empreinte mémoire réduite : La quantification 4 bits réduit considérablement les besoins en VRAM.

- Multiples paramètres de quantification : Permet la personnalisation en fonction de vos besoins spécifiques.

- Performances proches de l'original : Malgré la taille réduite, le modèle conserve un haut niveau de précision.

Qui devrait l'utiliser ?

- Les chercheurs se concentrant sur l'apprentissage automatique efficace

- Les développeurs disposant de ressources GPU limitées

- Tous ceux qui s'intéressent à l'informatique embarquée

Voici un exemple de code pour utiliser Guanaco 65B-GPTQ :

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "Quel temps fait-il ?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))En choisissant la bonne version de Guanaco 65B, vous pouvez adapter vos tâches de génération de texte aux capacités de votre matériel. Que ce soit le CPU, le GPU ou la version 4 bits, chacun offre des avantages uniques qui répondent à un large éventail de besoins.

Utiliser Guanaco 65B avec QLoRA

L'une des fonctionnalités phares de Guanaco 65B est sa compatibilité avec QLoRA, un modèle de langage basé sur des requêtes. Cette fonctionnalité vous permet d'effectuer des tâches de génération de texte plus spécifiques et ciblées.

- Tâches basées sur des requêtes : Idéal pour les moteurs de recherche ou les systèmes de recommandation.

- Précision améliorée : La compatibilité avec QLoRA garantit une génération de texte plus précise et pertinente.

Voici un exemple de code pour utiliser Guanaco 65B avec QLoRA :

# Exemple de code pour utiliser Guanaco 65B avec QLoRA

# Remarque : Il s'agit d'un exemple hypothétique ; l'implémentation réelle peut varier.

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "Quelle est la capitale de la France ?"

response = qlora_model.generate(query)

print(response)Conclusion : Pourquoi Guanaco 65B est une révolution

En concluant ce guide complet, il est clair que Guanaco 65B n'est pas juste un modèle de génération de texte parmi tant d'autres. C'est un outil polyvalent, puissant et hautement personnalisable qui répond à un large éventail d'applications et de configurations matérielles. De ses différentes versions à sa compatibilité avec les modèles basés sur des requêtes comme QLoRA, Guanaco 65B est vraiment une révolution dans le domaine de la génération de texte.

Que vous soyez un développeur chevronné ou un passionné curieux, ce modèle offre quelque chose pour tout le monde. Alors pourquoi attendre ? Plongez dans le monde de Guanaco 65B et débloquez l'avenir de la génération de texte dès aujourd'hui !

Vous voulez connaître les dernières actualités sur LLM ? Consultez le dernier classement LLM !