QA-LoRA : Un guide pour affiner efficacement les modèles de langage de grande taille

Published on

Bienvenue dans l'univers fascinant des modèles de langage de grande taille (LLM) ! Ces géants informatiques sont le fondement de nombreuses applications, des chatbots et traducteurs aux générateurs de contenu et systèmes de recommandation. Cependant, aussi merveilleux qu'ils soient, les déployer n'est pas une mince affaire. Les exigences informatiques et de mémoire peuvent être énormes, nécessitant souvent un matériel spécialisé et beaucoup de patience.

C'est là que QA-LoRA entre en jeu. Cette méthode révolutionnaire change la donne, rendant l'affinage et le déploiement des LLM plus faciles et plus efficaces. Donc, si vous avez du mal avec la charge informatique des LLM ou si vous cherchez un moyen plus intelligent de les affiner, vous êtes au bon endroit.

Pourquoi QA-LoRA est une révolution pour les LLM

Vous voulez vous tenir au courant des dernières nouvelles sur les LLM ? Consultez le dernier classement des LLM !

En quoi consiste exactement QA-LoRA et en quoi diffère-t-il de LoRA ?

Avant d'entrer dans les détails, définissons notre sujet. QA-LoRA signifie Quantization-Aware Low-Rank Adaptation. En termes simples, c'est une méthode conçue pour rendre l'affinage des modèles de langage de grande taille plus efficace. Vous vous demandez peut-être alors ce qu'est LoRA ? LoRA est l'acronyme de Low-Rank Adaptation, une technique visant à réduire la complexité d'un modèle tout en conservant ses performances. Ce qui distingue QA-LoRA, c'est son aspect de prise en compte de la quantification.

- Quantification : il s'agit du processus de limitation des valeurs possibles qu'une fonction peut prendre. Dans le contexte des LLM, cela contribue à réduire la taille du modèle.

- Adaptation à faible rang : cela consiste à approximer les données originales de grande dimension par une forme de dimension inférieure, rendant le modèle moins coûteux en termes de calcul.

Ainsi, lorsque vous combinez ces deux aspects - la quantification et l'adaptation à faible rang - vous obtenez QA-LoRA, une méthode qui réduit non seulement la taille du modèle mais le rend également plus efficace sur le plan informatique. C'est crucial pour déployer des LLM sur des appareils ayant des ressources informatiques limitées.

La méthode LoRA simplifiée

La méthode LoRA consiste essentiellement à approximer les matrices de poids d'origine d'un LLM à l'aide de matrices de rang inférieur. Il s'agit d'une astuce astucieuse permettant de réduire les exigences de calcul sans compromettre les performances. Dans le contexte de QA-LoRA, cette adaptation à faible rang fonctionne de concert avec la quantification pour fournir un modèle encore plus efficace.

- Étape 1 : Commencez par identifier les matrices de poids de votre LLM qui conviennent à une approximation de faible rang.

- Étape 2 : Utilisez des techniques mathématiques telles que la décomposition en valeurs singulières (SVD) pour trouver ces approximations de faible rang.

- Étape 3 : Remplacez les matrices de poids d'origine par ces approximations de faible rang.

- Étape 4 : Appliquez la quantification pour réduire davantage la taille du modèle.

En suivant ces étapes, vous pouvez réduire considérablement la charge de calcul de votre LLM, ce qui facilite et accélère le déploiement.

Équilibrage de la quantification et de l'adaptation dans QA-LoRA

Un des aspects les plus intrigants de QA-LoRA est comment il équilibre les degrés de liberté entre la quantification et l'adaptation. Cet équilibre est crucial car il permet à QA-LoRA d'être à la fois efficace et précis. Une quantification excessive peut entraîner une perte de précision, tandis qu'une adaptation excessive peut rendre le modèle coûteux du point de vue du calcul. QA-LoRA trouve le juste milieu entre ces deux aspects.

- Efficacité : En utilisant la quantification, QA-LoRA réduit la taille du modèle, ce qui le rend plus rapide à charger et à exécuter.

- Précision : Grâce à l'adaptation à faible rang, il conserve les performances du modèle, garantissant que vous n'avez pas à faire de compromis en termes de qualité.

Comme nous pouvons le voir, QA-LoRA offre une approche équilibrée qui en fait une méthode incontournable pour quiconque souhaite affiner et déployer efficacement des modèles de langage de grande taille. Il allie le meilleur des deux mondes - efficacité et précision - ce qui en fait une révolution dans le domaine de l'apprentissage automatique.

Comment commencer avec QA-LoRA

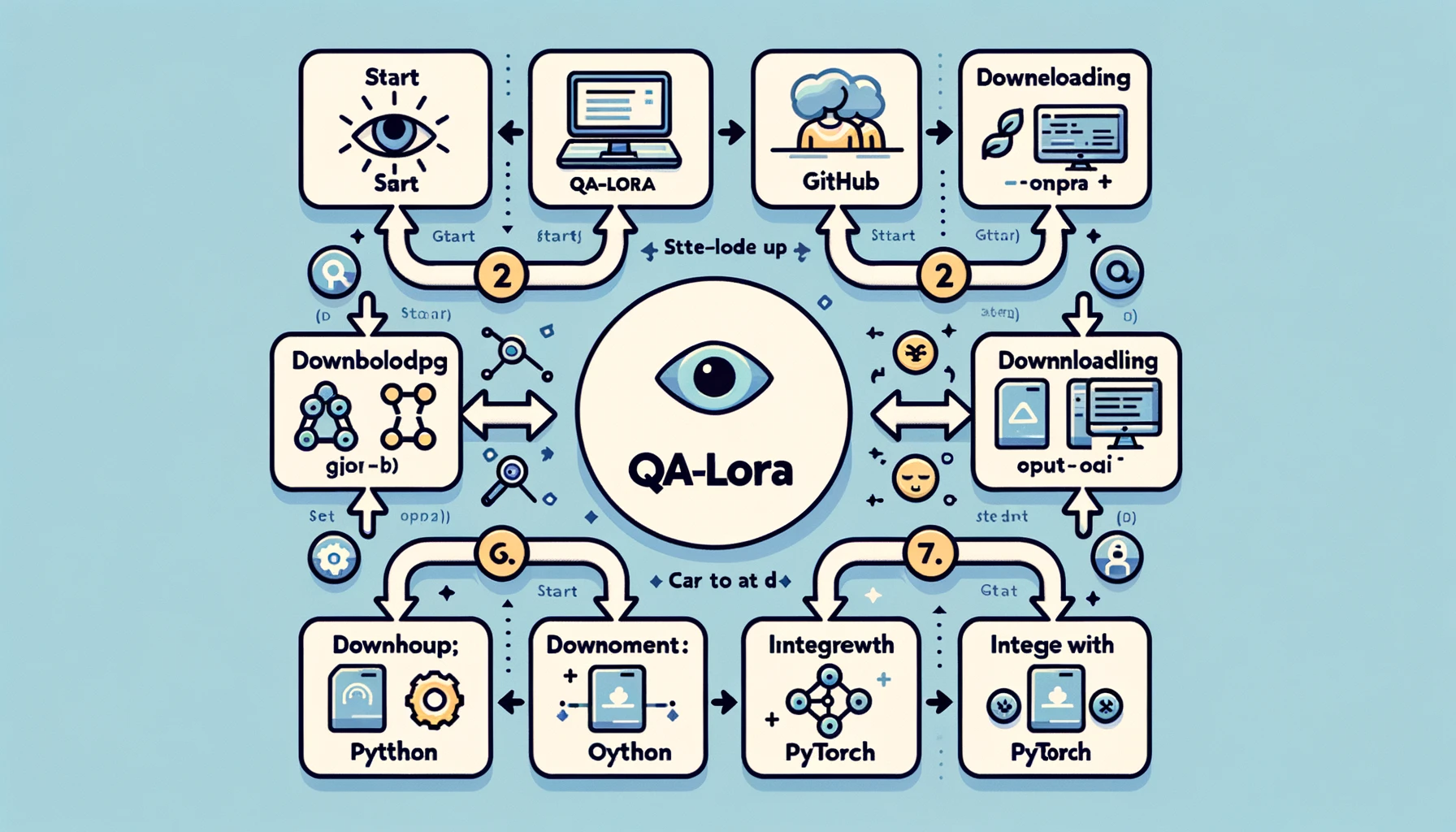

Configuration de votre environnement pour QA-LoRA

Avant de plonger dans le monde de QA-LoRA, vous devrez configurer votre environnement de développement. Il s'agit d'une étape cruciale car la bonne configuration peut rendre votre parcours plus fluide et plus efficace. Voici comment procéder :

- Étape 1 : Installez Python : Si ce n'est pas déjà fait, installez Python sur votre système. Python 3.x est recommandé.

- Étape 2 : Configurez un environnement virtuel : Il est toujours préférable de travailler dans un environnement virtuel pour éviter les conflits de dépendances. Vous pouvez utiliser des outils comme

venvoucondapour cela. - Étape 3 : Installez les bibliothèques requises : Vous aurez besoin de bibliothèques telles que PyTorch, NumPy et d'autres. Utilisez pip ou conda pour les installer.

- Étape 4 : Clonez le référentiel GitHub : Il existe un référentiel GitHub dédié à QA-LoRA. Clonez-le sur votre machine locale pour obtenir le code d'exemple et autres ressources.

En suivant ces étapes, vous disposerez d'un environnement de développement robuste prêt à implémenter QA-LoRA. Cette configuration garantit que vous disposez de tous les outils et bibliothèques nécessaires pour rendre votre implémentation aussi fluide que possible.

Implémentation de QA-LoRA : Guide pas à pas

Maintenant que votre environnement est configuré, passons à la mise en œuvre proprement dite. C'est là que le caoutchouc rencontre la route et vous verrez QA-LoRA en action. Voici un guide étape par étape pour implémenter QA-LoRA :

-

Étape 1 : Importer les bibliothèques : Commencez par importer toutes les bibliothèques nécessaires. Cela inclut généralement PyTorch pour le modèle et NumPy pour les opérations numériques.

import torch import numpy as np -

Étape 2 : Charger votre modèle : Chargez le modèle de langage large que vous souhaitez affiner. Il peut s'agir d'un modèle pré-entraîné ou d'un modèle que vous avez entraîné vous-même.

model = torch.load('votre_modele.pth') -

Étape 3 : Identifier les matrices de poids : Identifiez les matrices de poids dans votre modèle qui conviennent à une approximation de bas rang. Ce sont généralement les couches entièrement connectées.

-

Étape 4 : Appliquer une approximation de bas rang : Utilisez des techniques telles que la décomposition en valeurs singulières (SVD) pour approximer ces matrices de poids.

u, s, v = torch.svd(matrice_de_poids) -

Étape 5 : Remplacer les matrices originales : Remplacez les matrices de poids d'origine par les approximations de bas rang.

matrice_approx = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

Étape 6 : Appliquer la quantification : Enfin, appliquez la quantification pour réduire encore la taille du modèle. Cela peut être fait à l'aide des utilitaires de quantification de PyTorch.

modele_quantifie = torch.quantization.quantize_dynamic(modele)

En suivant ce guide détaillé, vous aurez une implémentation fonctionnelle de QA-LoRA. Cela rendra non seulement votre modèle plus efficace, mais conservera également ses performances, vous offrant le meilleur des deux mondes.

Les prochaines étapes de la recherche sur QA-LoRA

Bien que QA-LoRA soit déjà une méthode révolutionnaire, il est important de noter que la recherche dans ce domaine est loin d'être terminée. Le domaine est propice à l'innovation et il existe plusieurs pistes d'amélioration. Par exemple, la recherche actuelle vise à rendre QA-LoRA encore plus efficace sans compromettre la précision. Cela implique d'affiner l'équilibre entre la quantification et l'adaptation de bas rang, entre autres choses.

- Optimisation de la quantification : Un domaine d'intérêt consiste à optimiser le processus de quantification pour garantir une perte minimale d'informations.

- Approximation de bas rang adaptative : Une autre piste consiste à rendre le processus d'approximation de bas rang adaptatif, permettant au modèle de s'ajuster en fonction de la tâche en cours.

Ces efforts de recherche en cours visent à rendre QA-LoRA encore plus robuste et polyvalent, en veillant à ce qu'il reste la méthode de prédilection pour l'affinage efficace des modèles de langage large.

Vous pouvez en savoir plus sur l'article QA-LoRA ici (opens in a new tab).

En conclusion : Pourquoi QA-LoRA est important

Réflexions finales sur QA-LoRA et son impact

En arrivant à la fin de ce guide complet, il est important de prendre du recul et d'apprécier le pouvoir transformateur de QA-LoRA. Cette méthode n'est pas simplement un jargon technique de plus jeté dans l'océan toujours plus vaste des algorithmes d'apprentissage automatique. C'est une avancée essentielle qui aborde les défis du déploiement des modèles de langage large dans le monde réel.

-

Efficacité : L'un des avantages les plus convaincants de QA-LoRA est son efficacité. En combinant la quantification et l'adaptation de bas rang, il réduit considérablement les exigences de calcul et de mémoire des MLL. C'est un atout pour les développeurs et les organisations qui souhaitent déployer ces modèles à grande échelle ou sur des appareils aux ressources limitées.

-

Précision : QA-LoRA ne compromet pas les performances. Malgré son efficacité, la méthode conserve la précision du modèle, garantissant ainsi des résultats de haute qualité. Cet équilibre entre efficacité et précision distingue QA-LoRA des autres méthodes d'affinage.

-

Polyvalence : La méthode est polyvalente et peut être appliquée à différents types de modèles de langage large. Que vous travailliez sur le traitement du langage naturel, la vision par ordinateur ou tout autre domaine, QA-LoRA peut être adapté à vos besoins.

-

Facilité de mise en œuvre : Avec du code facilement disponible et une communauté de soutien, la mise en œuvre de QA-LoRA est plus facile que jamais. Même si vous n'êtes pas un expert en apprentissage automatique, la méthode est accessible et simple à appliquer.

En résumé, QA-LoRA est plus qu'une simple méthode d'affinage ; c'est un changement de paradigme dans notre approche du déploiement des modèles de langage large. Il offre une solution équilibrée, efficace et efficace pour rapprocher ces géants computationnels des applications pratiques et concrètes. Si vous travaillez dans le domaine de l'apprentissage automatique ou si vous êtes intrigué par le potentiel des modèles de langage large, QA-LoRA est un sujet que vous ne pouvez pas ignorer.

Conclusion

Le monde des modèles de langage large est passionnant mais rempli de défis, en particulier en ce qui concerne le déploiement. QA-LoRA émerge comme un espoir, offrant une méthode équilibrée et efficace pour affiner ces modèles. Des intricacités techniques à sa mise en œuvre pratique, QA-LoRA témoigne de ce qui peut être réalisé lorsque l'efficacité et la précision vont de pair.

Donc, lorsque vous vous lancez dans votre prochain projet impliquant des modèles de langage large, rappelez-vous que QA-LoRA est votre compagnon de confiance pour un affinage efficace et efficace. Essayez-le et rejoignez la révolution qui définit de nouveaux standards dans le monde de l'apprentissage automatique.

Vous voulez connaître les dernières actualités sur les modèles de langage large ? Consultez les derniers LLM leaderboard !