Mistral AI Revela o Revolucionário Modelo 8x22B Moe: Uma Nova Era em IA de Código Aberto

Published on

Introdução ao Mistral 8x22B

Em um desenvolvimento surpreendente que abalou a comunidade de IA, a Mistral AI acaba de anunciar o lançamento do seu altamente aguardado modelo 8x22B Moe. Essa conquista revolucionária marca um marco significativo no mundo da inteligência artificial de código aberto, pois promete fornecer desempenho e capacidades sem precedentes, anteriormente consideradas exclusivas de modelos proprietários.

A Ascensão da IA de Código Aberto

O campo da inteligência artificial passou por uma rápida transformação nos últimos anos, com o surgimento de poderosos modelos de código aberto que desafiaram a dominação dos sistemas proprietários. Essa mudança foi impulsionada pelo reconhecimento crescente da importância da colaboração e transparência no desenvolvimento de tecnologias de IA, bem como pelo desejo de democratizar o acesso a essas ferramentas poderosas.

A Mistral AI tem estado na vanguarda desse movimento, com um histórico de fornecer modelos de ponta que consistentemente ultrapassaram os limites do que é possível com IA de código aberto. Seus lançamentos anteriores, como o altamente aclamado modelo Mixtral 8x7b, receberam elogios generalizados de pesquisadores e desenvolvedores, e prepararam o terreno para avanços ainda maiores no futuro.

O Modelo 8x22B Moe: Um Salto Quântico em Frente

O modelo 8x22B Moe representa um salto quântico nas capacidades da IA de código aberto. Com impressionantes 130 bilhões de parâmetros e cerca de 44 bilhões de parâmetros ativos por passagem para frente, este modelo está verdadeiramente em uma categoria própria. Para colocar isso em perspectiva, o modelo 8x22B Moe é mais do que o dobro do tamanho do maior modelo de código aberto anteriormente disponível e rivaliza com o desempenho de alguns dos modelos proprietários mais avançados existentes.

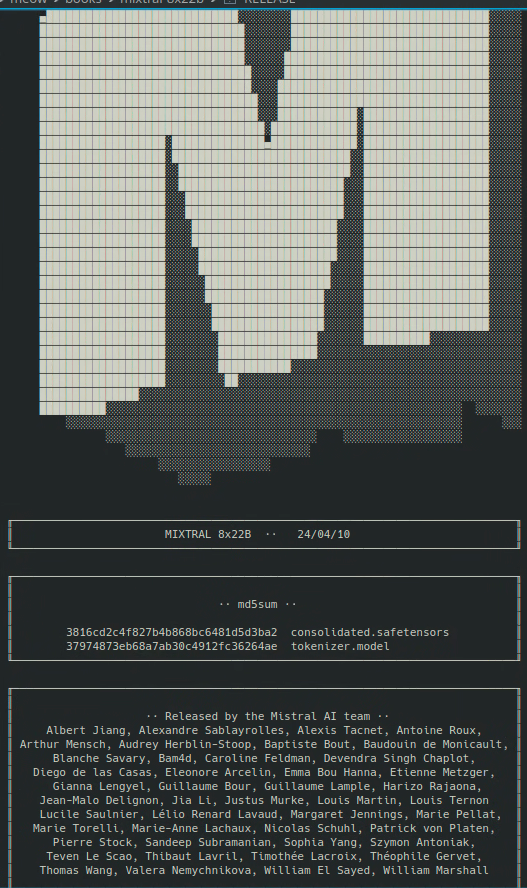

Faça o download do link magnet do Mistral 8x22b aqui:

magnet:?xt=urn:btih:9238b09245d0d8cd915be09927769d5f7584c1c9&dn=mixtral-8x22b&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce (opens in a new tab)

Recursos e Capacidades Principais

Então, o que exatamente diferencia o modelo 8x22B Moe de seus predecessores? Aqui estão apenas algumas das características e capacidades principais que tornam esse lançamento tão empolgante:

-

Compreensão de Linguagem Inigualável: O modelo 8x22B Moe foi treinado em um enorme corpus de dados de texto, o que permite desenvolver uma compreensão profunda da linguagem natural que supera tudo o que já vimos antes em um modelo de código aberto. Isso significa que o modelo é capaz de se envolver em conversas mais sutis e contextuais e lidar com uma gama mais ampla de tarefas e aplicações do que nunca.

-

Raciocínio e Solução de Problemas Aprimorados: Além de suas capacidades de compreensão de linguagem, o modelo 8x22B Moe também foi projetado para se destacar em tarefas de raciocínio e solução de problemas. Isso significa que ele pode enfrentar desafios complexos que requerem pensamento lógico e inferência, como responder perguntas com base em um conjunto de fatos ou gerar soluções criativas para problemas abertos.

-

Eficiência e Escalabilidade Melhoradas: Apesar de seu tamanho massivo, o modelo 8x22B Moe foi otimizado para eficiência e escalabilidade, graças a uma série de inovações técnicas desenvolvidas pela equipe da Mistral AI. Isso significa que o modelo pode ser implantado e executado em uma ampla gama de configurações de hardware do que modelos anteriores, tornando-o mais acessível a pesquisadores e desenvolvedores em todo o mundo.

Implicações para o Futuro da IA

O lançamento do modelo 8x22B Moe não é apenas uma conquista técnica, mas também uma declaração poderosa sobre o futuro da inteligência artificial. Ao demonstrar que modelos de código aberto podem igualar ou até mesmo superar o desempenho de sistemas proprietários, a Mistral AI está ajudando a nivelar o campo de atuação e garantir que os benefícios da IA sejam acessíveis a todos.

Isso tem implicações profundas para uma ampla gama de campos e indústrias, desde cuidados de saúde e educação até finanças e transporte. Com o modelo 8x22B Moe e outras ferramentas de código aberto à disposição, pesquisadores e desenvolvedores serão capazes de enfrentar alguns dos desafios mais urgentes que nosso mundo enfrenta atualmente e criar novas aplicações e serviços que antes eram inimagináveis.

Conclusão

O lançamento do modelo 8x22B Moe pela Mistral AI é um momento histórico na história da inteligência artificial. Ao ultrapassar os limites do que é possível com IA de código aberto, este lançamento está definido para acelerar o ritmo de inovação e descoberta no campo e abrir novas oportunidades para pesquisadores, desenvolvedores e empresas em todo o mundo.

À medida que olhamos para o futuro, fica claro que a IA de código aberto desempenhará um papel cada vez mais importante em moldar o curso do progresso tecnológico. Com ferramentas como o modelo 8x22B Moe à nossa disposição, temos o poder de criar um mundo mais inteligente, mais conectado e mais equitativo - em que os benefícios da IA são compartilhados por todos. Portanto, vamos celebrar esta conquista grandiosa e redobrar nossos esforços para construir um futuro em que a inteligência artificial sirva ao bem maior. Juntos, podemos aproveitar o poder da IA de código aberto para resolver os maiores desafios de nosso tempo e criar um amanhã mais brilhante e esperançoso para toda a humanidade.

Quer aprender as últimas notícias do LLM? Confira a última classificação do LLM!