Guanaco 65B: Chatbots Open Source Treinados que Desafiam o GPT-4

Published on

No cenário sempre em evolução da inteligência artificial, os modelos de geração de texto se tornaram a base de várias aplicações, desde chatbots até criação de conteúdo. Guanaco 65B se destaca como um modelo revolucionário que tem recebido atenção significativa por suas capacidades. Mas o que o torna tão especial? Neste guia abrangente, mergulharemos nos detalhes do Guanaco 65B, explorando suas diferentes versões, recursos de compatibilidade e até mesmo como obtê-lo.

Se você é um desenvolvedor, cientista de dados ou apenas um entusiasta de IA, entender o Guanaco 65B pode ser o seu próximo grande passo no campo. Este guia servirá como seu recurso definitivo, tanto se você estiver procurando gerar texto, analisar dados ou desenvolver um novo aplicativo. Então, vamos começar!

Quer saber as últimas notícias do LLM? Confira a última classificação do LLM!

O que é o Guanaco 65B e por que você deveria se importar?

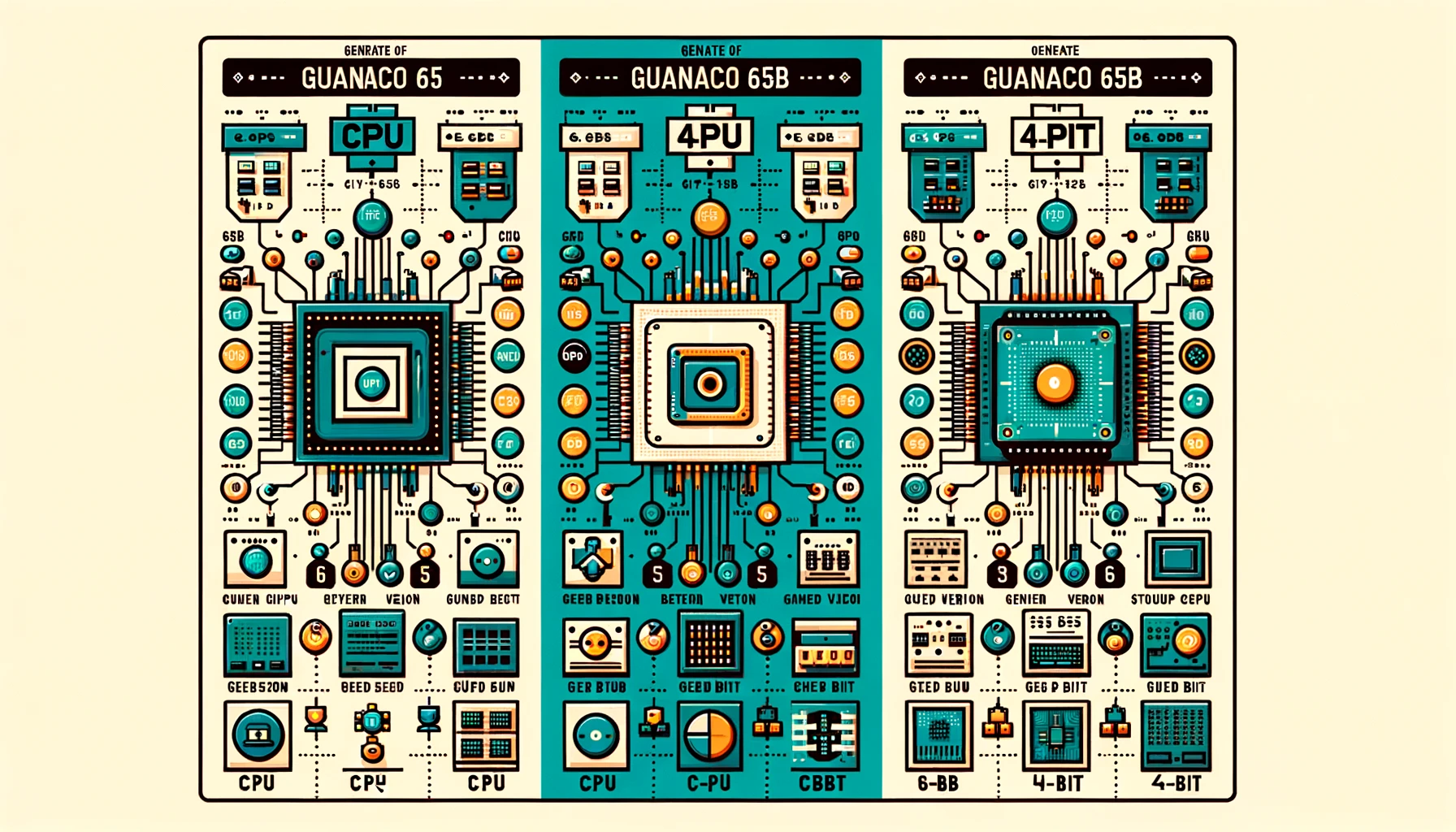

Guanaco 65B é um modelo de linguagem de ponta projetado para geração de texto. Não é apenas mais um modelo; é uma ferramenta flexível e poderosa que está disponível em várias versões para atender diferentes requisitos de hardware. Se você estiver trabalhando com uma CPU ou uma GPU de ponta, há um Guanaco 65B para você. Agora, vamos analisar essas versões.

Benchmarking do Guanaco 65B: Como ele se compara?

Quando se trata de avaliar o desempenho de modelos de linguagem como o Guanaco 65B, benchmarks são cruciais. Eles fornecem uma maneira padronizada de medir vários aspectos, como velocidade, precisão e capacidades gerais. No entanto, benchmarks não são a única forma de avaliar a eficácia de um modelo. Experiências de usuário e discussões da comunidade também oferecem insights valiosos.

Infelizmente, até o momento, o Guanaco 65B não está listado em nenhum ranking oficial. No entanto, vale a pena observar que:

- Treinamento Fino: Guanaco 65B é um dos poucos modelos bem ajustados disponíveis para a arquitetura 65B, o que o torna uma oferta única.

- Tarefas Especializadas: A compatibilidade do modelo com o QLoRA sugere que ele possa se destacar em tarefas baseadas em consultas, embora isso precise ser verificado empiricamente.

Vantagens do Guanaco 65B

Depois de usar o modelo, aqui estão as vantagens do Guanaco-65B:

- Velocidade e Eficiência: Alguns usuários acharam a versão 65B mais lenta, afetando sua usabilidade para determinadas tarefas.

- Roleplay e Consistência de Personagem: Os usuários observaram que os modelos Guanaco se destacam na manutenção da consistência dos personagens, especialmente quando cartões de personagem são usados.

- Geração de Texto: Os modelos Guanaco são elogiados por sua capacidade de gerar uma grande quantidade de texto ao mesmo tempo que entendem os prompts de forma eficaz.

Licenciamento Guanaco 65B

Antes de mergulhar no mundo do Guanaco 65B, é crucial entender os termos de licenciamento que acompanham cada versão. Diferentes licenças regem como você pode usar, modificar e distribuir o modelo.

- Licenças de Código Aberto: Algumas versões vêm com licenças de código aberto, permitindo o uso e a modificação gratuitos.

- Licenças Comerciais: Outras versões podem exigir uma licença comercial, especialmente se você planeja usar o modelo em um ambiente lucrativo.

Você pode conferir a página do Guanaco 65B no Huggingface aqui (opens in a new tab).

Um Guia Passo a Passo para Usar o Guanaco 65B

Navegar pelo mundo dos modelos de geração de texto pode ser assustador, especialmente se você é novo no campo. É por isso que preparamos um guia abrangente, passo a passo, para ajudá-lo a começar a utilizar o Guanaco 65B.

Passo 1. Baixe o Guanaco 65B

Antes de começar a gerar texto, você precisará baixar o modelo Guanaco 65B que melhor se adequa às suas necessidades. Veja como fazer:

- Visite o Repositório Hugging Face: Acesse o site do Hugging Face e pesquise pela versão Guanaco 65B que você deseja.

- Selecione o Modelo: Clique no modelo para ir para sua página dedicada.

- Copie o Nome do Modelo: Você encontrará o nome do modelo perto do topo da página. Copie-o para uso posterior.

Passo 2. Geração de Texto Usando o Guanaco 65B

Depois de baixar o modelo, é hora de escrever algum código. Abaixo está um trecho de código de exemplo em Python que demonstra como gerar texto usando o Guanaco 65B.

from transformers import AutoTokenizer, AutoModelForCausalLM

# Inicialize o tokenizer e o modelo

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# Prepare a entrada de texto

input_text = "Me conte uma piada."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# Gere o texto

output = model.generate(input_ids)

# Decode e imprima o texto gerado

print(tokenizer.decode(output[0], skip_special_tokens=True))Para executar este código, certifique-se de ter instalado a biblioteca transformers. Se você ainda não a possui instalada, pode instalá-la usando o pip:

pip install transformersE aí está - uma maneira simples, porém eficaz, de gerar texto usando o Guanaco 65B. Seja você estiver construindo um chatbot, um gerador de conteúdo ou qualquer outra aplicação baseada em texto, este modelo tem tudo o que você precisa.

Passo 3. Usando o Guanaco 65B com o Google Colab

Para aqueles que preferem uma abordagem mais prática, o Guanaco 65B pode ser facilmente implementado em notebooks do Google Colab. Isso permite que você experimente o modelo sem complicações de configuração.

- Facilidade de Uso: Basta importar o modelo para um notebook do Colab e começar a usá-lo.

- Colaboração: Os recursos de compartilhamento do Colab facilitam a colaboração em projetos.

Aqui está um trecho de código rápido para usar o Guanaco 65B no Google Colab:

# Trecho de código de exemplo para usar o Guanaco 65B no Google Colab

# Certifique-se de instalar a biblioteca transformers primeiro

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "What is AI?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Diferentes Versões do Guanaco 65B

Usando a Versão 4-Bit Guanaco 65B

Quando se trata de otimizar tanto o desempenho quanto a memória, a versão Guanaco 65B-GPTQ de 4 bits é revolucionária. Essa variante foi projetada para ser executada em GPUs, mas com uma reviravolta - ela usa quantização para reduzir o tamanho do modelo sem comprometer significativamente seu desempenho.

Recursos:

- Redução no Consumo de Memória: A quantização de 4 bits reduz drasticamente os requisitos de VRAM.

- Parâmetros de Quantização Múltiplos: Permite personalização com base em suas necessidades específicas.

- Desempenho Quase Original: Apesar do tamanho reduzido, o modelo mantém um alto nível de precisão.

Quem Deve Usar?

- Pesquisadores focados em aprendizado de máquina eficiente

- Desenvolvedores com recursos limitados de GPU

- Qualquer pessoa interessada em computação de borda

Aqui está um trecho de código de exemplo para usar o Guanaco 65B-GPTQ:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "What's the weather like?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Ao escolher a versão adequada do Guanaco 65B, você pode adaptar suas tarefas de geração de texto às capacidades do seu hardware. Seja com CPU, GPU ou a versão de 4 bits, cada uma oferece vantagens únicas que atendem a uma ampla gama de necessidades.

Use o Guanaco 65B com o QLoRA

Uma das características marcantes do Guanaco 65B é sua compatibilidade com o QLoRA, um modelo de linguagem baseado em consultas. Essa funcionalidade permite realizar tarefas de geração de texto mais específicas e direcionadas.

- Tarefas Baseadas em Consultas: Ideal para mecanismos de busca ou sistemas de recomendação.

- Precisão Aprimorada: A compatibilidade com o QLoRA garante uma geração de texto mais precisa e relevante.

Aqui está um trecho de código de exemplo para usar o Guanaco 65B com o QLoRA:

# Exemplo de código para usar o Guanaco 65B com QLoRA

# Observação: Este é um exemplo hipotético; a implementação real pode variar.

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "Qual é a capital da França?"

response = qlora_model.generate(query)

print(response)Conclusão: Por que o Guanaco 65B é Revolucionário

À medida que concluímos este guia abrangente, fica claro que o Guanaco 65B não é apenas mais um modelo de geração de texto. É uma ferramenta versátil, poderosa e altamente personalizável que atende a uma ampla variedade de aplicações e configurações de hardware. Desde suas diferentes versões até sua compatibilidade com modelos baseados em consultas como o QLoRA, o Guanaco 65B é verdadeiramente um revolucionário no campo da geração de texto.

Seja você um desenvolvedor experiente ou um entusiasta curioso, este modelo oferece algo para todos. Então, por que esperar? Aventure-se no mundo do Guanaco 65B e desbloqueie o futuro da geração de texto hoje mesmo!

Quer ficar atualizado com as últimas notícias do LLM? Confira o mais recente LLM leaderboard!