QA-LoRA: Um Guia para Ajustar Eficientemente Modelos de Linguagem de Grande Escala

Published on

Bem-vindo ao fascinante universo dos Modelos de Linguagem de Grande Escala (LLMs)! Essas gigantes computacionais são a base de inúmeras aplicações, desde chatbots e tradutores até geradores de conteúdo e sistemas de recomendação. No entanto, por mais maravilhosos que sejam, implantá-los não é nada fácil. Os requisitos computacionais e de memória podem ser impressionantes, muitas vezes exigindo hardware especializado e muita paciência.

É aí que o QA-LoRA entra em jogo. Este método inovador está mudando o jogo, tornando mais fácil e eficiente ajustar fino e implantar LLMs. Portanto, se você está enfrentando dificuldades com o ônus computacional dos LLMs ou procura uma maneira mais inteligente de ajustá-los, você está no lugar certo.

Por que o QA-LoRA é uma Mudança de Jogo para LLMs

Quer saber das últimas notícias sobre LLMs? Confira o ranking mais recente de LLMs!

O que exatamente é QA-LoRA e como ele difere do LoRA?

Antes de entrar em detalhes, vamos definir nosso tópico. QA-LoRA significa Adaptação a Baixo Rank com Consciência de Quantização. Em termos mais simples, é um método projetado para tornar o ajuste fino de Modelos de Linguagem de Grande Escala mais eficiente. Agora, você pode estar se perguntando, "O que é então o LoRA?" LoRA é a sigla para Adaptação a Baixo Rank, uma técnica que visa reduzir a complexidade de um modelo enquanto mantém sua performance. O que diferencia o QA-LoRA é seu aspecto de consciência da quantização.

- Quantização: Este é o processo de limitar os possíveis valores que uma função pode ter. No contexto dos LLMs, isso ajuda a reduzir o tamanho do modelo.

- Adaptação a Baixo Rank: Isso envolve aproximar os dados originais de alta dimensão por uma forma de menor dimensão, tornando o modelo computacionalmente mais barato.

Portanto, quando você combina esses dois aspectos - quantização e adaptação a baixo rank - você obtém o QA-LoRA, um método que não apenas reduz o tamanho do modelo, mas também o torna computacionalmente eficiente. Isso é crucial para implantar LLMs em dispositivos com recursos computacionais limitados.

O Método LoRA Simplificado

O método LoRA é essencialmente uma maneira de aproximar as matrizes de pesos originais de um LLM usando matrizes de baixo rank. Isso é um truque inteligente para reduzir os requisitos computacionais sem sacrificar muito a performance. No contexto do QA-LoRA, essa adaptação a baixo rank trabalha em conjunto com a quantização para fornecer um modelo ainda mais eficiente.

- Passo 1: Comece identificando as matrizes de pesos em seu LLM que são adequadas para a aproximação a baixo rank.

- Passo 2: Use técnicas matemáticas como Decomposição em Valores Singulares (SVD) para encontrar essas aproximações a baixo rank.

- Passo 3: Substitua as matrizes de pesos originais por essas aproximações a baixo rank.

- Passo 4: Aplique a quantização para reduzir ainda mais o tamanho do modelo.

Seguindo esses passos, você pode reduzir significativamente o ônus computacional do seu LLM, facilitando e acelerando a implantação.

Equilibrando Quantização e Adaptação no QA-LoRA

Um dos aspectos mais intrigantes do QA-LoRA é como ele equilibra os graus de liberdade entre quantização e adaptação. Esse equilíbrio é crucial porque permite que o QA-LoRA seja eficiente e preciso. Muita quantização pode levar à perda de precisão, enquanto muita adaptação pode tornar o modelo computacionalmente caro. O QA-LoRA encontra o ponto ideal entre esses dois.

- Eficiência: Usando quantização, o QA-LoRA reduz o tamanho do modelo, tornando-o mais rápido para carregar e executar.

- Precisão: Através da adaptação a baixo rank, ele mantém a performance do modelo, garantindo que você não precise comprometer a qualidade.

Como podemos ver, o QA-LoRA oferece uma abordagem equilibrada que o torna um método de referência para quem deseja ajustar fino e implantar Modelos de Linguagem de Grande Escala de forma eficiente. Ele combina o melhor dos dois mundos - eficiência e precisão -, tornando-se uma mudança de jogo no campo da aprendizagem de máquina.

Como Começar com o QA-LoRA

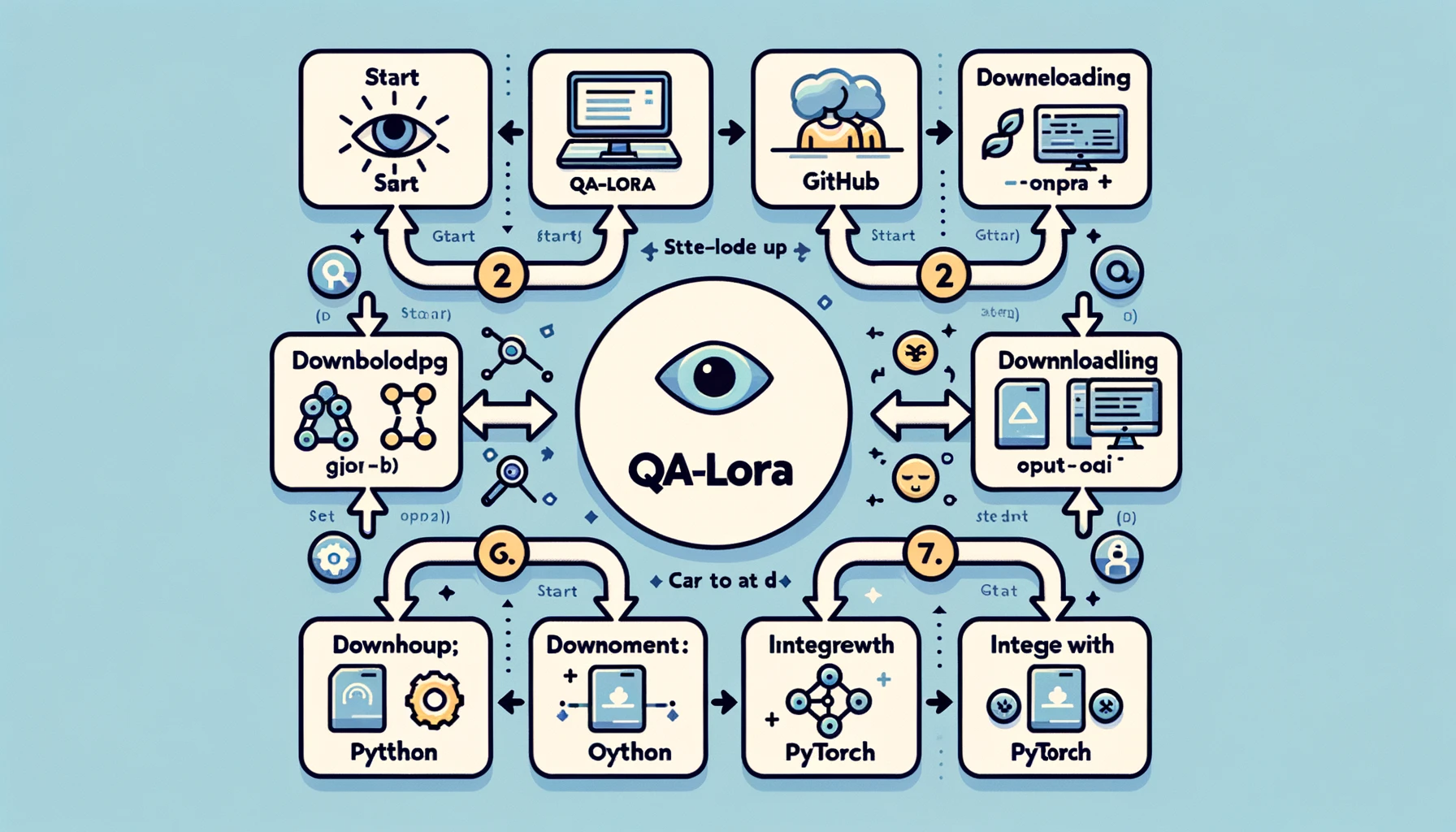

Configurando seu Ambiente para o QA-LoRA

Antes de mergulhar no mundo do QA-LoRA, você precisará configurar seu ambiente de desenvolvimento. Este é um passo crucial, pois a configuração correta pode tornar sua jornada mais tranquila e eficiente. Veja como fazer isso:

- Passo 1: Instalar o Python: Se você ainda não tiver, instale o Python em seu sistema. Recomenda-se o uso do Python 3.x.

- Passo 2: Configurar um Ambiente Virtual: É sempre uma boa ideia trabalhar em um ambiente virtual para evitar conflitos de dependência. Você pode usar ferramentas como

venvoucondapara isso. - Passo 3: Instalar Bibliotecas Necessárias: Você precisará de bibliotecas como o PyTorch, NumPy e outras. Use o pip ou o conda para instalá-las.

- Passo 4: Clone o Repositório do GitHub: Existe um repositório do GitHub dedicado ao QA-LoRA. Clone-o em sua máquina local para obter o código de exemplo e outros recursos.

Seguindo esses passos, você terá um ambiente de desenvolvimento robusto pronto para implementar o QA-LoRA. Essa configuração garante que você tenha todas as ferramentas e bibliotecas necessárias para tornar sua implementação o mais tranquila possível.

Implementando o QA-LoRA: Um Passo a Passo

Agora que o seu ambiente está configurado, vamos partir para a implementação real. Aqui é onde se coloca a mão na massa, e você verá o QA-LoRA em ação. Aqui está um guia passo a passo para implementar o QA-LoRA:

-

Passo 1: Importar Bibliotecas: Comece importando todas as bibliotecas necessárias. Isso normalmente inclui PyTorch para o modelo e NumPy para operações numéricas.

import torch import numpy as np -

Passo 2: Carregar seu Modelo: Carregue o Modelo de Linguagem Grande que você deseja refinar. Isso pode ser um modelo pré-treinado ou um modelo que você treinou.

model = torch.load('seu_modelo.pth') -

Passo 3: Identificar Matrizes de Pesos: Identifique as matrizes de pesos em seu modelo que são adequadas para uma aproximação de baixa posto. Geralmente, essas são as camadas totalmente conectadas.

-

Passo 4: Aplicar Aproximação por Baixo Posto: Use técnicas como a Decomposição em Valores Singulares (SVD) para aproximar essas matrizes de pesos.

u, s, v = torch.svd(matriz_de_pesos) -

Passo 5: Substituir Matrizes Originais: Substitua as matrizes de pesos originais pelas aproximações de baixo posto.

matriz_aproximada = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

Passo 6: Aplicar Quantização: Por fim, aplique a quantização para reduzir ainda mais o tamanho do modelo. Isso pode ser feito usando as utilidades de quantização do PyTorch.

modelo_quantizado = torch.quantization.quantize_dynamic(model)

Seguindo este guia detalhado, você terá uma implementação funcional do QA-LoRA. Isso não apenas tornará seu modelo mais eficiente, mas também manterá seu desempenho, proporcionando o melhor dos dois mundos.

Os Próximos Passos na Pesquisa do QA-LoRA

Embora o QA-LoRA já seja um método inovador, vale ressaltar que a pesquisa nessa área está longe de terminar. O campo está pronto para a inovação e existem várias possibilidades de melhorias. Por exemplo, a pesquisa atual está focada em tornar o QA-LoRA ainda mais eficiente sem comprometer a precisão. Isso envolve ajustar o equilíbrio entre a quantização e a adaptação de baixo posto, entre outras coisas.

- Otimizando a Quantização: Uma área de foco é otimizar o processo de quantização para garantir uma perda mínima de informação.

- Aproximação Adaptativa de Baixo Posto: Outra possibilidade é tornar o processo de aproximação de baixo posto adaptativo, permitindo que o modelo se ajuste com base na tarefa em questão.

Esses esforços de pesquisa contínuos visam tornar o QA-LoRA ainda mais robusto e versátil, garantindo que ele permaneça o método preferido para refinar Modelos de Linguagem Grande de forma eficiente.

Você pode ler mais sobre o artigo QA-LoRA aqui (opens in a new tab).

Concluindo: Por que o QA-LoRA é Importante

Reflexões Finais sobre o QA-LoRA e seu Impacto

Ao chegarmos ao final deste guia abrangente, é importante dar um passo atrás e apreciar o poder transformador do QA-LoRA. Este método não é apenas mais um jargão técnico lançado no mar sempre em expansão dos algoritmos de aprendizado de máquina. É um avanço fundamental que aborda desafios do mundo real ao implantar Modelos de Linguagem Grande.

-

Eficiência: Uma das vantagens mais convincentes do QA-LoRA é sua eficiência. Ao combinar quantização e adaptação de baixo posto, ele reduz significativamente os requisitos computacionais e de memória dos LLMs. Isso é uma vantagem para desenvolvedores e organizações que desejam implantar esses modelos em grande escala ou em dispositivos com recursos limitados.

-

Precisão: O QA-LoRA não compromete o desempenho. Apesar de sua eficiência, o método mantém a precisão do modelo, garantindo resultados de alta qualidade. Esse equilíbrio entre eficiência e precisão é o que diferencia o QA-LoRA de outros métodos de refinamento.

-

Versatilidade: O método é versátil e pode ser aplicado a vários tipos de Modelos de Linguagem Grande. Seja trabalhando em processamento de linguagem natural, visão computacional ou qualquer outro domínio, o QA-LoRA pode ser adaptado às suas necessidades.

-

Facilidade de Implementação: Com código prontamente disponível e uma comunidade solidária, implementar o QA-LoRA nunca foi tão fácil. Mesmo se você não for um especialista em aprendizado de máquina, o método é acessível e simples de aplicar.

Em resumo, o QA-LoRA é mais do que apenas um método de refinamento; é uma mudança de paradigma na forma como abordamos a implantação de Modelos de Linguagem Grande. Ele oferece uma maneira equilibrada, eficiente e eficaz de aproximar esses gigantes computacionais das aplicações práticas do mundo real. Se você trabalha no campo de aprendizado de máquina ou está intrigado com o potencial dos Modelos de Linguagem Grande, o QA-LoRA é um tópico que você não pode ignorar.

Conclusão

O mundo dos Modelos de Linguagem Grande é empolgante, mas cheio de desafios, especialmente quando se trata de implantação. O QA-LoRA surge como uma luz no fim do túnel, oferecendo um método equilibrado e eficiente para refinar esses modelos. Desde suas complexidades técnicas até sua implementação prática, o QA-LoRA é um testemunho do que pode ser alcançado quando eficiência e precisão andam de mãos dadas.

Portanto, ao embarcar em seu próximo projeto envolvendo Modelos de Linguagem Grande, lembre-se de que o QA-LoRA é seu companheiro confiável para refino eficiente e eficaz. Experimente e participe da revolução que está estabelecendo novos padrões no mundo do aprendizado de máquina.

Quer saber as últimas notícias sobre Modelos de Linguagem Grande? Confira a última classificação de MLL!