Guanaco 65B: GPT-4に挑むオープンソースの微調整可能なチャットボット

Published on

人工知能の領域では、テキスト生成モデルがさまざまなアプリケーション、チャットボットからコンテンツ作成までの基盤となっています。Guanaco 65Bは、その能力によって注目を浴びている革新的なモデルです。しかし、なぜそれが特別なのでしょうか?この包括的なガイドでは、Guanaco 65Bの詳細な説明、さまざまなバージョン、互換性の機能、さらには手に入れる方法までを探っていきます。

開発者やデータサイエンティスト、AI愛好家であれば、Guanaco 65Bの理解は分野での次の大きな飛躍になるかもしれません。テキストの生成、データの分析、新しいアプリケーションの開発を目指している場合でも、このガイドは究極のリソースとなるでしょう。それでは、始めましょう!

Guanaco 65Bとは何か、なぜ気にする必要があるのか?

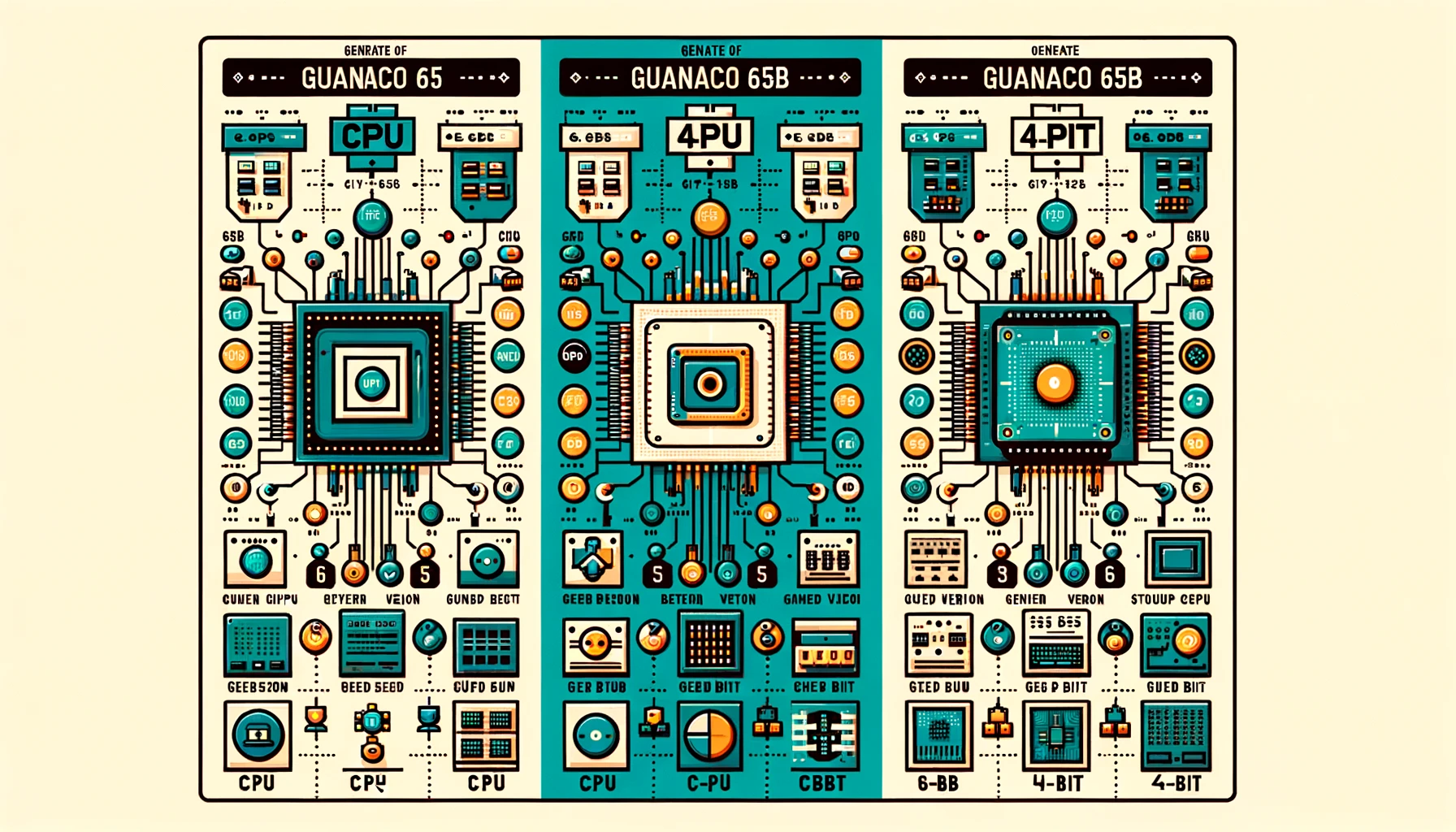

Guanaco 65Bは、テキスト生成のために設計された最新の言語モデルです。ただのモデルではありません。さまざまなハードウェア要件に合わせてバージョンが用意された柔軟で強力なツールです。CPUまたはハイエンドのGPUで作業している場合でも、Guanaco 65Bは適しています。さて、これらのバージョンを詳しく見ていきましょう。

Guanaco 65Bのベンチマーク:どれくらい優れているのか?

Guanaco 65Bのような言語モデルの性能を評価する際には、ベンチマークが重要です。ベンチマークは、速度、精度、総合的な機能など、さまざまな側面を測定するための標準的な方法を提供します。ただし、モデルの効果を評価するための唯一の手段ではありません。ユーザーの経験やコミュニティの議論も貴重な洞察を提供します。

残念ながら、現時点ではGuanaco 65Bは公式のリーダーボードには掲載されていません。ただし、次のことに注意する価値があります。

- 微調整: Guanaco 65Bは、65Bアーキテクチャ向けの微調整モデルのほんの一部であるため、ユニークなオファリングとなっています。

- 特化タスク: QLoRAとの互換性から、このモデルはクエリベースのタスクで優れた性能を発揮する可能性がありますが、これについては経験的に検証する必要があります。

Guanaco 65Bの利点

モデルを使用した後、Guanaco-65Bの利点は次のとおりです:

- 速度と効率: 一部のユーザーは、65Bバージョンが遅く、特定のタスクには利用しづらいと感じていました。

- 役割とキャラクターの一貫性: キャラクターカードを使用すると、Guanacoモデルはキャラクターの一貫性を保つ能力に優れているとユーザーは指摘しています。

- テキスト生成: Guanacoモデルは、問いかけを効果的に理解しながら多くのテキストを生成する能力に定評があります。

Guanaco 65Bのライセンス

Guanaco 65Bの世界に入る前に、各バージョンに付属するライセンス条項を理解することが重要です。異なるライセンスがモデルの使用、変更、配布をどのように制約するかを規定しています。

- オープンソースライセンス: 一部のバージョンはオープンソースライセンスで提供されており、無料で使用および変更することができます。

- 営利ライセンス: 他のバージョンは商業ライセンスを必要とする場合があります。特に、モデルを営利目的で使用する場合には必要です。

Guanaco 65BのHuggingfaceページはこちら (opens in a new tab)でご確認いただけます。

Guanaco 65Bの使用方法のステップバイステップガイド

テキスト生成モデルの世界をナビゲートすることは、特にこの分野が初めての場合、難しいかもしれません。そこで、Guanaco 65Bを使い始めるための包括的なステップバイステップガイドを用意しました。

ステップ1. Guanaco 65Bのダウンロード

テキストを生成する前に、必要に応じたGuanaco 65Bモデルをダウンロードする必要があります。以下に手順を示します。

- Hugging Faceリポジトリにアクセス: Hugging Faceのウェブサイトにアクセスし、欲しいGuanaco 65Bのバージョンを検索します。

- モデルの選択: モデルをクリックして、専用ページに移動します。

- モデル名をコピー: ページの上部付近にモデル名が表示されています。後で使用するためにコピーしておきます。

ステップ2. Guanaco 65Bを使ったテキスト生成

モデルをダウンロードしたら、コードを書く準備ができました。以下はPythonのサンプルコードの一部で、Guanaco 65Bを使ってテキストを生成する方法を示しています。

from transformers import AutoTokenizer, AutoModelForCausalLM

# トークナイザーとモデルを初期化する

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

# テキストの入力を準備する

input_text = "Tell me a joke."

input_ids = tokenizer.encode(input_text, return_tensors="pt")

# テキストを生成する

output = model.generate(input_ids)

# 生成されたテキストをデコードして表示する

print(tokenizer.decode(output[0], skip_special_tokens=True))このコードを実行するには、transformersライブラリがインストールされていることを確認してください。そうでない場合は、pipを使用してインストールできます。

pip install transformersこれで、Guanaco 65Bを使用してテキストを生成するためのシンプルかつ効果的な方法ができました。チャットボット、コンテンツ生成、その他のテキストベースのアプリケーションを構築する際に便利です。

ステップ3. Google ColabでGuanaco 65Bを使用する

より実践的なアプローチを好む方には、Guanaco 65BをGoogle Colabノートブックで簡単に実装することができます。セットアップの手間をかけずにモデルを試すことができます。

- 使いやすさ: モデルをColabノートブックにインポートして、すぐに使用することができます。

- 協力: Colabの共有機能を使用すると、プロジェクトの共同作業が簡単に行えます。

Google ColabでGuanaco 65Bを使用するための簡単なコードスニペットを以下に示します:

# Google ColabでGuanaco 65Bを使用するためのサンプルコード

# まず、transformersライブラリをインストールする必要があります

!pip install transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B")

input_text = "What is AI?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))Guanaco 65Bの異なるバージョン

4ビットGuanaco 65Bバージョンの使用

パフォーマンスとメモリの最適化の両方を実現するために、4ビットGuanaco 65B-GPTQバージョンはゲームチェンジャーです。このバリアントは、GPU上で実行されるように設計されていますが、重要なポイントは、パフォーマンスを犠牲にすることなく、モデルのサイズを削減するために量子化を使用することです。

特徴:

- メモリ使用量の削減: 4ビットの量子化によりVRAMの要件が大幅に削減されます。

- 複数の量子化パラメータ: 特定のニーズに基づいてカスタマイズが可能です。

- ほぼオリジナルのパフォーマンス: サイズが削減されているにもかかわらず、モデルは高い精度を維持します。

利用者:

- 効率的な機械学習に焦点を当てた研究者

- 限られたGPUリソースを持つ開発者

- エッジコンピューティングに興味がある人々

Guanaco 65B-GPTQを使用するサンプルコードスニペットを以下に示します:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("TheBloke/guanaco-65B-GPTQ")

model = AutoModelForCausalLM.from_pretrained("TheBloke/guanaco-65B-GPTQ")

input_text = "天気はどうですか?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids)

print(tokenizer.decode(output[0], skip_special_tokens=True))適切なバージョンのGuanaco 65Bを選択することで、ハードウェアの能力に合わせてテキスト生成タスクをカスタマイズすることができます。CPU、GPU、または4ビットバージョンのいずれかを使用することで、さまざまなニーズに対応した独自の利点を得ることができます。

QLoRAを使用したGuanaco 65Bの利用

Guanaco 65Bの特徴の1つは、QLoRAとの互換性です。QLoRAは、クエリに基づいた言語モデルで、より具体的かつターゲット指向のテキスト生成タスクを実行することができます。

- クエリに基づくタスク: 検索エンジンや推薦システムに最適です。

- 高精度: QLoRAの互換性により、より正確で関連性のあるテキスト生成が可能です。

Guanaco 65BをQLoRAと組み合わせて使用するサンプルコードスニペットを以下に示します:

# Guanaco 65BをQLoRAと組み合わせて使用するためのサンプルコード

# 注意: これは架空の例です。実際の実装は異なる場合があります。

from qlora import QLoRATransformer

qlora_model = QLoRATransformer("TheBloke/guanaco-65B")

query = "フランスの首都はどこですか?"

response = qlora_model.generate(query)

print(response)結論: Guanaco 65Bがゲームチェンジャーである理由

この包括的なガイドを終えるにあたり、明らかにGuanaco 65Bは単なるテキスト生成モデルではありません。これは、幅広いアプリケーションやハードウェア構成に対応する、多目的でパワフルかつ高度にカスタマイズ可能なツールです。異なるバージョンやQLoRAのようなクエリベースのモデルとの互換性から分かるように、Guanaco 65Bはテキスト生成の分野において本当にゲームチェンジャーです。

経験豊富な開発者や興味津々の愛好家、どのようなバックグラウンドの人でも、このモデルは誰にとっても魅力的なものを提供しています。なぜ待つのですか?Guanaco 65Bの世界に飛び込み、テキスト生成の未来を今日から解き放ちましょう!

最新のLLMニュースを知りたいですか?最新のLLMリーダーボードをチェックしてください!