QA-LoRA: 大規模言語モデルの効率的なファインチューニングのガイド

Published on

大規模言語モデル(Large Language Models, LLMs)の魅力的な世界へようこそ!これらの計算機の巨人は、チャットボットや翻訳機、コンテンツ生成装置、および推薦システムなど、さまざまなアプリケーションの基盤となっています。しかし、驚くべきことに、これらを展開することは簡単なことではありません。計算とメモリの要件は驚異的であり、しばしば専用のハードウェアと多くの忍耐が必要です。

それがQA-LoRAの出番です。この画期的な手法は、LLMのファインチューニングと展開を容易で効率的にすることで、ゲームを変えています。ですので、LLMの計算的な負荷に苦しんでいたり、よりスマートなファインチューニング方法を探している場合は、正しい場所に来ました。

QA-LoRAがLLMにおいてゲームチェンジャーとなる理由

最新のLLMニュースを知りたいですか?最新のLLMリーダーボードをチェックしてください!

QA-LoRAとは何か、そしてLoRAとの違いは何か

細部に立ち入る前に、対象を明確にしましょう。QA-LoRAはQuantization-Aware Low-Rank Adaptationの略です。簡単に言えば、これは大規模言語モデルのファインチューニングを効率的にするための手法です。では、そもそもLoRAとは何でしょうか?LoRAはLow-Rank Adaptationの略で、モデルの複雑さを減らしながら性能を維持しようとする技術です。QA-LoRAの特徴は、その「Quantization-Aware(量子化に対応した)」の側面です。

- Quantization(量子化):これは関数が取り得る可能な値を制約するプロセスです。LLMの文脈では、モデルのサイズを減らすのに役立ちます。

- Low-Rank Adaptation(低ランク適応):これは、元の高次元データを低次元フォームで近似することで、モデルの計算コストを低減する手法です。

ですので、これら2つの要素、量子化と低ランク適応を組み合わせると、モデルのサイズを削減し、計算的に効率的にする手法であるQA-LoRAが完成します。これは、計算リソースが限られたデバイスにLLMを展開する際に非常に重要な要素です。

LoRAメソッドの概要

LoRAメソッドは、基本的にはLLMの元の重み行列を低ランク行列を使用して近似する方法です。これは、パフォーマンスを犠牲にすることなく、計算要件を削減するためのスマートなテクニックです。QA-LoRAの文脈では、この低ランク適応が量子化とも連携して、より効率的なモデルを提供します。

- ステップ1:低ランク近似に適したLLMの重み行列を特定します。

- ステップ2:特異値分解(SVD)などの数学的手法を使用して、これらの低ランク近似を見つけます。

- ステップ3:元の重み行列をこれらの低ランク近似で置き換えます。

- ステップ4:さらにモデルのサイズを減らすために量子化を適用します。

これらの手順に従うことで、LLMの計算負荷を著しく減らすことができ、展開が容易かつ迅速になります。

QA-LoRAにおける量子化と適応のバランス

QA-LoRAの最も興味深い側面の1つは、量子化と適応の自由度のバランスです。このバランスは非常に重要であり、QA-LoRAを効率的かつ正確にするための鍵となります。量子化が過剰に行われると精度が低下する可能性があり、適応が過剰に行われるとモデルが計算的に高コストになる可能性があります。QA-LoRAは、この2つの面の間で適切なバランスを見つけます。

- 効率性:量子化を使用することで、QA-LoRAはモデルのサイズを減らし、読み込みと実行が高速になります。

- 正確性:低ランク適応により、モデルのパフォーマンスが維持され、品質に妥協する必要がないことを保証します。

以上より、QA-LoRAは効率性と正確性の両方を併せ持つバランスの取れた手法であり、大規模言語モデルのフィンチューニングと展開においてゲームチェンジャーとなります。QA-LoRAは、機械学習の分野で最高の効率と正確性を組み合わせることで、頼りになる手法となっています。

QA-LoRAの始め方

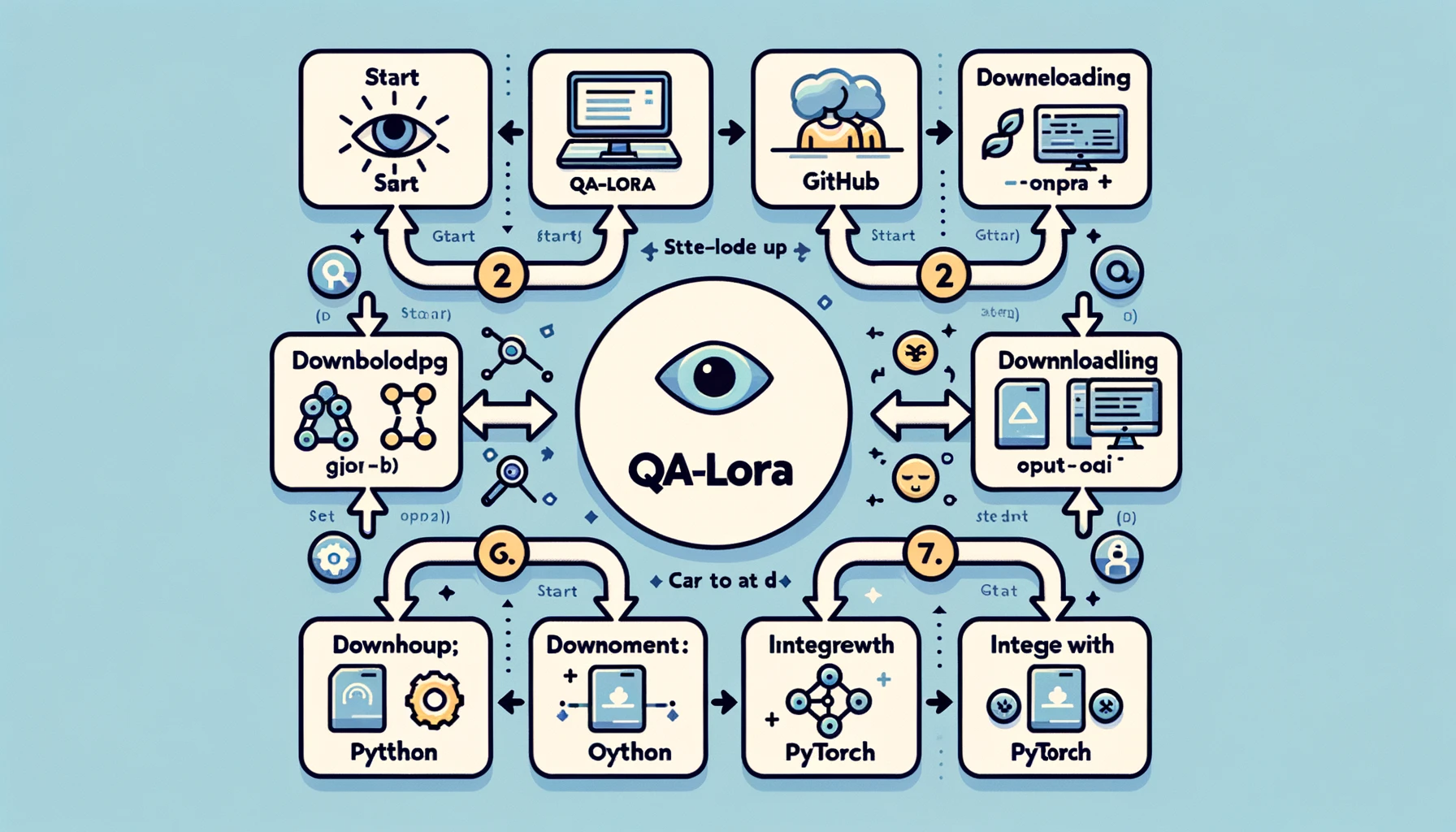

QA-LoRAの環境設定

QA-LoRAの世界に入る前に、開発環境を設定する必要があります。正しい設定が行われると、実装がスムーズかつ効率的になるため、このステップが非常に重要です。以下の手順に従って環境を設定してください。

- ステップ1: Pythonのインストール:まだインストールしていない場合は、システムにPythonをインストールしてください。Python 3.xが推奨されています。

- ステップ2: 仮想環境の設定:依存関係の競合を回避するために、常に仮想環境で作業することをおすすめします。

venvやcondaなどのツールを使用できます。 - ステップ3: 必要なライブラリのインストール:PyTorch、NumPyなどのライブラリが必要です。pipやcondaを使用してこれらをインストールしてください。

- ステップ4: GitHubリポジトリのクローン:QA-LoRAに専用のGitHubリポジトリがあります。サンプルコードやその他のリソースを取得するために、これをローカルマシンにクローンしてください。

これらの手順を守ることで、QA-LoRAの実装に必要な頑健な開発環境が整い、実装をスムーズに行うためのツールやライブラリをすべて揃えることができます。

QA-LoRAの実装:手順の概要

環境が整ったら、実際の実装に移りましょう。これがQA-LoRAの実際のアクションを確認できる部分です。以下は、QA-LoRAの実装のステップバイステップガイドです。

-

ステップ1: ライブラリのインポート:必要なライブラリをすべてインポートすることから始めます。通常、これにはモデルのためのPyTorchと数値演算のためのNumPyが含まれます。

import torch import numpy as np

以上の手順に従うことで、LLMの計算負荷を大幅に削減し、展開を容易で迅速にすることができます。

-

ステップ 2: モデルの読み込み: ファインチューニングしたい大規模言語モデルを読み込みます。これは事前に学習されたモデルまたは自分でトレーニングしたモデルのいずれかです。

model = torch.load('your_model.pth') -

ステップ 3: 重み行列の特定: モデル内の低ランク近似に適した重み行列を特定します。通常、これは完全に接続された層です。

-

ステップ 4: 低ランク近似の適用: 特異値分解(SVD)などの技術を使用してこれらの重み行列を近似します。

u, s, v = torch.svd(weight_matrix) -

ステップ 5: 元の行列の置換: 低ランク近似で元の重み行列を置換します。

approx_matrix = torch.mm(torch.mm(u, torch.diag(s)), v.t()) -

ステップ 6: 量子化の適用: 最後に、モデルのサイズをさらに削減するために量子化を適用します。これはPyTorchの量子化ユーティリティを使用して行うことができます。

quantized_model = torch.quantization.quantize_dynamic(model)

この詳細な手順に従うことで、QA-LoRAの動作する実装ができます。これにより、モデルの効率が向上し、パフォーマンスが維持されるため、ベストな結果が得られます。

QA-LoRA 研究の次のステップ

QA-LoRAはすでに画期的な手法ですが、この領域における研究はまだまだ進行中です。イノベーションの余地があり、さらなる改善のためのいくつかのアプローチがあります。たとえば、現在の研究は、精度を損なうことなくQA-LoRAをさらに効率的にすることに焦点を当てています。これには量子化と低ランク適応のバランスの微調整などが含まれます。

- 量子化の最適化: 一つの焦点は、情報の最小限の損失を保証するために量子化プロセスを最適化することです。

- 適応的な低ランク近似:別の方法は、低ランク近似プロセスを適応的にすることで、モデルがタスクに応じて自身を調整できるようにすることです。

これらの継続的な研究の取り組みは、QA-LoRAをより堅牢で多目的なものにすることを目指しています。これにより、大規模言語モデルの効率的なファインチューニング手法としてQA-LoRAが確立されます。

QA-LoRA の論文について詳しくはこちら (opens in a new tab)を参照してください。

まとめ:QA-LoRA の重要性

QA-LoRA とその影響についての最終的な考察

この包括的なガイドの終わりに近づくにつれて、QA-LoRA の変革力に一歩下がって立ち止まり、その重要性を認識することが重要です。この方法は、機械学習アルゴリズムの広がりという海にさらなる技術的な専門用語として投げ込まれたものではありません。これは、大規模言語モデルのデプロイメントにおける現実世界の課題に取り組む画期的な進歩です。

-

効率性: QA-LoRA の最も魅力的な利点の一つは、その効率性です。量子化と低ランク適応を組み合わせることで、LLM の計算およびメモリ要件を大幅に削減します。これは、リソースが限られたデバイスや大規模な尺度でこれらのモデルを展開することを目指す開発者や組織にとって利点となります。

-

精度: QA-LoRA はパフォーマンスを損なうことはありません。効率性にもかかわらず、この手法はモデルの精度を保持し、高品質な結果を提供します。この効率性と精度のバランスこそが、QA-LoRA を他のファインチューニング手法と区別する要素です。

-

多目的性: この手法は多目的であり、さまざまな種類の大規模言語モデルに適用することができます。自然言語処理、コンピュータビジョンなど、どのドメインでも、QA-LoRA を自分のニーズに合わせて適応させることができます。

-

実装の容易さ: 使用可能なコードとサポートのあるコミュニティにより、QA-LoRA の実装は今まで以上に容易になりました。機械学習のエキスパートでなくても、この手法はアクセス可能で直感的に適用できます。

要約すると、QA-LoRA は単なるファインチューニング手法以上のものであり、大規模言語モデルのデプロイメントにアプローチする方法のパラダイムシフトです。バランスのとれた、効率的かつ効果的な方法で、これらの計算の巨人を現実的な実世界アプリケーションに近づけることができます。もし機械学習の分野にいるか、大規模言語モデルのポテンシャルに興味があるのであれば、QA-LoRA は無視できないトピックです。

結論

大規模言語モデルの世界は刺激的ですが、デプロイメントの際にはさまざまな課題が存在します。QA-LoRA は、これらのモデルをファインチューニングするためのバランスの取れた効率的な手法として、希望の光となります。技術的な詳細から実際の実装まで、QA-LoRA は効率的で効果的なファインチューニングのための信頼できる相棒です。

次の大規模言語モデルを用いたプロジェクトに取り組む際には、QA-LoRA を利用して効率的で効果的なファインチューニングを試してみてください。これは、機械学習の世界で新たな基準を設定し続ける革命に参加することです。

最新のLLMニュースを知りたいですか?最新のLLM leaderboardをチェックしてください!